Kürzlich war ich bei einer Veranstaltung zum Thema seltene Krankheiten in der Schweiz – dem Co-Pilot Workshop „Wenn Eltern und Fachpersonen Partner werden“ von OrphanHealthcare.

OrphanHealthcare unterstützt Kinder mit seltenen Krankheiten und deren Familien.

Wie in vielen Bereichen spielte auch hier KI eine wachsende Rolle. Seit fast zwei Jahren betreibt der Förderverein einen Chatbot Seltene Krankheiten oder Rare Diseases genannt Cuba’s Academy.

Im Workshop sprachen betroffene Eltern und Fachleute. In Gruppen wurden Checklisten erarbeitet, Vertrauen in KI-Resultate diskutiert und Erfahrungen geteilt. Für Eltern und medizinische Expertinnen war klar: KI kann helfen, wenn die Daten stimmen.

Das Bewusstsein, dass KI im Gesundheitswesen und bei Orphan Drugs Fortschritte macht, war bei allen spürbar. Die Chancen und Herausforderungen sind jedoch immer noch enorm.

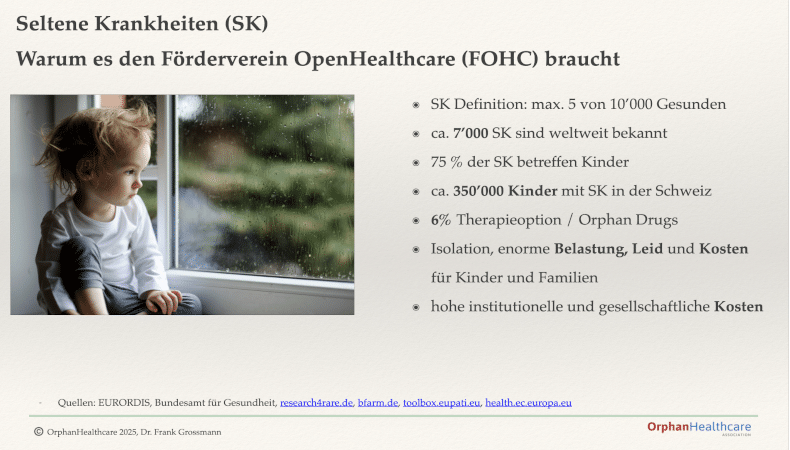

Was sind seltene Krankheiten?

Seltene Krankheiten (SK) betreffen in der Schweiz rund 350’000 Kinder. Eine Krankheit gilt als selten, wenn weniger als 5 von 10’000 Menschen betroffen sind (European Commission, Bundesamt für Gesundheit).

Viele Krankheiten bleiben lange unerkannt oder werden falsch diagnostiziert. Das verursacht Leid, hohe Kosten und Belastungen für Familien.

Nur etwa 6 % der seltenen Krankheiten haben eine zugelassene Therapie. Forschung, Datenzugang und internationale Kooperationen sind entscheidend.

Der Förderverein OpenHealthcare (FOHC) setzt hier an. Er fördert Forschung und Vernetzung, um Versorgungslücken zu schliessen und langfristig Gesundheitskosten zu senken.

Prävention, Früherkennung und digitale Lösungen sind der Schlüssel für ein effizienteres Health Care Management.

Die Schweiz hat, wie das Bundesamt für Gesundheit festhält, noch Nachholbedarf in diesem Bereich.

1️⃣ Seltene Krankheiten Schweiz: Kann KI helfen?

Seit Turing’s Artikel von 1950 ist Artificial Intelligence ein zentrales Thema. Large Language Models (LLMs) verarbeiten grosse Datenmengen und erzeugen Antworten nach statistischer Wahrscheinlichkeit.

Gemäss Russel & Norvig (2010) gibt es vier Arten von KI: menschliches Denken, rationales Denken, menschliches Handeln und rationales Handeln. Rationales Handeln spielt bei Generativer KI eine Rolle – maschinelles Lernen, das neue Daten erzeugt. KI kann Muster in Daten erkennen und dadurch Diagnose und Behandlung unterstützen.

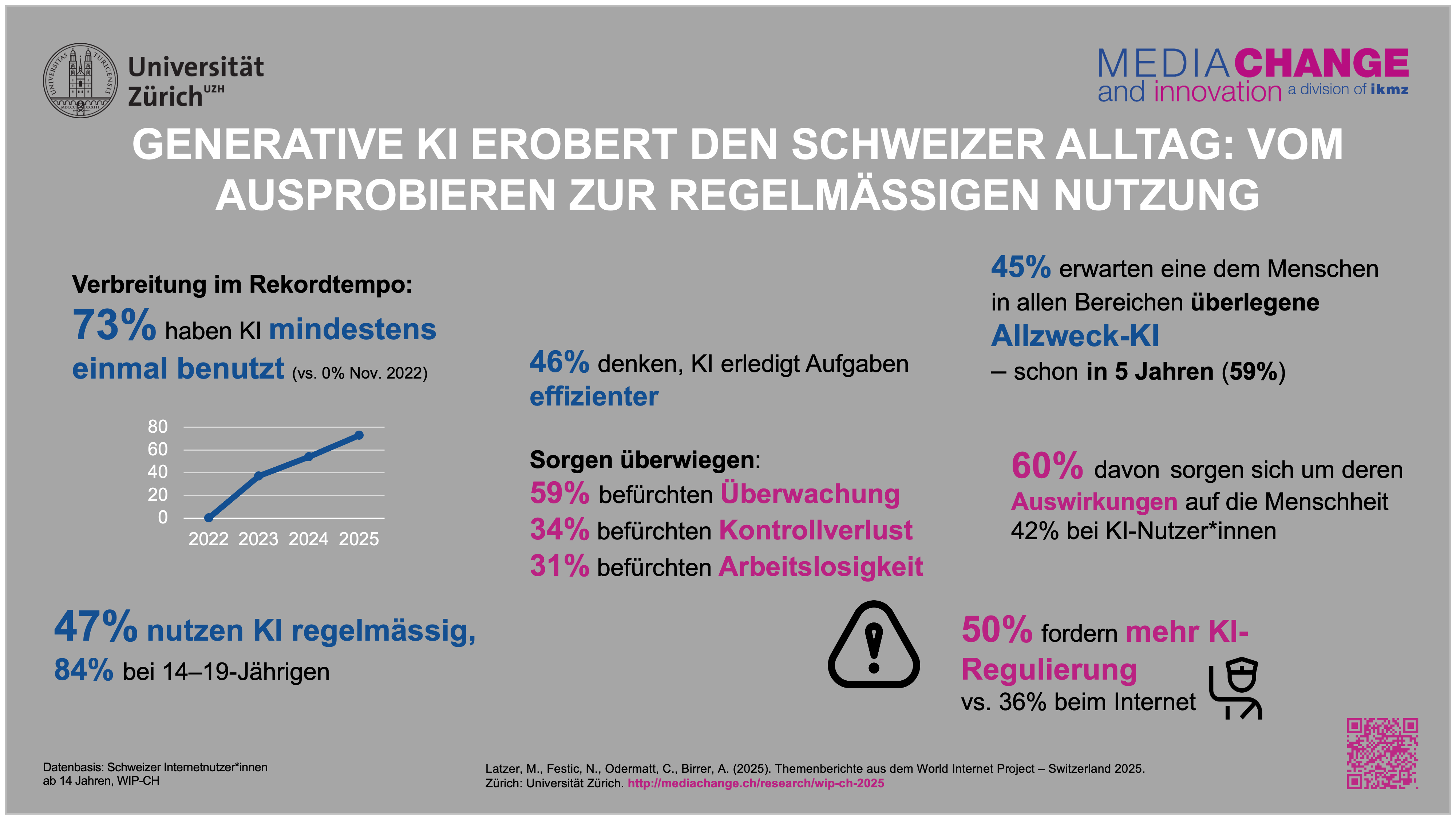

Heute kennen 97 % der Schweizer Bevölkerung generative KI wie ChatGPT, Gemini oder Claude. 73 % der Schweizerinnen und Schweizer haben diese Chatbots bereits mindestens einmal genutzt – ein internationaler Spitzenwert. Siehe mehr Infos zur Studie sowie Download der Studie (Grafik unten)

Generative KI in der Schweiz 2025: 97 % der Bevölkerung kennt Chatbots wie ChatGPT, Gemini oder Claude. 73 % haben sie mindestens einmal genutzt. Diese hohe Nutzung unterstreicht die Bedeutung spezialisierter Gesundheits-Chatbots wie Cuba’s Academy von OrphanHealthcare. Quelle: Universität Zürich – WIP-CH

Die hohe Verbreitung zeigt: Auch bei spezialisierten Anwendungen wie dem Cuba’s Academy Chatbot profitieren Eltern und Fachpersonen von der wachsenden Vertrautheit mit KI-Systemen. Diagnosen können schneller überprüft, relevante Studien gefunden und der Austausch zwischen Familien und medizinischem Personal unterstützt werden.

Im Workshop „Co-Pilot – Wenn Eltern und Fachpersonen Partner werden“ sprachen betroffene Eltern und Fachleute. Checklisten wurden erarbeitet, Vertrauen in KI-Resultate diskutiert und Erfahrungen geteilt. Für Eltern und medizinische Expertinnen war klar: KI kann helfen, wenn die Daten stimmen.

Das Bewusstsein, dass KI im Gesundheitswesen und bei Orphan Drugs Fortschritte macht, war bei allen spürbar. Die Chancen und Herausforderungen bleiben jedoch enorm.

2️⃣ Seltene Krankheiten Schweiz: Datenqualität entscheidet bei der KI

Die Achillesferse der KI sind die Daten. Nur korrekte Daten führen zu verlässlichen Ergebnissen. Schon in den 1990er Jahren zeigte Raymond Panko, dass bis zu 10 % der Zellen in Kalkulationstabellen Fehler enthielten. Solche Ungenauigkeiten mindern die Verlässlichkeit – auch bei KI.

🇦🇺 Beispiel Australien – Consulting: Das australische Bundesamt für Beschäftigung und Arbeitsbeziehungen (Department of Employment and Workplace Relations) wies 2024 Deloitte nach, dass ein Bericht mit KI-Elementen Fehler enthielt.

KI-Halluzinationen führten zu falschen Zitierungen und der Erwähnung von nicht existierenden Studien von Forschenden der Universitäten Sydney und Lund (Schweden).

Auch im Gesundheitswesen sind solche Fehler möglich (5 Fehlerquellen für Algorithmen). Besonders kritisch ist das, wenn es um Leben geht.

🇳🇱 Beispiel Niederlande – Wahlen: Die Datenschutzbehörde führte ein Experiment durch, bei dem sie ChatGPT, Mistral, Grok und Gemini um Wahlberatung für die Parlamentswahlen vom 29. Oktober 2025 bat.

Zwei Parteien – die Allianz aus Grünen und Sozialdemokraten sowie die rechtsextreme Partei für die Freiheit – wurden unabhängig von den Präferenzen der Nutzer:innen immer wieder vorgeschlagen [Autoriteit Persoonsgegevens, 21. Oktober 2025]. Die Zentrumspartei D66 lag dabei auffällig oft an erster Stelle.

Die niederländische Datenschutzbehörde warnte, dass die Empfehlungen der Chatbots „unzuverlässig und eindeutig voreingenommen“ seien. „Chatbots verfehlen ihr Ziel“, erklärte die stellvertretende Vorsitzende Monique Verdier.

Modelle, die nach dem 2. August 2025 veröffentlicht wurden, könnten gemäss EU AI Act als „Systeme mit systemischem Risiko“ eingestuft werden, wenn sie eine Rechenleistung von über 10²⁵ FLOPs erreichen. Chatbots, die Wahlentscheidungen beeinflussen, würden dann unter die Kategorie high risk fallen – mit deutlich strengeren Vorschriften.

KI-Unternehmen erklärten zwar, sie unterstützten keine Wahlempfehlungen – doch in 99,9 % der 21 000 Testabfragen antworteten die Systeme trotzdem mit konkreten Parteiempfehlungen.

Ob bei Wahlen oder im Gesundheitswesen – die Lehre ist dieselbe: Wenn Daten verzerrt oder Bewertungslogiken intransparent sind, kann KI bestehende Ungleichheiten nicht abbauen, sondern verstärken. Genau das zeigt auch das nächste Beispiel aus dem Gesundheitsbereich.

3️⃣ Algorithmen und Fairness: Transparenz

Das National Liver Offering Scheme (NLOS) im Vereinigten Königreich (UK) soll Entscheidungen bei Organtransplantationen fairer machen. Jedes Mal, wenn eine Spenderleber verfügbar wird, berechnet der Algorithmus eine Punktzahl für alle Patient:innen auf der Warteliste.

Die Punktzahl basiert auf 28 Variablen – 7 vom Spender und 21 vom Empfänger. Auf dieser Grundlage entscheidet das System, wer an die Spitze der Liste kommt.

Doch Studien wie Attia et al. (2023) zeigen: Algorithmen sind nicht neutral (siehe auch unseren ersten Bericht zu diesem Thema). Der Algorithmus benachteiligt jüngere Patient:innen auf der Warteliste durch:

- Altersverzerrung: Unter 45-Jährige erhalten schlechtere Bewertungen, obwohl sie bessere Überlebenschancen haben.

- Fehlerhaftes Ziel: Bewertet wird nur die Sterblichkeit nach fünf Jahren, nicht die Lebensqualität.

- Unrealistischer Vergleich: Die Todesrate auf der Warteliste wird künstlich ausgeglichen.

Der Zweck solcher Algorithmen ist Fairness – doch wenn Daten oder Gewichtungen verzerrt sind, entstehen neue Ungerechtigkeiten. Transparenz bleibt der Schlüssel.

Mehr dazu im Financial Times Bericht und im Lancet Kommentar.

4️⃣ Gesundheits-Chatbots und seltene Krankheiten: Wie gute Usability Vertrauen schafft

Eine aktuelle Studie des Oxford Internet Institute zeigt beunruhigende Mängel. Nutzer haben Schwierigkeiten, Gesundheits-Chatbots effektiv zu verwenden.

1.298 Teilnehmer nahmen an einer randomisierten, kontrollierten Studie teil. Sie sollten Chatbots für 10 medizinische Szenarien nutzen, darunter akute Kopfschmerzen, Knochenbrüche und Lungenentzündung.

Die Aufgabe: den Gesundheitszustand identifizieren und eine empfohlene Vorgehensweise finden. Drei Chatbots wurden getestet: GPT-4o von OpenAI, Llama 3 von Meta und Command R+ von Cohere.

Direkt eingegebene Szenarien wurden von den Chatbots zu 94,9 % korrekt identifiziert. Die Modelle funktionierten also technisch einwandfrei.

Die Teilnehmer lieferten jedoch unvollständige Eingaben. Die Chatbots interpretierten sie oft falsch. Die Erfolgsquote sank auf nur 34,5 %.

Notiz: Die Eltern werden zu Experten um ihre Kinder mit seltener Krankhgeit zu unterstützen

Schlimmer noch: Eine Kontrollgruppe, die keine Chatbots nutzte, sondern normale Suchmaschinen, schnitt in einigen Szenarien besser ab.

Die Ergebnisse bedeuten nicht, dass Chatbots für Gesundheitsratschläge unbrauchbar sind. Sie zeigen aber: Designer müssen stärker berücksichtigen, wie normale Menschen ihre Dienste nutzen.

Oft wird angenommen, dass Fehlfunktionen die Schuld der Nutzer sind. Besser ist, die technologischen Fähigkeiten der Menschen zu verstehen und das Design darauf abzustimmen. Usability (Nutzbarkeit) und Usefulness (Nützlichkeit) können durch die Beobachtung der Nutzung eines Chatbots geprüft und optimiert werden.

Dies ist umso wichtiger, da auch eine Studie die weit verbreitete Annahme widerlegte, dass Nutzer:innen KI mehr Vertrauen in die Resultate geben, wenn sie besser verstehen, wie das Modell arbeitet oder Prognosen erstellt.

Der grössere Einflussfaktor in Sachen AI Trust war das Ergebnis-Feedback, also ob die Vorhersagen der KI richtig oder falsch waren. Beispiele sind die Wettervorhersagen mit KI wie Google Cast oder aber eine korrekte Diagnose des Chatbot dank den richtigen Prompts.

🇨🇭Beispiel: – Chatbot Seltene Krankheiten: Der Chatbot Cuba’s Academy – Rare Diseases – Seltene Krankheiten Schweiz wurde gezielt mit Hilfe von Nutzerfeedback weiterentwickelt.

Die Art der Nutzung und typische Fragestellungen von Eltern und Fachpersonen wurden berücksichtigt, um die Resultate für Nutzer:innen zu optimieren.

Mehr zur Verwendung von KI und Data Analytics lesen Sie hier.

KI, KMU, Strategie und Trends – kompakt erklärt.

Jetzt Newsletter abonnieren und keine Insights mehr verpassen!

📌 Zusammenfassung und Ausblick

Seltene Krankheiten erfordern Geduld, Wissen und Zusammenarbeit. KI kann Eltern und Fachpersonen unterstützen, ersetzt aber nicht die Empathie und Erfahrung, die Betroffene brauchen.

Ebenfalls muss die Arbeit der KI Systeme auf deren Korrektheit überprüft werden. Ansonsten z.B. Halluzination einem einen Streich spielen kann (siehe Deloitte Beispiel oben).

Gesundheits-Chatbots haben enormes Potenzial, doch nur, wenn Nutzer (Patienten, Familien, Gesundheitspersonal) die Systeme korrekt bedienen. Schulungen, intuitive Interfaces und Unterstützung durch Fachpersonen sind entscheidend.

Ergebnis-Feedback über seltene Krankheiten oder Rare Diseases schafft Trust in AI / Vertrauen in KI (5 Faktoren zur Sicherung von AI Trust – KI Vertrauen). Nur vertrauenswürdige KI bringt die Unterstützung für Kinder mit seltenen Krankheiten und deren Familien welche diese dringend brauchen.

KI kann Eltern und Fachpersonen bei seltenen Krankheiten unterstützen – wenn Technologie, Menschlichkeit und Datenqualität zusammenkommen. Erfahren Sie mehr bei OrphanHealthcare.

Über den Autor:

Der Autor ist Vize-Präsident und Mitgründer des Fördervereins OpenHealthcare (FOHC)

und engagiert sich für Familien mit seltenen Krankheiten in der Schweiz.

Jede Spende hilft Familien mit seltenen Krankheiten in der Schweiz.

📜 DrKPI CyTRAP AI-Verantwortlichkeitserklärung

Dieser Beitrag wurde mit KI-Unterstützung erstellt. Eigene Recherchen, Erfahrungen und Entwürfe bildeten die Grundlage.

KI diente als Schreibassistenz, nicht als Ghostwriter. Keine Fakten wurden erfunden, keine Quellen konstruiert.

Der Autor hat alle Inhalte geprüft und verantwortet die Aussagen. Das ist für uns: ethisch und transparent mit KI arbeiten.

13 Antworten

Dein Beispiel aus den Niederlanden kann man noch ergänzen.

Einige der Herausforderungen, denen große Sprachmodelle in Bezug auf ihre Genauigkeit gegenüberstehen, lassen sich dadurch erklären, dass sie zeitlich „eingefroren” sind.

Das heisst, sie wurden anhand von Datensätzen trainiert, die möglicherweise nicht aktualisiert wurden.

Bots die ich vor den niederländischen Wahlen getestet habe, bezogen sich auf Parteiprogramme aus dem vorherigen Wahlkampf. Sie wussten nicht, dass vorgezogene Wahlen stattfinden würden.

Beispielsweise auf die Frage nach den Terminen der Wahlen in den Niederlanden, antwortete Le Chat von Mistral, dass diese erst 2027 stattfinden würden.

Siehe mein Artikel in der FT Marietje Schaake. 6. November. 2025 Opinion

Das „Einfrieren“ von KI-Modellen bis zum nächsten Update ist tatsächlich ein Problem – besonders, wenn dadurch veraltete oder falsche Informationen an Nutzer:innen gelangen.

Das erklärt auch, warum Nachrichtenthemen oder aktuelle Ereignisse für Sprachmodelle besonders schwierig bleiben. Während sich

– „Evergreen“-Inhalte wie Kochrezepte oder Checklisten gut generieren lassen,

– versagen KI-Systeme oft bei zeitkritischen oder kontextabhängigen Themen.

Gerade im Gesundheitsbereich oder bei seltenen Krankheiten kann das schwerwiegende Folgen haben.

PS: Mistral hat inzwischen einen Vertrag mit der Nachrichtenagentur AFP. Dadurch werden geprüfte Meldungen automatisch integriert – ein wichtiger Schritt hin zu aktuelleren und verlässlicheren Antworten.

Urs

Die U.S. Food and Drug Administration (US-amerikanische Lebensmittel- und Arzneimittelbehörde FDA) hielt am 6. November ihre erste öffentliche Anhörung ab, um zu erörtern, ob KI-gestützte Therapie-Chatbots als Medizinprodukte reguliert werden sollten.

„Sind KI-Therapie-Chatbots sicher in der Anwendung?“ ist wohl die Frage

Die U.S. Food and Drug Administration (US-amerikanische Lebensmittel- und Arzneimittelbehörde FDA) hat da was sehr Wichtiges angestossen.

Einige Entwickler haben angesichts der zunehmenden Kontrolle die Vermarktung ihrer Apps als Therapie-Chatbots eingestellt.

Auch immer mehr Bundesstaaten erwägen ein Verbot von Therapie-Chatbots, da ihnen im Gegensaz zu menschlichen Therapeuten eine Zulassung fehlt.

Fragen zur Wirksamkeit von Therapie-Chatbots bleiben weiterhin offen.

➡️ Dokument der FDA zu den Besprechungen vom 6. Nov. 2025 – pdf Download

Eine Therapie via Chatbot anzubieten ohne Approbation ist deshalb fragwürdig, weil der Chatbot diese nicht hat.

Deshalb kann und sollte er nur unterstützen und Fragen beantworten und immer darauf hinweisen, dass der Patient sich noch an eine Fachperson wenden soll.

Danke, Frank, für diesen wichtigen Hinweis.

Du hast völlig recht – eine Therapie über einen Chatbot anzubieten wäre ohne Approbation problematisch.

Der #OrphanHealthcare Chatbot ist jedoch genau deshalb kein Therapie-Tool, sondern ein unterstützendes Informationssystem wie du im Kommentar erwähnst.

Er hilft Eltern und Fachpersonen, relevante Hinweise, Studien und Erklärungen schneller zu finden – nicht Diagnosen zu stellen oder Behandlungen vorzuschlagen.

Damit folgt Cuba’s Academy dem Prinzip der KI-Assistenz, nicht der KI-Autorität:

– unterstützen,

– aufklären und

– Orientierung bieten,

Der Nutzer wird auch darauf hinweisen, medizinische Entscheidungen mit Fachpersonen abzustimmen.

#AIethics #DigitalHealth #RareDiseases #OrphanDrugs

„KI-Halluzinationen führten zu falschen Zitierungen und der Erwähnung von nicht existierenden Studien von Forschenden der Universitäten Sydney und Lund (Schweden).

Auch im Gesundheitswesen sind solche Fehler möglich (5 Fehlerquellen für Algorithmen). Besonders kritisch ist das, wenn es um Leben geht.“

Die einzig sinnvolle Lösung, bzw. der sinnvolle Umgang mit KI im Gesundheitswesen ist (und wird hoffentlich bleiben) die ‚Kooperation‘ von KI und Mensch.

KI-Diagnosen müssen/sollten immer vom Menschen überprüft werden.

UND:

„Die Teilnehmer lieferten jedoch unvollständige Eingaben. Die Chatbots interpretierten sie oft falsch. Die Erfolgsquote sank auf nur 34,5 %.“

Fazit: Das korrekte Prompting ist und bleibt essentiell!

Liebe Mine, danke für deinen Kommentar! 💬

Du weist auf zwei wichtige Punkte hin:

1. Kooperation Mensch & KI 🤝: KI sollte immer als Advisor agieren. Ohne diese Zusammenarbeit müssten wir der KI zu 100 % vertrauen – was riskant wäre. Zuverlässigkeit (#Reliability) ist nicht nur ein technischer Aspekt, sondern ein zentraler Vertrauensanker ✅.

Mehr dazu unter Datenqualität, Reliabilität & Validität.

#KI #Gesundheit #OrphanHealthcare #SelteneKrankheiten #AIethics

2. Korrektes Prompting ✍️

Absolut richtig – die Qualität der Eingaben entscheidet mit über die Qualität der KI-Ergebnisse. Dies ist ein zusätzliche Herausforderung neben der Qualität der Informationen Daten im KI-Modell (siehe Kommentar von Marietje zu den Wahlen in den Niederlanden),

Aber wie wir beide ja wissen: Wer Prompts erstellt, sollte nicht nur wissen, wie man einen Chatbot nutzt, sondern auch Grundkenntnisse in der Fachmaterie 🧑⚕️ haben. Nur so kann die KI sinnvoll als Assistenz eingesetzt werden.

Beispielsweise zur Verbesserung von Formulierungen oder Grammatik, ohne dass sie selbst die Expert:innen-Rolle übernimmt.

Die Kombination aus fachlichem Know-how, sorgfältigem Prompting und menschlicher Kontrolle ist der Schlüssel für sinnvollen KI-Einsatz im Gesundheitswesen 💖.

#KI #Gesundheit #OrphanHealthcare #SelteneKrankheiten #AIethics

Urs

Chatbots können auch zum Problem werden.

Im August dieses Jahres reichten die Eltern des 16-jährigen Adam Raine in Kalifornien eine Klage ein, in der sie behaupteten, dass die „konversationelle Herzlichkeit” vom Chatbot ihren Sohn zum Selbstmord getrieben habe.

Liebe Veronika,

danke für deinen Kommentar und den wichtigen Hinweis auf die aktuellen Sicherheitsinitiativen von OpenAI. 🙏

Das von dir erwähnte Update zur Benutzersicherheit (September 2025) ist ein bedeutender Schritt, um die Sicherheit von Jugendlichen gegenüber der reinen Privatsphäre zu priorisieren.

Besonders wichtig ist auch der Plan, ein „Age Prediction System“ einzuführen, um riskante oder unangemessene Inhalte besser zu filtern.

Diese Entwicklungen stehen im direkten Zusammenhang mit dem Thema unseres Blogartikels:

Wie KI-Systeme Verantwortung übernehmen (oder eben nicht).

Während KI-Technologien immer leistungsfähiger werden, bleibt die zentrale Frage, wer letztlich die Verantwortung für Fehlinformationen oder unangemessene Antworten trägt – die Entwickler:innen oder die Nutzenden selbst?

#KI #Sicherheit #Jugendschutz #Ethik #Verantwortung #OpenAI #OrphanHealthcare

Ergänzend dazu:

Die Diskussion um KI-Sicherheit zeigt, wie entscheidend Transparenz und menschliche Kontrolle bleiben.

Gerade im Gesundheitswesen – wie auch Mine Dal in ihrem Kommentar betont hat – darf KI nur als Assistenzsystem fungieren, nicht als autonome Autorität.

Das gilt genauso für Systeme, die mit sensiblen Personengruppen wie Jugendlichen interagieren.

KI sollte helfen, Wissen zugänglich zu machen und Risiken früh zu erkennen, aber entscheidend bleibt immer der Mensch im Loop – ob Ärztin, Lehrer oder Elternteil.

Kooperation statt Blindvertrauen ist der Schlüssel.

#AIethics #SafetyByDesign #HumanInTheLoop #DigitalHealth #OrphanHealthcare

Die Klageschrift der Eltern von Adam Raine ist hier zu finden:

Raine v. OpenAI – Complaint