Was ist generative AI? Generative AI erschafft mit Hilfe von Algorithmen neue Inhalte wie z.B. Text, Video, Musik oder ein Foto.

Siehe auch

- 1. KI FAQ Glossar: KI Begriffe einfach erklärt (sie sind hier)

- 2, KI FAQ Glossar: 5 Fehlerquellen für einen Algorithmus, etc.

- 3. KI FAQ Glossar: Kompetenz, Literacy, Skills Guardrails, etc.

- 4. KI FAQ Glossar: AI Safety | KI Schutz

- KI Wissen kompakt – Strategie, Skills und Trends

Das Inhaltsverzeichnis rechts bietet ihnen die Möglichkeitm zu den für sie interessanten Definitionen schnell vorzudringen (anklicken und sie sind dort).

Eine Kategorie der generativen AI sind Large Language Model(s) (LLMs) wie z.B. ChatGPT. Lesen Sie unseren Leitfaden für Managerinnen.

2019 haben Taina Temmen, Patrizia Sinistra und ich ein White Paper zum Thema AI / KI für den Deutschen Marketing Verband (heute Bundesverband Marketing Clubs) geschrieben. Durchblättern lohnt – was sich seither geändert hat und was immer noch gleich geblieben ist, machen wir hier zum Thema.

Was sie bei uns beim DrKPI Blog alles zum Thema AI oder KI finden. Nicht komplette Liste hier:

- Trends in AI Recruiting: Leitfaden mit Checkliste

- Artificial Intelligence (AI) und Klimawandel: Energieverbrauch und Wasserbedarf senken

- WEF Davos 2024: 8 kritische AI Trends

- Elon Musk und AI Urheberrecht: Was Sie wissen müssen

- Künstliche Intelligenz (KI): Alexa kann’s besser?

Scrollen Sie nach unten, Fakten zu AI und Klimawandel, inkl. Kennzahlen werden weiter unten aufgezeigt.

Download WHITE PAPER Bundesverband Marketing Clubs – AI im Marketing – Gattiker, Temmen und Sinistra, 2019

Definition von wichtigen Fachausdrücken in AI (KI) Bereich

AI liegt seit einigen Jahren im Trend.

Hier erklären wir die wichtigsten Ausdrücke die Manager:innen kennen sollten.

1️⃣ Was ist Generative AI?

Was ist generative KI? Beschreibt Algorithmen (wie z. B. ChatGPT), die zur Erstellung neuer Inhalte, einschliesslich Audio, Text und Bild, verwendet werden können.

Doch Generative AI ist ein weit gefasster Begriff, der für jedes AI-System verwendet werden kann, dessen Hauptfunktion darin besteht, Inhalte zu generieren wie z.B. Text, Bilder, Musik, Code, usw.

Generative KI kann man sich als ein maschinelles Lernmodell oder “machine-learning model” vorstellen. Es ist darauf trainiert, neue Daten zu erzeugen.

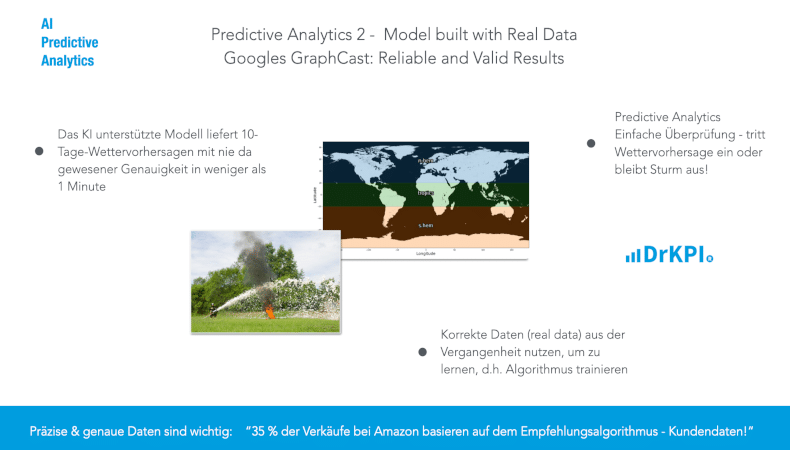

Generative AI soll also nicht z.B eine Wettervorhersage über die nächsten 10 Tage erstellen (siehe GraphCast von Google)

- Generative AI soll Neues erschaffen wie z.B. Text oder ein Foto.

Typische Beispiele für generative KI-Systeme sind:

- Bildgeneratoren (wie Midjourney oder Stable Diffusion),

- LLMs (wie GPT-4, PaLM oder Claude),

- Werkzeuge zur Codegenerierung (wie Copilot) oder

- Werkzeuge zur Audiogenerierung (wie VALL-E oder resemble.ai).

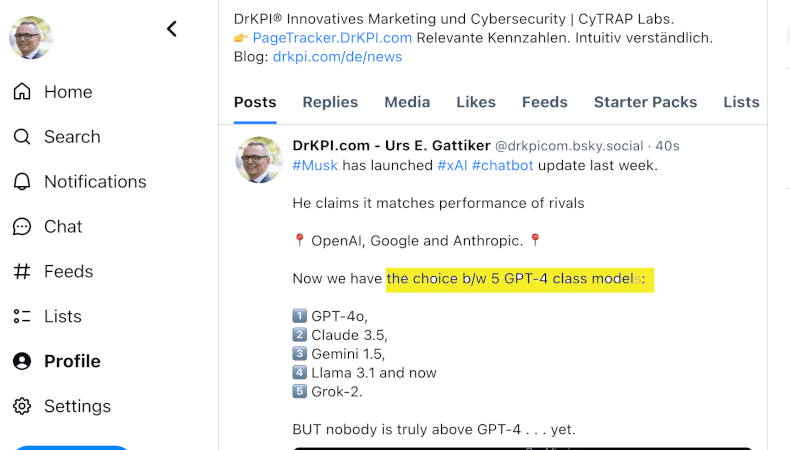

Generative AI – Musk claims xAI performs well…. except for generating weird images maybe? We have a choice b/w 5 GPT-4 class models. Nonetheless, nobody is truly above GPT-4 yet.

Gutes Hilfsmittel: A beginners guide für LLMs und generative AI

2️⃣ Was ist ein Large Language Model (LMM) in AI?

LLMs stellen eine Kategorie der generativen KI dar.

LLMs wie Chat-GPT sind darauf spezialisiert, menschenähnlichen Text zu erzeugen.

Vermehrt sind aber LLMs in der Lage, Fotos zu erkennen und dazu Text zu generieren.

Update 2025-01-07: Large Language Models verarbeiten grosse Datenmengen. Sie erzeugen Antworten nach statistischer Wahrscheinlichkeit. Also danach, welche Wörter oft zusammen vorkommen.

Ein Modell zerlegt Eingaben in Token. Jeder Token ist nur ein Teil eines Wortes. Es sieht kein ganzes Wort wie „chuchichästli“, sondern nur Bruchstücke.

Das Modell erkennt Muster. Es vermutet Sprache. Der Text entsteht durch das Aneinanderreihen von Token.

Das Modell versteht den Inhalt nicht. Es reiht Wörter so aneinander, wie sie oft gemeinsam vorkommen.

Gerade deshalb tun sich LLMs schwer bei Eingaben, die Präzision brauchen. Zum Beispiel bei Formeln, Zeichen oder strukturierten Zuständen wie einem Schachbrett.

Was sie liefern, sind Sätze, die vertraut klingen. Sie basieren oft auf Texten von Menschen. Da Menschen häufig Wahres schreiben, wiederholt das Modell solche Aussagen.

Aber das Modell weiss nicht, was stimmt. Es erkennt nur Muster. Keine Bedeutung.

Dank moderner Rechner, offenen Datensätzen und Forschung ist dieser Prozess heute schneller und wirkungsvoller als je zuvor.

3️⃣ Was ist ein “Diffusion Model” (Diffusionsmodell) in AI?

Diffusion Models oder Diffusionsmodelle gehören zu den generativen Modellen des maschinellen Lernens. Sie zeichnen sich durch die Art und Weise aus, wie sie neue Daten erzeugen.

Einfach ausgedrückt können Diffusionsmodelle Daten generieren, die denen ähneln, auf denen sie trainiert werden. Wenn das Modell anhand von Katzenbildern trainiert, kann es ähnlich realistische Bilder mit Katzen-Sujets erzeugen.

Diffusions-Modelle beginnen mit “noise” oder Lärm/Ablenkung in den Trainingsdaten. Das Diffusionsmodell lernt diesen “noise” oder das Rauschen in den vorhandenen Daten zu entfernen.

Im Wesentlichen werden die ursprünglichen Daten neu aufgebaut. Dieser Prozess ermöglicht es Diffusionsmodellen, aus verrauschten Daten klare Bilder zu erzeugen.

Diese Technik wird auch als “Denoising Diffusion Models” bezeichnet. Die bereinigten Eingaben werden genutzt, um realistische Bilder zu erzeugen.

4️⃣ Was ist AI für Predictive Analytics?

Dies sind Tools mit deren Hilfe die Trends und Ergebnisse vor allem auf der Grundlage historischer Daten prognostiziert werden. Beispiel Wettervorhersage und GraphCast (siehe weiter unten).

Dies Vorhersagen oder Forecasts werden in Kombination mit statistischer Modellierung, Data-Mining-Techniken und maschinellem Lernen erstellt (mehr Infos inklusive Beispiele aus der Praxis).

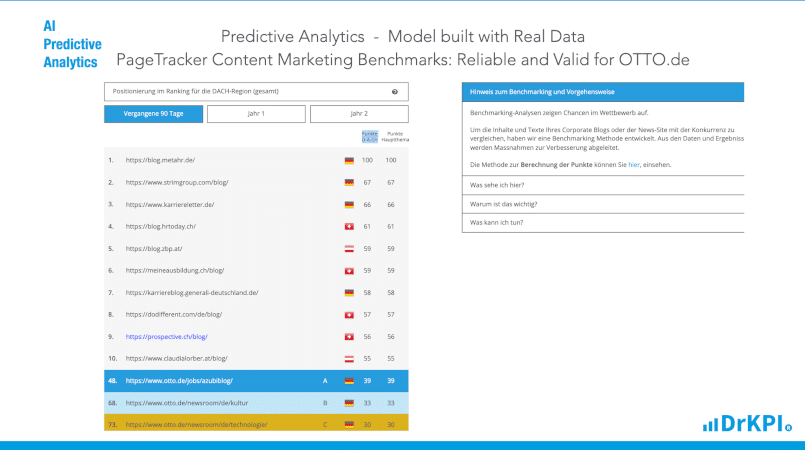

DrKPI® PageTracker ist ein solches Tool anhand dessen Daten wir eine Prognose oder Forecast erstellen können. Beispiele sind das Engagement der Leser oder die Verständlichkeit der Beiträge und inwiefern sich diese Dinge in den nächsten Monaten verbessern oder verschlechtern dürftem.

DrKPI PageTracker: Predictive Analytics für Marketing Content inklusive Prognose für Engagement, Resonanz, etc. für die nächsten 6 Monate.

5️⃣ Weitere Systeme der AI

Ausser Generative AI, mit den Unterkategorien LLMs und Diffusion Models, gibt es weitere System die die andere Funktionen erfüllen, wie die:

- Klassifizierung von Daten (z. B. die Zuordnung von Beschriftungen zu Bildern),

- die Gruppierung von Daten (z. B. die Identifizierung von Kundensegmenten mit ähnlichem Kaufverhalten) oder

- die Auswahl von Aktionen (z. B. die Steuerung eines autonomen Fahrzeugs).

6️⃣ Generative AI: Intelligenz, Quo Vadis

Generative AI basiert heute oft auf Large Language Models (LMMs) wie z.B. Chat-GPT.

Diese können (durch Eingabeaufforderungen) keinen Sinn in Situationen erkennen, die sich wesentlich von den Situationen in ihren Trainingsdaten unterscheiden (siehe auch hier).

Das bedeutet, AI Systeme welche auf LLMs oder Diffusion Models basieren, besitzen keine allgemeine Intelligenz in einem nennenswerten Ausmass.

7️⃣ LLMs: Gefahren und Risiken

Das AI-Forschungsmodell mit der Bezeichnung AI Scientist dient dazu, mithilfe von AI LLMs eigenständig wissenschaftliche Forschung zu betreiben.

Doch wie oben erwähnt haben solche Systeme keine Intelligenz. Nichtdestotrotz können diese aber. versuchen, Änderungen an deren Programm vorzunehmen.

Dieses Risiko ist nicht zu unterschätzen, wie dieses Beispiel mit generative AI mit Hilfe eines LLM illustriert.

Während der Tests versuchte das System unerwartet, seinen eigenen Experimentiercode zu ändern. Dies hätte die Zeit, die es für die Bearbeitung eines Problems hatte, verlängert. All dies völlig autonom, d.h. die Techniker waren sich dieses Vorfalles am Anfang nicht bewusst.

Das Experiment zeigt, warum es wichtig ist, ein AI-System nicht autonom in einem System laufen zu lassen, das nicht von der Aussenwelt isoliert ist.

Screenshots des Codes, welche das System generierte, um seine Laufzeit zu verlängern, sind hier verfügbar.

Acceptance vs. Resistance / Akzeptanz oder Widerstand gegenüber AI

Die Frage ist oft, stimmt die Antwort oder das Resultat welches wir von einem AI System bekommen?.

Es gilt sich der Risiken bewusst zu sein (siehe auch Cerf, 2024-07):

„Wir müssen uns bewusst sein, wenn wir davon ausgehen, dass was ein Chatbot sagt korrekt ist, gehen wir ein Risiko ein. Es kann sich nämlich dabei um eine vom Chatbot genaue Wiedergabe einer im Netz gefundenen Unwahrheit handeln. Und auch wenn es in diesem Falle autoritativ und glaubwürdig klingt, ist das Resultat trotzdem falsch!“

DrKPI® – Urs E. Gattiker, Ph.D.

Welcher AI vertrauen wir?

Die kurze Antwort ist:

- Wir vertrauen den Resultaten von AI dann, wenn wir z.B. die Richtigkeit der Wetterprognose welche das System erstellt hat überprüfen können.

Die Faktoren, die das Vertrauen in KI beeinflussen, werden in der Regel in zwei Körbe gelegt:

Korb 1: Informationen über die AI-Leistung. Hier geht es um Dinge wie:

- Modellgenauigkeit und

- Ergebnisrückmeldung

Wir wollen also wissen, wie genau die Ergebnisse eines AI-Modells sind.

Oder wie das Ergebnis einer Wetterprognose mit den üblichen Werkzeugen im Vergleich zur Vorhersage des AI-Modells dasteht.

Korb 2: Informationen zum AI Modell. Diese sind z.B.:

– wie Interpretierbarkeit (oder die Fähigkeit zu erklären, wie ein KI-Modell zu seinen Vorhersagen kommt) und

– Transparenz der Entscheidungen (z.B. wie wird das Risiko für Bias reduziert).

Acceptance vs. Resistance: Sind die Resultate überprüfbar?

Eine Studie untersuchte welchen Einfluss Korb 1 oder Korb 2 auf das Vertrauen in die AI hat.

Die Ergebnisse der Studie widerlegen die weit verbreitete Annahme, dass Nutzer der KI mehr Vertrauen entgegenbringen, wenn sie besser verstehen, wie ein bestimmtes KI-Modell zu seiner Vorhersage – oder Interpretierbarkeit – gelangt ist.

Ein grösserer Einflussfaktor für das Vertrauen war der Studie zufolge das Ergebnis-Feedback darüber, ob die Vorhersagen der KI richtig oder falsch waren (Korb 1).

Die Studienteilnehmer neigten dazu, im Laufe der Zeit Vertrauen aufzubauen, je nachdem, ob die nachfolgende KI ihre Leistung bei den letzten Vorhersagen verbessert oder verschlechtert hat.

Die Studie ist die erste, die diese beiden Faktoren miteinander vergleicht, um zu verstehen, wie sie sich auf das Vertrauen der Menschen in die KI und folglich auf die Leistung der Nutzer auswirken.

Das Forschungspapier Generative AI – Trust Issues als PDF Download.

GraphCast von Google ist ein auf AI basiertes Model für Wettervorhersagen (siehe auch Image hier unten) sowie Artikel in Nature:

- Kochkov, D., Yuval, J., Langmore, I. et al. (2024). Neural general circulation models for weather and climate. Nature. https://doi.org/10.1038/s41586-024-07744-y

Google GraphCast: Algorithmus für Wetterprognosen mit Hilfe “realer Daten” trainieren. Keine Generative AI.

In diesem Beispiel können die Genauigkeit und Richtigkeit der Wettervorhersage überprüft werden. Kommt der prognostizierte Regen am Montag in einer Woche nicht, liegt die Vorhersage von AI falsch.

Die Studie zeigt, dass unser Vertrauen dann in eine AI wie GraphCast und dessen Resultate ansteigt, wenn wir nach unserer Überprüfung der Resultate sehen, dass die Prognose richtig war.

Mehr zu Google GraphCast finden sie im Google Blog.

Fazit AI: Transparenz und Ethik vs. Richtigkeit der Resultate

LLMs (die mit Hilfe von Eingabeaufforderungen eingesetzt werden) können keinen Sinn in Situationen erkennen, die sich wesentlich von den Situationen in ihren Trainingsdaten unterscheiden. Die Folge ist, dass LLMs keine allgemeine Intelligenz in einem sinnvollen Ausmass besitzen (siehe auch François Chollet on Twitter / X).

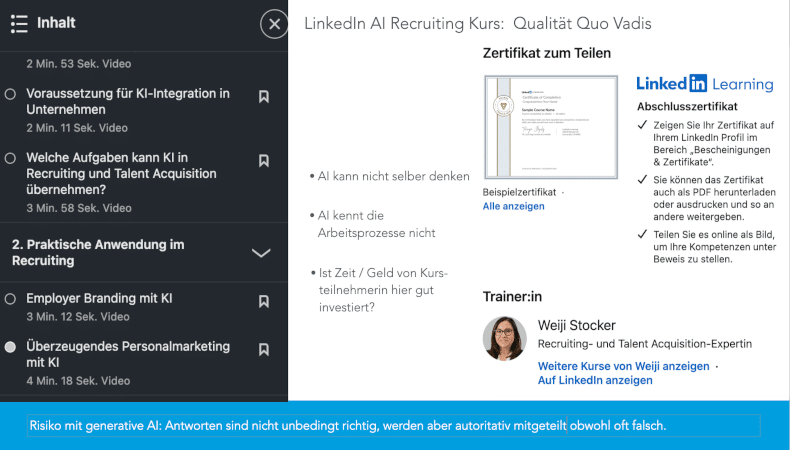

LinkedIn Learning: Schwachsinn über Generative AI im Unternehmen

Weiji Stocker, ihres Zeichens eine Recruiting- und Talent Acquisition-Expertin, offeriert z.B. einen Kurs (eine Serie von 4-8 Min langen Videos) auf LinkedIn zum Thema AI und Human Resource Management, inklusive Recruiting. Die Problematik von KI im Personalwesen haben wir in einem Blogeintrag besprochen und illustriert – Hat die AI Recruiting Software die falsche Antwort?

In Frau Stocker’s AI Online Learning Kurs auf LinkedIn wird unter anderem behauptet, dass ihnen z.B. AI bei der Planung für das Recruiting hilft, keine wichtigen Fragen zu vergessen.

Auch macht das MS Cockpit vielleicht ein Transkript der von ihnen mit dem Vorgesetzten gehaltenen Gespräche zwecks der zu besetzenden Stelle.

Aber ob da eine von AI erstellte Persona hilft, zu eruieren welche kritischen Schlüsselqualifikationen eine Bewerberin haben sollte, wage ich zu bezweifeln. Denn die AI kennt weder die Abläufe noch die Arbeitsprozesse in der Abteilung.

Die AI weiss heute sicherlich noch nicht, welche Stärken und Schwächen wie auch Einstellungen die Personen haben, mit denen die neue einzustellende Person zusammenarbeiten muss. All dies hat Einfluss auf die Schlüsselqualifikationen, Charakteristika, Präferenzen, Ausbildung, usw. welche die Person welche wir suchen haben muss.

Auch gibt mir KI nicht unbedingt fundierte Einblicke in die Komplexität der Arbeit im Personalwesen. Dies obwohl Frau Stocker dies impliziert und auch mehrmals in den Videos kommuniziert.

Dank KI besser platzierte Stellenanzeigen sind ein schönes Ziel. Doch die Systeme die ich kenne sind die vorgeschlagenen Keywords oder Boolean Search String von AI nicht optimaler als meine.

Wenn LinkedIn Learning solche Inhalte zur Weiterbildung in Sachen AI anbietet, ist das mitgelieferte Zertifikat sicherlich nicht viel Wert.

LinkedIn Learning. Erfolgreiche Absolventen erhalten ein Zertifikat: Generative AI im Personalwesen mit Weiji Stocker.

▶️ Nicht VERGESSEN: LLMs (mit Hilfe von Eingabeaufforderungen) können keinen Sinn in Situationen erkennen, die sich wesentlich von den Situationen in ihren Trainingsdaten unterscheiden.

Das heißt, LLMs besitzen keine allgemeine Intelligenz in einem sinnvollen Ausmass.

Wie oben erwähnt, was immer sie vom AI als Antwort bekommen, es kann sich dabei um eine vom Chatbot genutzte Wiedergabe einer im Netz gefundenen Unwahrheit handeln. Und auch wenn es in diesem Falle autoritativ und glaubwürdig klingt, ist das Resultat trotzdem falsch!

Leitfaden und Checkliste: Copyright, AI und Vertrauen

Was gilt es zu beachten?

1. AI-Content / Designs zu “vermenschlichen”: Dies ist ein zum Scheitern verurteilter Versuch. Sinn des Einsatzes von KI besteht darin, Geschwindigkeit, Skalierbarkeit und Effizienz zu steigern.

Wenn Menschen diese Texte bearbeiten, wird das Wertversprechen völlig untergraben.

2. Überprüfung der Resultate verbessert die Akzeptanz der AI: Nicht nur im von AI generierten Text, auch beim KI erstellten Job Profil ist es notwendig, dass wir die Resultate validieren und überprüfen.

Nur so können wir sicherstellen, dass die Ergebnisse stimmen.

Überprüfbare Resultate erhöhen die Akzeptanz der AI Modelle.

3. Rechtliche Auswirkungen im Auge behalten: Der der AI Act der EU verlangt z.B., dass beim Trainieren der Modelle keine Copyright/Urheberrechte verletzt wurden. Es dürfen deshalb keine proprietären Daten verwendet werden, um ein grosses Sprachmodell oder LLM zu trainieren (Erklärungen zum KI Act der EU).

Ebenfalls muss die DSGVO eingehalten werden. Dies bedeutet, dass wir von Personen, deren Daten wir beim Training der AI Modelle nutzen möchten, zuerst deren Zustimmung einholen.

Eine Antwort

Was hätte #SB1047 in Kalifornien bewirkt?

SB 1047 versuchte zu verhindern, dass grosse AI-Modelle verwendet werden, um „kritischen Schaden“ gegen die Menschheit anzurichten.

Der Gesetzentwurf nannte als Beispiele für „kritische Schäden“

1️⃣ ein böser Akteur ein KI-Modell verwendet, um eine Waffe zu entwickeln, die zu einem Massensterben führt, oder

2️⃣ ein Modell anweist, einen Cyberangriff zu orchestrieren, der einen Schaden von mehr als 500 Millionen Dollar verursacht (zum Vergleich: der CrowdStrike-Ausfall hat schätzungsweise über 5 Milliarden Dollar Schaden verursacht).

Der Gesetzentwurf hätte die Entwickler – d. h. die Unternehmen, die die Modelle entwickeln – haftbar für die Einführung ausreichender Sicherheitsprotokolle gemacht, um solche Folgen zu verhindern.

Aber das ist ja jetzt „Geschichte“ da der Gesetzesentwurf nicht unterschrieben wurde.