Dieser Beitrag zeigt, wie man eine KI Richtlinie erstellt (Neudeutsch: Generative AI Policy Guidance). Ebenfalls wie das Unternehmen Mitarbeitende bei deren Einhaltung tatkräftig unterstützt, wird diskutiert.

Mit 2 Spickzetteln helfen wir Mitarbeitenden die Richtlinie effektiv bei der Arbeit umzusetzen:

1. Beim Stellen kritischer Fragen zum KI-Prompt – Faktencheck – Tabelle 1 und mit dem

2. 5-Punkte Compliance Ratgeber – Tabelle 2 – Einhaltung der Generative KI Richtlinie .

Link zu diesem Beitrag https://drkpi.com/de/?p=36840/

Die KI Richtlinie legt fest, wie AI eingesetzt wird. Ebenfalls wer verantwortlich ist, welche Risiken bestehen und wie rechtliche sowie sicherheitstechnische Vorgaben eingehalten werden.

Die vorgestellte KI Richtlinie hilft:

- die eigene Policy auf deren Vollständigkeit zu überprüfen und

- bei der Entwicklung einer KI Richtlinie von Grund auf.

Sie haben Fragen zur KI Richtlinie?

Melden Sie sich!

Der Blogeintrag ist der siebte Eintrag in einer Serie zum Thema KI:

- AI Effektivität und Effizienz – mehr Effektivität mit KI

- AI Fachkräfte Recruiting: DrKPI 3-Phasen Modell

- AI Training: Widerspruch gegen die Verarbeitung personenbezogener Daten – iPhone, Meta, eBay, usw.

- AI 7 Tests für DeepL vs Mistral: Übersetzung + Textbearbeitung

- KI FAQ – Begriffe einfach erklärt Teil 2

- KI FAQ – Begriffe einfach erklärt Teil 1

- AI Erstellung der Generative KI Richtlinie für den Mittelstand: 10 Punkte Vorlage für 2025 – „Guidance for use of Generative AI tools“ (sie sind hier)

Um keinen zukünftigen Eintrag zum Thema Innovation, KI, Marketing und Technologie zu verpassen, abonnieren sie den DrKPI Newsletter.

Wir schätzen es, selbst zu entscheiden, und Ihre Meinung ist für uns massgebend – hinterlassen Sie einen Kommentar unten. DANKE.

3 Gründe warum das Unternehmen eine KI Richtlinie braucht

Erster Grund weshalb es eine KI Richtlinie braucht ist der EU AI Act. Dieser ist ein Rechtsakt der Europäischen Union zur Regulierung von künstlicher Intelligenz. Die KI Verordnung ist weltweit die erste derart umfassende Regulation von KI.

Um compliant zu sein, verlangt der AI Act, dass zur Nutzung von KI im Unternehmen eine Richtlinie erstellt wird.

Hier zeigt eine Adecco-Studie, dass es hier noch Arbeit gibt. Die Verfasser befragten 2300 Führungskräfte in grossen Unternehmen aus 13 Ländern zum Thema KI.

60% vertrauen darauf, dass Mitarbeitende ihre KI-Kompetenzen eigenständig erweitern.

Im Durchschnitt hatten 34 % der Konzerne (Schweiz: 36 %) keine klaren Vorgaben für den KI-Einsatz. Dies ist ein potenzielles Risiko und verhindert Compliance in Sachen AI Act.

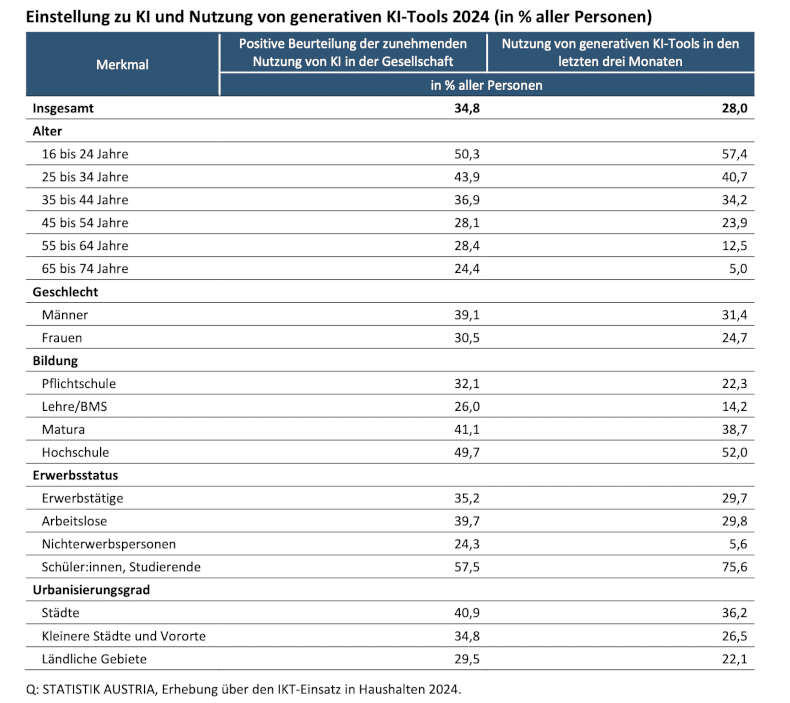

Zweiter Grund ist, dass gemäss einer Umfrage z.B. von Statistik Austria, KI von über 50% der unter 24-Jährigen und Hochscholabsolventen genutzt wird. Tendenz steigend.

Die Tabelle unten von Statistik Austria mit der Pressemitteilung finden Sie hier als PDF Datei.

Statistik Austria Daten zeigen warum Unternehmen eine KI Richtlinie brauchen.

Gemäss Umfrage empfinden mehr als die Hälfte – 50,3 % der 16- bis 24-Jährigen die zunehmende Nutzung von KI als positiv.

Sie nutzen generative KI-Tools wie ChatGPT oder DeepSeek regelmässig. Ähnlich hohe Anteile – 52 % – zeigt die Studie auch bei Hochschulabsolvent:innen.

Die Daten von Statistik Austria lassen die Vermutzung zu: Wer nicht in einem Unternehmen mit KI Richtlinie arbeitet, könnte KI heimlich nutzen.

Dritter Grund warum wir eine KI Richtlinie brauchen zeigt ein Experiment, bei dem 130 Manager des mittleren Kaders verfasste Schriftstücke von von Junior-Consultants bewerteten.

Davon wurden einige der Schriftstücke mit, einige ohne ChatGPT geschrieben. Die Manager konnten nicht zuverlässig erkennen, ob KI genutzt wurde.

In einer Aufgabe erkannten 77 % der Führungskräfte, dass ChatGPT bei der Erstellung der Texte verwendet wurde.

Doch in 73 % der Fälle, lagen die Manager falsch in der Annahme, dass die Junior-Consultants ChatGPT zur Texterstellung verwendet hatten.

Fazit der Forscher: Arbeitgeber sollten transparente KI Richtlinien schaffen, die offenen Einsatz fördern.

Die Allianz Gruppe (Versicherer) hat 5 Prinzipien für den verantwortungsvollen KI Einsatz entwickelt.

Diese 5 Prinzipien sind ein guter Anfang.

Doch damit Mitarbeitende KI effektiv, gesetzeskonform, verantwortungsvoll und transparent tagtäglich bei der Arbeit einsetzen können, müssen diese Prinzipien operationalisiert werde.

Grosse Worte helfen wenig, praktische Leitlinien schon eher, wie unsere 🔟 Punkte KI Richtlinie aufzeigt.

🔟 Punkte Generative KI Richtlinie ➡️ „Guidance for use of Generative AI Tools“

Die unten aufgeführte 10-Punkte Richtlinie bezieht sich auf Generative KI. Dabei werden grosse Sprachmodelle eingesetzt wie ChatGPT.

Generative KI kann zur Erstellung neuer Inhalte, einschliesslich Text, Code und Simulationen, verwendet werden.

Diese Erklärung ist nicht als Rechtsberatung oder als erschöpfende Zusammenstellung bewährter Verfahren gedacht. Sie sollte auch nicht als endgültige Richtlinie angesehen werden.

Der Bereich der Künstlichen Intelligenz (KI) entwickelt sich schnell. Es ist davon auszugehen, dass eine KI Richtlinie für das Unternehmen regelmässig aktualisiert wird.

1️⃣ Transparenz

Nutzer müssen klar angeben, wann und wie generative KI eingesetzt wird (z. B. in Texten, Bildern, Produkten, Programmcode). Bei mit KI-Tools erstellten Arbeitsergebnissen, muss dies offengelegt und der Einsatz der KI beschrieben werden.

Unten ein Beispiel wie Transparenz z.B. für Inhalte auf der Website gelebt werden soll.

Ein erster Entwurf des Artikels wurde von einem Menschen erstellt. Anschliessend wurden Textpassagen mit Hilfe von verschiedenen generativen KI-Tools optimiert. Vor der Veröffentlichung erfolgte eine abschliessende Überprüfung und Bearbeitung durch ein DrKPI Teammitglied, einschliesslich eines Faktenchecks (vgl. Tabelle 1 – 3 Fragen an den KI Prompt).

Der Zweck von KI-Systemen wird klar kommuniziert. Kunden werden beispielsweise informiert, wenn sie mit einem Chatbot interagieren.

2️⃣ Rechenschaftspflicht (Accountability)

Nutzer:innen sind für KI-generierte Inhalte verantwortlich und müssen diese auf Fehlinformationen oder fabrizierte Ergebnisse (sogenannte Halluzinationen) prüfen. Entscheidungen, die auf diesen Inhalten basieren, müssen von Menschen überprüft werden.

Ebenfalls muss sichergestellt sein, dass die Trainingsdaten, mit denen die KI gelernt hat, keine Urheberrechte verletzen. Wurden beispielsweise geschützte Fotos verwendet, könnte jedes neu generierte Foto das Urheberrecht der Originalfotografen verletzen. Mehrere Gerichtsfälle sind zur Zeit in den USA hängig.

Beispiel Dezember 2023: Die New York Times (NYT) klagt gegen Microsoft und OpenAI (1:23-cv-11195). In der Klage wirft die NYT beiden Unternehmen vor, mit ihren KI-Modellen, insbesondere ChatGPT, Urheberrechtsverletzungen begangen zu haben.

Im speziellen, dass diese Texte der Zeitung als Trainingsdaten nutzten und dabei Uhrheberrechte verletzt haben. Der Fall ist noch nicht abgeschlossen.

Die New York Times hat kürzlich mit Amazon einen Lizenzvertrag abgeschlossen. Dies ermöglicht es, dass redaktionelle Inhalte zum Trainieren von Amazons KI-Modellen. Dies ist das erste Mal, dass die NYT es einer Firma ermöglicht, ihre Inhalte zum Trainieren der Modelle künstlicher Intelligenz zu verwenden.

Mistral Le Chat hat in Frankreich mit Agence France Press einen Vertrag abgeschlossen. Dies ermöglichkt es Mistral Le Chat die täglich publizierten Artikel/Inhalte von Agence France Press als Daten zu nutzen. Die Firma erhofft sich damit die Qualität der Dateninhalte zu verbessern.

Doch es bleibt: Die Verantwortung, dass wir kein Gesetz bei der Erstellung unserer Texte, Bilder oder Musik verletzen, ist nicht an die KI delegierbar.

3️⃣ Voreingenommenheit (Bias)

Künstliche Intelligenz wird häufig mit grossen, unmoderierten Textmengen aus dem Internet trainiert.

Dies kann dazu führen, dass sie voreingenommene oder unbeabsichtigte Inhalte erzeugt, die als KI-Bias bezeichnet werden.

Weird Bias (auch KI Bias, Algorithmus- oder Lern-Bias genannt) bezieht sich auf unfaire Bevorzugungen aufgrund menschlicher Vorurteile – Weird Bias – Weird Voreingenommenheit, Datenverzerrung

Weird Bias Dies kann zu systematischen Fehlern, Diskriminierung und schädlichen Ergebnissen führen. Weitere Probleme, die es zu berücksichtigen gilt, sind Verbosity Bias und Verbosity Compensation durch die KI.

4️⃣ Durchsickern von vertraulichen Informationen (Data Leakage)

Klären sie Patent- oder Urheberrechtsschutz, bevor sie vertrauliche und/oder geschützte Informationen auf KI-Plattformen hochladen. Andernfalls kann dies das geistige Eigentum gefährden.

Ebenfalls ist zu berücksichtigen, dass die meisten KI-Tools und -Dienste die Eingaben und Daten von Nutzern des Tools nutzen, um das LLM (Large Language Model) weiter auszubilden und zu trainieren.

Versehentlich können diese auch durch den LLM oder seinen Anbieter an andere Nutzer weitergegeben oder anderweitig genutzt werden.

Aus diesem Grund sollten Nutzer von KI vermeiden, persönliche oder sensible Daten weiterzugeben (siehe auch unten, Schutz der Privatspähre).

5️⃣ Datenschutz – Schutz der Privatsphäre

In der Schweiz gilt das Datenschutzgesetz (DSG) und in Europa die Datenschutz-Grundverordnung (DSGVO).

Die Eingabe von personenbezogenen oder sensiblen medizinischen Daten von Patienten in KI-Systeme wie z.B. ChatGPT oder Mistral ist verboten.

Auch vertrauliche Kundendaten und Firmeninformationen dürfen nicht eingegeben werden (siehe Durchsickern von Vertraulichen Infos – oben).

Viele Anbieter haben einen Auftragsverarbeitungsvertrag in ihre Nutzungsbedingungen integriert. OpenAI hat das nicht. Dies lässt sich nur mit einer Team-Lizenz oder API Nutzung mit OpenAI abschliessen indem man:

- OpenAI OpenAI Data processing addendum öffnet,

- runter scrollt und auf „Execute Data Processing Agreement“ klickt und, danach

- Daten eingibt und Formular sendet.

Seit dem 16. Mai 2025 gibt es ein weiteres Problem. Richterin Wang ordnete im Fall New York Times vs. Microsoft & OpenAI an (siehe oben), dass ChatGPT Daten nicht gelöscht werden dürfen.

Somit können Nutzer:innen in der EU ihre DSGVO-Rechte , wie das Recht auf Löschung ihrer Daten, nicht mehr durchsetzen .

🔥🧨🚀 Ein zentraler Punkt bei der Gewährleistung der #GDPR oder #DSGVO ist jedoch das Recht der Nutzer auf Löschung der Daten 🔥🧨🚀

Die Problematik oben zeigt, wenn immer ein USA Richter:in von einem Unternehmen z.B. verlangt, dass Daten gespeichert werden, wird europäisches Recht verletzt.

Dieses Risiko kann nur minimiert werden, indem ein KI Modell eines EU Anbieters eingesetzt wird.

6️⃣ Cybersecurity und Compliance

Neue Cyberangriffe auf KI-Nutzer kennen und beim Einsatz von KI in Technologie und Code-Entwicklung berücksichtigen.

Laut EU AI-Act sind Sicherheitstests für leistungsstarke KI-Modelle verpflichtend, in den USA hingegen freiwillig (vgl. Fussnote 2, Tabelle 2).

Compliance Officers müssen die entsprechenden Sicherheitsberichte prüfen, um Risiken bewerten zu können. Eine vom Officer erstellte Zusammenfassung der erkannten Risiken (maximal zwei Seiten je KI-Modell!) sollte zudem allen betroffenen Mitarbeitern zugänglich sein.

Erst auf Grundlage dieser Bewertung können die Nutzung und der Einsatz verschiedener KI-Modelle genehmigt werden.

Generation Z – 1997 – 2012: Gen Z ist mit dem Internet aufgewachsen. Sie hat die Welt nie ohne das Internet kennengelernt. Sie hält es für völlig normal und wünschenswert, alles ihren Wünschen entsprechend zu bekommen und zu konsumieren. Auch dank KI…

Legt Wert auf Vielfalt, Individualisierung und die Suche nach ihrer eigenen Identität.

7️⃣ Datenauslese (Data Scraping)

Mit dem Aufkommen von KI-Modellen werden zunehmend öffentlich zugängliche Informationen von Einzelpersonen und Organisationen verwendet (d.h. kopiert), um neue KI-Modelle zu trainieren.

Seien Sie sich bewusst, dass alle veröffentlichten Daten von Dritten ausgelesen und genutzt werden können.

Diese Praktiken sind weit verbreitet. Sie bergen jedoch erhebliche Risiken, da die rechtlichen und finanziellen Konsequenzen noch nicht abschliessend geklärt sind (siehe oben z.B. Accountability sowie Urheber- & Patentrecht.

8️⃣ Publikation: Zustimmung vor Veröffentlichung

Um die oben genannten Anforderungen zu erfüllen, müssen alle mit Hilfe von KI erstellten Inhalte vor der Veröffentlichung geprüft und genehmigt werden.

Dies gilt, egal ob Texte, Videos oder Programme.

Dazu gehört auch, dass Inhalte mit dem Avatar eines Mitarbeiters dessen Zustimmung vorab haben (siehe UBS).

Dabei fungiert dieser Schritt auch als letztmaliger Überprüfung des Inhaltes vor dessen Publikation.

9️⃣ KI Faktencheck

KI verspricht Effizienz, d.h. schnellere Ergebnisse und Analysen mit weniger Aufwand. Doch ein Faktencheck ist ein muss.

Leider kann ein Mitarbeiter den Algorithmus kaum überprüfen um etwaige Fehler aufzuspüren (siehe Tabelle „Überprüfbarkeit vom Algorithmus: 5 Fehlerquellen),

Bei Text ist es einfacher. Hier kann überprüft werden ob er kürzer oder besser formuliert ist als das Original, beispielsweise.

Schwieriger wird es wenn es um fachliche Dinge geht. Beispiel: In der Anwort werden Studienresultate präsentiert. Hier lohnt es sich wie immer, die Originalstudie anzuschauen. Wurden die richtigen Schlüsse gezogen?

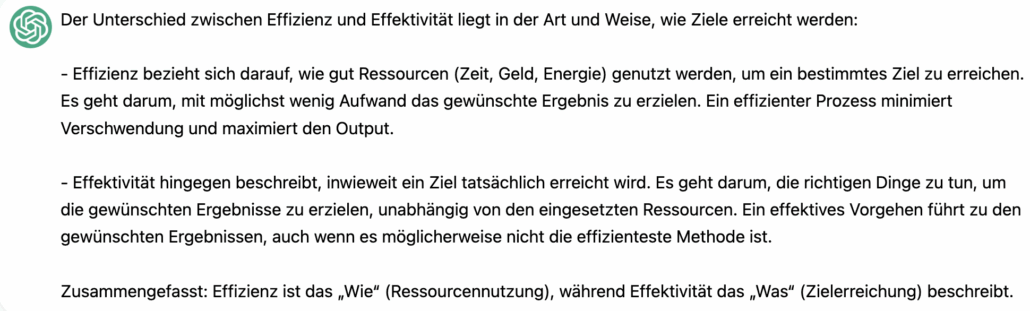

Ein weiteres Beispiel der Problematik zeigt unsere Definition hier:

- Effizienz heisst die Ressourcen optimal nutzen ➡️ Input / Output

- Effektivität bedeutet, die richtigen Dinge tun (Entscheide treffen) – Bsp. Auswahl eines Medikaments, das zum gewünschten Gesundheitserfolg führt (z. B. bei Krebs oder hohem Blutdruck).

Das Beispiel unten von ChatGPT zeigt, auch wenn wortreicher ist eine Definition nicht unbedingt besser. Die Definition von Effektivität ist beispielsweise nur teilweise richtig (siehe oben).

Efficiency vs. Effectiveness: ChatGP ist nicht nur wortreich sondern liegt auch falsch.

Efficiency ist eine Input/Output Angelegenheit.

Effectiveness ist jedoch mehr als nur das gesetzte Ziel zu erreichen, denn dieses mag falsch sein. Effektivität heisst zuerst die richtige Behandlung / Ziel wählen, sodass z.B. das personalisierte Medikament gegen die seltene Krankheit eines Kindes wirkt.

Mitarbeiter:innen müssen wissen wie sie die Fakten und Qualität auch unter Zeitdruck überprüfen können. Unsere Tabelle unten leistet Hilfestellung.

Tabelle 1. 3 Rückfragen an den Prompt

Follow-Up Questions by User for AI:

Encourage more Critical Thinking Folgefragen der Benutzerin für KI:

Ermutigung zu kritischem Denken What facts make this answer reliable? Welche Fakten machen diese Antwort verlässlich? Do other sources provide an alternative explanation?

— Woher stammen die Fakten ursprünglich (z. B. URL zum online Dok. vom Bundesamt für Statistik)?

— Existieren alternative Erklärungen aus anderen Quellen?

— Werden die Aussagen von weiteren Quellen bestätigt? Wat are some reasons this answer may be incorrect? Aus welchen Gründen könnte diese Antwort falsch sein?

| Follow-Up Questions by User for AI: Encourage more Critical Thinking | Folgefragen der Benutzerin für KI: Ermutigung zu kritischem Denken |

| What facts make this answer reliable? | Welche Fakten machen diese Antwort verlässlich? |

| Do other sources provide an alternative explanation? | — Woher stammen die Fakten ursprünglich (z. B. URL zum online Dok. vom Bundesamt für Statistik)? — Existieren alternative Erklärungen aus anderen Quellen? — Werden die Aussagen von weiteren Quellen bestätigt? |

| Wat are some reasons this answer may be incorrect? | Aus welchen Gründen könnte diese Antwort falsch sein? |

Notiz: Kritisches Nachfragen enthüllt Schwächen und unterstützt den Faktencheck. Frage 2 ist in drei Untergliederungen aufgeteilt, um die Kernidee anschaulicher zu machen.

Natürlich können diese Fragen angepasst werden. Ein Fallbeispiel für diese Problematik finden sie in den Schlussfolgerungen.

Im Beispiel in den Schlussfolgerungen unten müsste ich als Careum Mitarbeiterin bei der KI nachfragen. Wo kann die Originalstudie vom Bundesamt für Statistik eingesehen werden = URL Link.

🔟 Effektive Umsetzung der Generative KI Richtlinie (Guidance for use of Generative AI Tools)

Wenn wir mit der KI arbeiten gilt es die Richtlinien korrekt anzuwenden. Natürlich gibt es ein Risiko, dass wir in einer Situation die falsche Entscheidung treffen.

Aus diesem Grunde haben wir unten den Leitfaden oder Ratgeber vorbereitet, welchen wir bei der Arbeit mit KI immer zur Hand haben sollten.

Tabelle 2. Spickzettel zur Sicherung der Compliance gemäss Generative KI Richtlinie (Generative AI Policy Guidance)

| Art der Herausforder- ungen mit KI Nutzung |

Beispiele für die Einhaltung der Richtlinie (Ethik, Gesetz, Klima & Effektivität) |

|---|---|

| 1. Vorläufige Chatbot-Auswahl: Energie sparen & das für den Job beste Modell einsetzen. | Aufgabenspezifische KI-Modelle wie TinyBERT oder DistilBERT, die einfach Antworten aus Text abrufen, verbrauchen etwa 0,06 Wattstunden pro 1.000 Abfragen. Dies ist so viel wie wenn eine LED-Glühbirne für 20 Sekunden leuchtet.

Grosse Modelle wie ChatGPT, Claude, Llama, DeepSeek und Qwen schlucken dafür bis zu das Tausendfache an Energie (siehe Notiz unten). Fazit: Strebe das Optimum zwischen Antwortqualität und Energieeffizienz des Chatbots an (siehe Benchmark – AI Energy Score – Notiz). Wähle das für deinen Job passendste Modell, wie z. B. Qwen, das für Coderaufgaben besser geeignet ist als Claude. |

| 2. Einhaltung der KI Richtlinie | Wenn 3 KI-Modelle zur Auswahl stehen (siehe Punkt 1 oben), stellt sich z.B. die Frage:

Wie hoch ist das Risiko von Gesetzesverstössen? Übernimmt der Anbieter Schäden oder Bussen? Antwort: Meistens nicht(1). Wenn es ein USA KI-Modell ist, besteht immer die Gefahr, das z.B. ein Gericht das USA Unternehmen (siehe ChatGPT von OpenAI vs. New York Times – siehe oben Punkt 2 der Richtlinie) zwingt Dinge zu tun, welche z.B. gegen EU Recht verstösst. Fazit: Nutzungsbestimmungen prüfen: Wurde die KI rechtskonform trainiert? Risiken klären – dann Punkt 3 unten abklären. |

| 3. Definitive Chatbot-Auswahl: Ist der Algorithmus vertrauens- würdig (Trust)? |

Mögliche Fehlerquellen wie Konzeptionierung, Implementierung, Modellierung, fehlerhafte Daten (Data Bias), Zusammenspiel Algorithmus / kulturelle Phänomene (siehe Tabelle „Überprüfbarkeit vom Algorithmus: 5 Fehlerquellen”) wurden vom KI Anbieter überprüft?

Gemäss EU AI Act: Kann ich dem Lieferanten wie OpenAI trauen, das Sicherheitstests gemacht wurden. Ist dies anhand der publizierten Resultate dieser Tests überprüfbar (nicht bei ChatGPT von OpenAI) (siehe Notiz 2 unten)? Fazit: Sei vorsichtig bei Behauptungen wie z.B.: „So funktioniert der LinkedIn-Algorithmus“ – ohne Programmier- und Testeinsicht sind das nur Spekulationen. Risiken klären, Protokolle der Sicherheitstests anschauen – dann das definitiv passende Modell wählen – dies wird fast immer ein Kompromiss sein. |

| 4. Effektiver KI Einsatz: Nutze KI zur gezielten Verbesserung – nach eigener Vorarbeit. | Ersten Entwurf von Text oder Programm selbst schreiben. Dies spart Energie und vermeidet das Risiko für KI-Halluzinationen sowie Verbosity Bias und Verbosity Compensation (#BSDUskillsAI).

Fazit: Ersten Entwurf selbst schreiben / programmieren, verbessern, 1× beim Chatbot optimieren, danach revidieren. PS: 16 Wörter pro Satz – vermeide unnötige lange Sätze welche die KI oft liefert, DrKPI PageTracker. |

| 5. AI und KPI: Messen was zählt #DrKPImetrics – Verbrauch von Ressourcen (siehe Notiz 1 unten) | Grundsätzlich gilt es immer wieder als Nutzer:in zu überprüfen, ob der Einsatz von Ressourcen für die Nutzung der KI in jedem Falle effektiv ist (z.B. Strom- und Trinkwasserverbrauch – Notiz unten).

Auch wie viel Zeit gespart wird und inwiefern die Lösung wirklich besser ist, dank mehrmaliger Verbesserung mit KI, ist hier Thema. PS. Auch der Faktencheck der von KI gemachten Behauptungen – Originalstudie anschauen – braucht Zeit! Fazit: Das Textverarbeitungsprogramm hat einen Spellchecker. Das könnte z.B. für das Verfassen einer “guten” Aktennotiz schon reichen. |

Notiz. Mit dem Spickzettel können wir KI optimaler und effektiver im Arbeitsalltag nutzen. Dies hilft Fehler zu vermeiden.

Bei der Arbeit mit KI sollte der Energieverbrauch – beispielsweise gemessen am AI Energy Score – stets im Fokus stehen. Die Stromkosten pro Anfrage variieren je nach Modell stark: von etwa 20 Sekunden Sparlampe für 1000 Anfragen bis hin zur Beleuchtung des gesamten Wembley-Stadions pro Anfrage (ChatGPT)!

(1) Ein Fehler eines KI-Tools allein reicht z.B. nicht aus, um eine Auszahlung gemäss Armillas KI-Versicherungspolice auszulösen. Stattdessen würde der Versicherungsschutz nur dann greifen, wenn der Versicherer zu dem Schluss kommt, dass die KI hinter den ursprünglichen Erwartungen zurückgeblieben ist.

(2) Laut EU AI Act sind Sicherheitstests für leistungsstarke KI-Modelle verpflichtend, in den USA hingegen freiwillig.

OpenAI führte im April 2025 Sicherheitstests für ChatGPT 4-1 durch. Es wurde jedoch kein Sicherheitsbericht veröffentlicht. Wie die EU-Kommission in solchen Fällen vorgeht, wird das globale KI Risikomanagement prägen.

Risikoabschätzungen sind Teil der Compliance Arbeit (siehe Punk 6: Cybersecurity und Compliance).

Dieser Artikel wurde von Redakteuren geschrieben, aber teilweise mit Hilfe von KI optimiert. Danach wurden zusätzliche Texte von Mitarbeitern von DrKPI eingearbeitet und Korrekturen am Text vorgenommen. Lesen Sie unsere KI Richtlinie hier.

Erklärung zur inhaltlichen Verantwortung

Eine wortreichere. Möglichkeit, die das Unternehmen nutzen kann, lesen sie hier:

Sorgfaltspflichterklärung Bei nahezu allen Dokumenten auf dieser Website, einschliesslich dieses Beitrags, wurden KI-gestützte Tools wie Mistral und Qwen zur sprachlichen Überarbeitung eingesetzt. Die Autorin oder der Autor bestätigt, dass alle KI-bearbeiteten Inhalte sorgfältig geprüft, überarbeitet und inhaltlich verantwortet wurden. Das Dokument gibt das eigene Fachwissen sowie die beabsichtigte Aussage der Autorin oder des Autors wieder. Lesen Sie unsere KI Richtlinie hier.

EU AI Act – DrKPI KI Richtlinie – 10 Punkte Vorlage.

Partner mit DrKPI® CyTRAP Labs: Messen was zählt

Wir bieten kompetente Entwicklung und Implementierung von:

- KI-Engineering (EU KI Verordnung, Beratung, Audit, Implementierung, Rekrutierung),

- KPI für digitales Marketing, und

- Vulnerability Disclosure Program (VDP) & GDPR Compliance.

Unsere Strategie: Minimale Ressourcenbelastung, optimierte Prozesse, gezielte KPIs und gesicherte Compliance.

Tools wie DrKPI® PageTracker und KPI AI AuditLight sorgen für innovative Lösungen

Sie haben Fragen zur KI Richtlinie?

Melden Sie sich!

Fazit: Kritische Fragen an Prompt und KI Spickzettel

KI entwickelt sich rasant, sie wird immer mehr gebraucht. Niemand weiss so genau, auf welche Risiken wir uns hier einlassen.

Wir können uns jedoch diesen Entwicklungen nicht verweigern. Doch Inhalte müssen vor deren Publikation die Zustimmung der Autorin oder Vorgesetzten bekommen (Punkt 8).

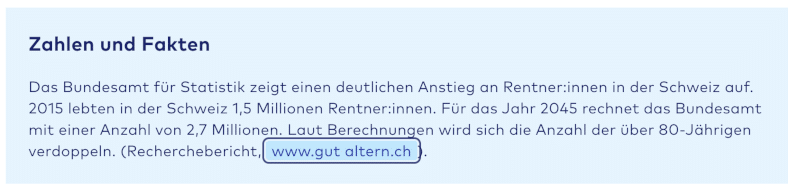

Ziel ist es sicher zu stellen, dass z.B. keine Urheberrechte (Regel 2 – Accountability) verletzt wurden wie anfangs in der Textbox im Blogeintrag auf Careum

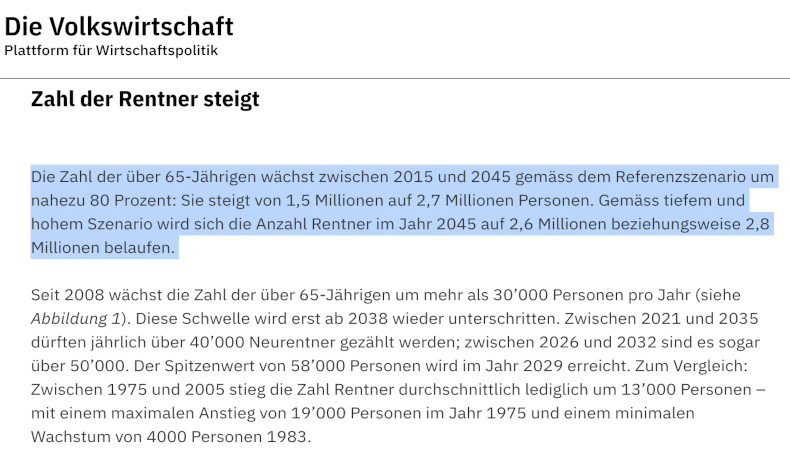

In der Textboox unten ist der Text von der Zeitung Die Volkswirtschaft praktisch wortwörtlich kopiert. Wurde hier das Uhrheberrecht verletzt?

Careum zitiert sekundäre Quelle im Blog anstatt primäre Quelle: Bundesamt für Statistik. Das sollte man vermeiden, immer Originalstudie überprüfen im Faktcheck für AI

Neben den Dingen oben geht es auch zu überprüfen ob die Angaben stimmen, d.h. ob die KI keine falsche Information geliefert hat (auch Hallucination genannt) .

Wo ist die Originalstudie? Wo kann ich auf der Website vom Bundesamt für Statistik diese erwähnten Daten überprüfen? Diese wurden in einer Pressemitteilung publiziert.

Stimmt es, dass der Anteil der Pensionäre an der Bevölkerung so hoch ist wie das in der zitierten Studie versichert wird (siehe auch Erwähnung auf LinkedIn)

Careum, Bundesamt für Statistik, Die Volkswirtschaft: KI Richtlinien helfen z.B. das Risiko für Urheberrechtsverletzungen zu minimieren. Alle Inhalte sollten vor Publikation automatisch von verantwortlicher Person mit Hilfe vom KI Ethik Spickzettel und Faktencheck überprüft werden.

Regel 1 (Transparenz) sollte so umgesetzt werden, indem erwähnt wird, dass KI bei der Texterstellung genutzt wurde.

Wir hoffen ihnen mit diesen Informationen gedient zu haben.

10 Antworten

Das vorliegende Dokument ist wirklich sehr interessant.

Besonders gut gefallen mir die Spickzettel für die Mitarbeiter, die ausgedruckt und griffbereit dabei helfen, im täglichen Arbeitsalltag Dinge in Bezug auf AI richtig und effizient zu handhaben.

Ein weiterer spannender Punkt sind die von Statistik Austria präsentierten Zahlen. Diese zeigen, wie stark die Generation Z bereits heute generativer KI-Anwendung vertraut und diese aktiv nutzt.

Dies ist jedoch auch ein wichtiger Grund, warum wir auch in unserem Unternehmen Generative KI Richtlinien brauchen.

Danke Urs and ja wir sind mit dir dran!

ANTWORT 1

Liebe Elisabeth

Danke für deinen Input.

Ja Generation Z sind die Trailblazer was die KI Nutzung im Alltag betrifft. Hier ist die Herausforderung, dass die Regeln eingehalten werden 😀

Doch wir dürfen 2 weitere Generationen nicht vergessen:

1981 – 1996 geboren (2025 – 29 – 44 Jahre alt) Generation Millennials und

1965 – 1980 geboren (2025 – 45 – 60 Jahre alt) Generation X.

Sie alle brauchen AI auch. Beispiel: Wenn sie Machine Translation nutzen um einen kurzen Text auf dem Handy zu übersetzen. Auch nutzen einige den Sprachassistenten auf dem iPhone oder solchen mit dem Android Betriebssystem.

Antwort 2

Wichtig ist hier zu berücksichtigen, dass Generation Millennials und Generation X vielleicht nicht so schnell mit AI anfangen zu arbeiten. Nicht weil sie es nicht können, nein sondern weil sie vielleicht etwas vorsichtiger sind oder zuerst einmal abwarten.

Alle, ob Generation Z, Millennials oder Generation X, profitieren von Weiterbildung auf dem Gebiete der KI Anwendung.

Doch sollte der Fokus für Generation Z Teilnehmer:innen wohl ein wenig anders sein als für Millennials und Generation X.

Der grosse Fokus dieser Bildungsangebote wird nur die Fähigkeiten oder die Skills für Anwender vermitteln. Gleich wie bei der Vorbereitung für die Autoprüfung brauchen wir theoretische und praktische Kenntnisse. Doch für Otto Normalverbraucher (Quadrant 1 unten) ist technisches Wissen – wie man das Oil wechselt – nicht notwendig.

Das ist wohl ähnlich im Bereich KI. Auch hier braucht die Anwenderin kaum grosse Kenntnisse zum Thema Algorithmus. Trotzdem sollte sie erkennen, welche Auswirkungen Fehler in den Algorithmen auf die Resultate der KI haben.

Danke für diesen Eintrag.

Endlich ein Blog der mir zeigt wie ich das für unser Unternehmen erstellen könnte.

Gut für mich waren auch die Erklärungen / Verlinkungen zum Glossar 1 & 2.

Oops ja ich gebe es zu, einige der verschiedenen Ausdrücke kannte ich noch nicht.

Cindi

Danke für dein positives Feedback das mich natürlich freut.

In Kürze haben wir dann weitere Beiträge zu diesem Thema inklusive Skills/Kompetenzen.

➡️ ➡️ Was muss man wissen um mit der Technologie effektiv arbeiten zu können. ⬅️ ⬅️

Schau mal in unseren Newsletter vom Pfingstsonntag 2025-06-08 DrKPI Newsletter – Tipps für Juni

Du kannst dich auch gleich in den Verteiler eintragen, sodass du den nächsten Blogeintrag nicht verpasst: DrKPI Post – Inspiration für Tech Management, Innovation und Marketing

Diese Glossareinträge haben auch Updates drin:

Vielleicht folgt bald ein Glossar Teil 3 so wie die Dinge sich entwickeln.

⚠️ **Don’t share sensitive data with ChatGPT**

The same risk applies to client contracts, medical records, or anything covered by laws like the California Consumer Privacy Act, HIPAA, the GDPR, or classic trade-secret protections.

You should also avoid entering creative ideas, drafts, or patent-related details. Once submitted, you lose full control over where the data is stored, who can access it, or whether it might be used to train future models.

Even if providers promise strong security, there’s always a risk of data ending up on third-party servers, being insufficiently deleted, or getting compromised in a breach.

Think of it this way: if you wouldn’t paste it into a public Slack channel, don’t enter it in ChatGPT. Sensitive information belongs in secure, approved channels—not in a generative AI tool.

Danke Fritz für den Kommentar welchen du auch hier hinterlassen hast (wo er auch passt :-) Glossar Teil 4: AI Safety ≠ KI Schutz. Was wichtig ist

Ja um sich selber zu schützen darf man keine sensiblen Daten in ein KI System eingeben. Um so mehr, wenn es nicht eines von der Firma entwickeltes und gehostetes Modell ist.

Danke Fritz für den Kommentar welchen du auch hier hinterlassen hast und anderswo hier noch die DE Version

⚠️ **Keine sensiblen Daten in ChatGPT eingeben**

Das gleiche Risiko besteht bei Kundenverträgen, Krankenakten oder allem, was unter Datenschutzgesetze wie das kalifornische Consumer Privacy Act, HIPAA, die DSGVO oder klassische Geschäftsgeheimnisregeln fällt.

Auch kreative Ideen, Entwürfe oder patentbezogene Informationen solltest du nicht einfach eintippen. Nach dem Absenden kannst du nicht mehr vollständig kontrollieren, wo die Daten gespeichert werden, wer sie sehen darf oder ob sie zum Trainieren von Modellen verwendet werden.

Selbst wenn Anbieter Sicherheitsmaßnahmen versprechen, bleibt das Risiko, dass Daten auf Servern Dritter landen, unzureichend gelöscht werden oder bei Angriffen kompromittiert werden.

Überlege dir: Wenn du etwas nicht in einen öffentlichen Slack-Channel posten würdest, solltest du es auch nicht in ChatGPT eingeben. Vertrauliche Informationen gehören in sichere, vereinbarte Kanäle – nicht in generative KI-Tools.

Was uns ebenfalls klar sein sollte ist, dass Transparenz bei KI-generierten Inhalten wichtig ist:

1) Kennzeichnung als Wahlfreiheit

Wie bei Lebensmitteln ermöglicht eine klare Kennzeichnung informierte Entscheidungen. Wer wissen möchte, ob Inhalte von KI stammen, kann dies berücksichtigen – andere können die Information ignorieren.

Das Prinzip gleicht der Lebensmittelkennzeichnung: Wer gentechnisch veränderte oder mit Chlor behandelte Produkte meiden möchte, liest das Etikett.

2) „Made by Humans“ als Qualitätsmerkmal?

Viele Konsumenten bevorzugen von Menschen geschaffene Inhalte. Ohne Kennzeichnung können sie diese nicht identifizieren. Ein Verlust für Schöpfer und Publikum.

Analog zum Fairtrade-Label könnte sich ein „Made by Humans“-Siegel etablieren, je verbreiteter KI wird.

3) Die Herausforderung der Abgrenzung

Die Praxis ist komplex: Manche nutzen KI nur zur Fehlerkorrektur oder Grammatikprüfung, andere generieren damit ganze Programme oder Bilder.

Die Videospielindustrie zeigt: Eine klare Trennlinie zu ziehen wird nicht einfach.

Siehe auch Sara O’Connor 2025-12-16 – Financial Times

Update 2 – Transparenz in der Praxis

Deshalb kennzeichne ich meine Blogbeiträge konsequent:

📜 DrKPI CyTRAP AI-Verantwortlichkeitserklärung: Beitrag mit KI-Unterstützung angepasst; Inhalte wurden geprüft und verantwortet.

Die Grauzonen nehmen zu

Wo beginnt kennzeichnungspflichtige KI-Nutzung?

Die Grenze ist also fliessend – was heute noch erklärungsbedürftig erscheint, kann morgen als selbstverständlich gelten.

Urs

#DigitalMarketing #AIrisks #DrKPI