KI Geschichte 2026 wird zum Jahr der kritischen Bewertung. Nach dem Experimentieren (2024) und der breiten Umsetzung (2025) folgt nun die nüchterne Prüfung: Was kann KI wirklich leisten? Unternehmen brauchen klare Richtlinien – wie eine strukturierte KI-Richtlinie für den verantwortungsvollen Einsatz. Hunderttausende Unternehmen haben generative KI eingesetzt – mit gemischten Ergebnissen. Hochproduktive Anwendungen stehen peinlichen Fehlern gegenüber. Die Investitionen könnten 2026 die 500-Milliarden-Dollar-Marke überschreiten, doch die zentrale Frage lautet: Ist das gerechtfertigt?

Um zu verstehen, wo KI heute steht und wohin sie sich entwickelt, lohnt ein Blick zurück. Video 1 zeigt die 72-jährige Geschichte der KI – von Alan Turings Test über regelbasierte Systeme (LISP, Prolog, Expert Systems) bis zu den Meilensteinen Deep Blue (1997) und Watson (2011), dem Durchbruch des Machine Learning und schliesslich der Generative AI seit 2022. Die zentrale Erkenntnis: Wir haben uns von „wir programmieren das System“ zu „das System lernt selbst“ entwickelt.

Doch was bedeutet das für heute? Video 2 bringt uns in die Gegenwart und stellt die entscheidende Frage: Ist 2026 das Jahr oder das Jahrzehnt der AI Agents? Anhand von drei konkreten Use Cases – Coding-Assistenten (funktioniert heute), Reisebuchung (teilweise) und IT-Support (noch aspirational) – wird klar: AI Agents glänzen in strukturierten Umgebungen, kämpfen aber noch mit der Komplexität der realen Welt.

Zusammen geben beide Videos die Orientierung, die wir 2026 brauchen: Woher kommt KI, was kann sie heute wirklich – und was nicht?

KI Geschichte 2026: 72 Jahre Entwicklung

KI ist keine Erfindung von gestern – sie ist das Ergebnis von über 72 Jahren kontinuierlicher Entwicklung. Jeff Crume zeigt, wie sich der fundamentale Ansatz dramatisch verändert hat: von programmierten Systemen zu lernenden Systemen zu autonomen Agenten.

Die frühe Ära: Regelbasierte KI (1950-2000) – „Wir programmierten das System“

- 1950: Turing Test – Alan Turing, der Vater der Informatik, definiert: Wenn ein Mensch nicht unterscheiden kann, ob er mit einem Computer oder einem Menschen kommuniziert, gilt die Maschine als intelligent

- 1956: Der Begriff „AI“ wird offiziell geprägt.

- Ende 1950er: LISP – Erste KI-Programmiersprache (List Processing), basiert auf Rekursion. Erstmals implementiert auf IBM 704. Sehr komplex, aber elegant. Wichtig: Um das System intelligenter zu machen, musste man mehr Code schreiben.

- 1960er: ELIZA ist ein Computerprogramm welches zwischen 1964 und 1966 von MIT Professor Joseph Weizenbaum entwickelt wurde. Dieses ermöglicht die Kommunikation mit einem Rechner in natürlicher Sprache. Der erste Chatbot! Erste primitive natürliche Sprachverarbeitung. Menschen fühlten sich verstanden, obwohl es nur Mustererkennung war.

- 1970er: Prolog (Programming in Logic) – Statt Rekursion nun regelbasiert: Man definierte Regeln und Beziehungen, das System zog Schlussfolgerungen. Aber wieder: Mehr Intelligenz = mehr Code schreiben

- 1980er: Expert Systems – Grosser Hype! Systeme sollten Expertenwissen simulieren und Ratschläge geben. Geschäftswelt investierte massiv. Resultat: Enttäuschung. Systeme waren „brittle“ (spröde), nicht anpassungsfähig, lernten zu langsam.

- 1997: Deep Blue schlägt Kasparov – IBM-Meilenstein! Erstmals besiegt ein Computer den besten Schachspieler der Welt. Man dachte, das sei unmöglich – Schach erfordert Strategie, Kreativität, Genialität. Dieser Sieg löste neue KI-Begeisterung aus

Der Paradigmenwechsel: Lernende Systeme (ab 2000) – „Das System lernt selbst“

- Um 2000: Machine Learning (ML) & Deep Learning (DL) – Diese Technologien existierten bereits in der Forschung, wurden aber jetzt weit verbreitet

- Machine Learning: Mustererkennung auf Steroiden – System sieht viele Beispiele, erkennt Muster, trifft Vorhersagen. Lernt durch Daten, nicht durch Programmierung

- Deep Learning: Simuliert menschliche Intelligenz durch neuronale Netzwerke

- Revolutionär: Statt Code zu schreiben, zeigen wir dem System Beispiele. Es lernt selbst. Kann Muster in gigantischem Massstab erkennen, was für Menschen unmöglich wäre

- 2011: IBM Watson gewinnt Jeopardy! – Noch schwieriger als Schach! Watson musste natürliche Sprache verstehen (Wortspiele, Redewendungen, „Es regnet Katzen und Hunde“). Breites Wissen über viele Themen. Musste blitzschnell antworten und Konfidenz berechnen. Schlug zwei Jeopardy!-Champions drei Abende hintereinander. Interessant: Kam viel später als Schach-Sieg, weil Sprache und breites Wissen schwieriger sind als strategisches Denken

Wie in diesem Kommentar in unserem Blog erwähnt, werden im Video unten 2 von 3 wichtigen Meilensteine der KI Geschichte 2026 für die maschinelle Textverarbeitung (1954 und 2016) nicht erwähnt:

- 1954 – Georgetown-IBM-Experiment – langsame aber konstante Fortschritte – Textverarbeitung – Anfang von Machine-Learning

- 1966 – Chatbot – ist erfunden – wird oben (siehe auch Video) erwähnt

- 2016 – Google – von strukturellen, regelbasierten Systemen, die sich auf grammatikalische Strukturen stützen, zu statistischen Modellen und neuronaler maschineller Übersetzung

Die KI wird real: Generative AI & Agenten (2022-2025)

- 2022: ChatGPT-Moment – Generative AI auf Basis von Foundation Models. Für viele Menschen wurde KI jetzt erst „real“. Plötzlich hatten wir Chatbots, die wie Experten wirkten, über alles sprechen konnten, Reports schrieben, E-Mails zusammenfassten. Nicht mehr wie ELIZA mit begrenzten Fähigkeiten, sondern wirklich konversationell und vielseitig. Generiert nicht nur Text, sondern auch Bilder, Sounds – und Deepfakes (gut und schlecht!)

- 2025: Jahr der AI Agents – Agentische KI mit mehr Autonomie. Wir geben Ziele vor, der Agent nutzt verschiedene Services eigenständig, um diese zu erreichen

Die Zukunft: Vom schmalen zum allgemeinen zur Super-Intelligenz

- Heute: Artificial Narrow Intelligence (ANI) – Intelligenz in spezifischen Bereichen

- Nächster Schritt: Artificial General Intelligence (AGI) – So smart oder smarter als Menschen in im Grunde jedem vorstellbaren Bereich

- Danach: Artificial Super Intelligence (ASI) – Übertrifft menschliche Fähigkeiten bei weitem in einer Vielzahl von Bereichen

72 Jahre Fortschritt: Von Schneckentempo (Jahrzehnte minimaler Fortschritte) zu „off to the moon“ seit Machine Learning und Generative AI. Jahrzehntelang war KI ein Wunschtraum. Plötzlich scheint KI alles zu können. Aber kann sie wirklich?

Turing Award 2019: Die drei KI-Pioniere im Interview

Yoshua Bengio, Geoffrey Hinton und Yann LeCun teilten sich 2019 den Turing Award, die weltweit höchste Auszeichnung in der Informatik, für ihre Arbeit an Machine Learning und neuronalen Netzwerken. Das vollständige Interview mit 2 der 3 Preisträgern können Sie auf der DrKPI AI Wiki Seite ansehen.

Yann LeCun, der seine Postdoc-Arbeit in Hintons Labor an der University of Toronto absolvierte, äußerte sich kürzlich kritisch zu aktuellen KI-Entwicklungen. Im Financial Times Interview vom 3./4. Januar 2026 (Life & Arts, S. 3) diskutiert er die Grenzen heutiger Large Language Models und seine Vision für die Zukunft der KI.

Jahr oder Jahrzehnt der KI-Agenten?

Das zweite Video von IBM stellt die Frage ob wir bis zur Realisierung von perfekten KI-Agenten 1 Jahr oder noch 10 Jahre brauchen.

Ist 2026 das Jahr der KI-Agenten? OpenAI-Mitgründer Andrej Karpathy malt ein differenzierteres Bild: Es ist eher das Jahrzehnt der KI-Agenten. Heutige Systeme werden teilweise überverkauft und kämpfen noch mit grundlegenden Aufgaben. Martin Keen untersucht drei Use Cases und bewertet sie anhand von vier Kernfähigkeiten: Intelligence, Computer Use, Multimodale Fähigkeiten und Continual Learning.

Use Case 1: Coding-Assistenten ✅ (Funktioniert heute)

- Schreiben Code, beheben Bugs, generieren Dokumentation, reviewen Pull Requests

- Warum sie funktionieren: Code ist strukturiert, hat klare Regeln, klare richtig/falsch-Antworten. KI-Modelle sind hervorragend im Mustererkennen über Millionen Code-Beispiele. IDEs sind gut definierte Interfaces. Alles textbasiert. Programmiersprachen entwickeln sich langsam und sind gut dokumentiert.

- Spielt perfekt zu den Stärken heutiger KI-Modelle

Use Case 2: Reisebuchung ⚠️ (Teilweise funktionsfähig)

- Flüge buchen, Hotels vergleichen, Kalender managen

- Happy Path funktioniert: Direktflüge und Standard-Hotels kein Problem

- Grenzen: Edge Cases killen es – verspätete Flüge, Visa-Anforderungen, Reisen mit Kleinkind. Jede Airline/Hotel hat unterschiedliche UIs, CAPTCHAs, Authentifizierung. Multimodale Herausforderungen (z.B. Hotelkarten lesen: Ist das Hotel wirklich fussläufig?). Continual Learning fehlt – Agent muss persönliche Präferenzen über Zeit lernen, nicht nur aus Profil-Einstellungen.

- Fazit: Beeindruckend in Demos, aber noch nicht zuverlässig genug für echte Reisen ohne Aufsicht

Use Case 3: Automatisierter IT-Support 🔮 (Aspirational)

- Nicht nur Helpdesk-Antworten, sondern: Autonom ins System einloggen, Problem diagnostizieren, Fix installieren – ohne menschliche Zustimmung

- Warum es noch nicht funktioniert: Jedes Setup ist einzigartig und „quirky“. Outlook-Probleme können korrupte Dateien, Proxy-Einstellungen oder abgelaufene Zertifikate sein – endlose Edge Cases. Computer Use zu komplex: Windows vs. Mac, verschiedene Apps, alles auf Produktionssystemen. Multimodal nötig: Screenshots, verbale Beschreibungen („es macht wieder das Ding“). Continual Learning essentiell: Muss aus tausenden Support-Interaktionen lernen, was in DEINEM spezifischen Environment funktioniert.

- Vertrauensfrage: Würdest du einem autonomen Agenten freie Hand auf deinem Laptop geben? Wohl kaum.

Fazit: AI Agents 2026 – Jahr UND Jahrzehnt

- Jahr der KI-Agenten: Für eng definierte Aufgaben in strukturierten Umgebungen (wie Coding)

- Jahrzehnt der KI-Agenten: Für die breitere Vision – messy Real-World-Probleme, zuverlässige Computer-Nutzung, echtes multimodales Verständnis, adaptives Lernen

Wenn ein KI-Agent heute anbietet, deinen Laptop autonom zu reparieren – lass ihn lieber erstmal seine Arbeit zeigen.

DeepSeek Durchbruch: 60 Jahre alter Algorithmus revolutioniert KI

Während US-Konzerne Milliarden in Rechenleistung investieren, zeigt DeepSeek aus China: Manchmal liegt Innovation in der Mathematik der Vergangenheit. Der Sinkhorn-Knopp-Algorithmus aus 1967 löst ein fundamentales Problem tiefer neuronaler Netze – wenn man viele Schichten stapelt, explodieren oder verschwinden Signale (Verstärkung bis 3000x).

DeepSeeks Lösung: Reine lineare Algebra statt Workarounds. Resultat: Signalverstärkung von 3000x auf 1,6x reduziert, nur 6,7% zusätzlicher Trainingsaufwand. Das macht DeepSeek „lean-and-mean“ gegenüber ChatGPT und Gemini.

Details bei Noah Karrers LinkedIn-Analyse und im DeepSeek-Forschungspapier. Eine vertiefte Erklärung bietet das Paper „On the Convergence of the Sinkhorn-Knopp Algorithm“.

Die DeepSeek-Forscher testeten die neue Architektur Manifold-Constrained Hyper-Connections (mHC) an Modellen mit 3, 9 und 27 Milliarden Parametern. Ergebnis: stabile Skalierung ohne nennenswerte zusätzliche Rechenlast oder die sonst üblichen Instabilitäten beim Modellwachstum.

Während führende KI-Labore meist auf Brute Force setzen – mehr Daten, mehr Rechenleistung, mehr Parameter – zeigt DeepSeek einen effizienteren Weg. Dieser Ansatz wird zunehmend ineffizient und ist nur für wenige Grosskonzerne finanzierbar.

Die mHC-Architektur könnte das Vortraining grosser Modelle grundlegend verändern: KI wird intelligenter skaliert statt einfach vergrössert. Das ist nicht nur algorithmisch eleganter, sondern auch deutlich hardwarefreundlicher.

Ein weiterer Vorteil: mHC lässt sich vergleichsweise einfach in kundenspezifische Hardware integrieren – ein relevanter Faktor für Unternehmen, die kosteneffiziente KI-Lösungen suchen.

In einem LinkedIn-Beitrag betont Pierre-Carl Langlais, Mitgründer des französischen KI-Startups Pleias, dass die eigentliche Bedeutung über reine Skalierbarkeit hinausgeht. Die tatsächliche Flexibilität liege darin, jede Dimension der Trainingsumgebung neu gestalten zu können – ein Merkmal echter Pionierlabore.

Bemerkenswert ist zudem, dass DeepSeek seine Arbeiten weiterhin als Open Source veröffentlicht. Innovationen werden nicht nur entwickelt, sondern bewusst geteilt – wodurch das gesamte KI-Ökosystem profitiert.

Die Lektion: Elegante Mathematik schlägt rohe Rechengewalt.

„LinkedIn ist oft mehr Show als Substanz.“

Urs antwortet: Ja, aber manchmal findet man echte Perlen. DeepSeek zeigt: Ein 60 Jahre alter Algorithmus kann moderne KI-Probleme lösen. LinkedIn als Rolodex? Ja. Aber solche Insights rechtfertigen zumindest gelegentliches Scrollen – wie der Eintrag von Noah Karrer.

Urs

#AIinMarketing #AIGovernance #DrKPI

KI, KMU, Strategie und Trends – kompakt erklärt.

Jetzt Newsletter abonnieren und keine Insights mehr verpassen wie z.B. zum Thema LinkedIn oder Content Marketing!

Produktivitätseffekte und Verkauf: Zwischen Hoffnung und Unsicherheit

Neun Studien, die den Anstieg des jährlichen Produktivitätswachstums durch KI-Einsatz quantifizieren wollten, kamen zu dramatisch unterschiedlichen Schätzungen:

- Niedrigste Schätzung: 0,1 Prozentpunkte (marginaler Effekt)

- Höchste Schätzung: 3,4 Prozentpunkte (Verdopplung der Wachstumsraten)

Die Bandbreite zeigt: Niemand weiss wirklich, welchen wirtschaftlichen Impact KI haben wird. Wir haben diese Problematik inklusive einen Teil dieser Studie im Blog diskutiert. Zum Beispiel:

- Buchhaltung mit KI – leichte Verbesserung vor allem bei Routinearbeiten

- Programmierung mit KI – meistens brauchen die Programmiererinnen mehr Zeit mit KI als ohne, da sie den effektiven Zeiteinsatz unterschätzen, welcher in der Studie gemessen wurde. Der Code muss ebenfalls auf Fehler überprüft werden.

- Microsoft 365 – Die Nutzung von Cloud Services und KI aber auch Slack, Outlook, etc. führt gemäss Daten die Microsoft von Nutzern sammelt zu gut 153 Team Nachrichten, 117 E-Mails, und gemäss DrKPI Daten zu über 100 Nachrichten auf Signal/WhatsApp und dem Smartphone wie Push Nachrichten.

- Workslop – KI verursachte Kosten – Workslop beschreibt minderwertige, KI-generierte Arbeit. Jeder Vorfall verursacht im Schnitt fast 2 Stunden Zusatzarbeit – rund 186 US-Dollar pro Mitarbeiter und Monat.

- 45 % der Antworten von ChatGPT, Copilot, Gemini und Perplexity mindestens ein wesentliches Problem aufwiesen – von falschen Quellen bis zu erfundenen Fakten. Das eine grosse Studie in Dänemark von tausenden von Teilnehmern aus verschiedenen Berufen klar aufzeigte das bis anhin KI keine signifikanten Produktivitätsgewinne brachte.

- Chatbot User Experience Fail: Beispiele von Hertz, SBB und Deutsche Bahn zeigen die Problematik – mehr Zeitaufwand für Kunden, weniger zufriedenstellende Lösungen. Nach unserer Review wurde z.B. der Chatbot von Yallo abgestellt.

- CRA Chatbot-Debakel (Kanada): Die Canada Revenue Agency (CRA) gab fast 20 Millionen Dollar für einen KI-Chatbot namens „Charlie“ aus, der Steuerzahlern bei der Steuererklärung helfen sollte. Das Ergebnis laut Auditor General Karen Hogan: Nur 44% der Antworten waren korrekt (2 von 6 Test-Fragen richtig), während andere öffentliche KI-Tools 83% erreichten (5 von 6 richtig). 13,67 Millionen Dollar gingen für Gehälter drauf, 3,21 Millionen für IT-Consultants. Ein Paradebeispiel für KI-Implementierung ohne ausreichende Qualitätssicherung.

- Hype-Produktivitätslücke: Eine dänische Studie mit 25.000 Arbeitnehmern, 7.000 Betrieben aus 11 Berufsgruppen untersuchte die Auswirkungen von KI-Chatbots. Während Marketingfachleute Produktivitätssteigerungen von 6,8 % angaben, waren es bei Lehrern nur 0,6 %. Arbeitgeber investieren zwar und Arbeitnehmer nutzen sie vielleicht auch, aber bisher sind Chatbots noch weit davon entfernt, den Arbeitsplatz grundlegend zu verändern.

- 95 % der KI-Investitionen in Unternehmen bleiben erfolglos: Eine Studie des MIT weist auf Mängel bei der Integration in Unternehmen hin. Generische Tools wie ChatGPT eignen sich aufgrund ihrer Flexibilität hervorragend für Einzelpersonen. Diese scheitern jedoch im Unternehmensbereich, da sie nicht aus Arbeitsabläufen lernen oder sich an diese anpassen.

- Fear of Missing Out (FOMO): Amerikas grösste Unternehmen präsentieren KI in Earnings Calls durchweg positiv. Doch während 87 % der Telefonkonferenzen zu den Geschäftsergebnissen euphorisch klingen, zeigen die pflichtgemäss detaillierten Angaben in SEC-Dokumenten (SEC = Börsenaufsicht) eine klare Diskrepanz: Risiken (z.B. Cybersecurity 50 %+ Nennungen) werden präziser belegt als Nutzen. Laut FT-Analyse fehlen in den meisten Fällen harte Belege für ROI oder Umsatzsteigerungen – selbst bei den optimistischsten Prognosen.

- KI im Customer Support: 14% Produktivitätssteigerung: Forscher analysierten 5.200 Service-Mitarbeitende eines Fortune-500-Unternehmens. KI-gestütztes Assistenzsystem mit Echtzeit-Antwortvorschlägen steigerte Produktivität um 14%, bei unerfahrenen Mitarbeitenden sogar um 35%. Entscheidend: KI ergänzte menschliche Arbeit statt sie zu ersetzen – ähnlich wie Expertensysteme der 1980er Jahre.

📘 Praxiswissen zu KI, Produktivität und Strategie

Wir unterstützen Sie dabei, Arbeitsprozesse KI-fit zu machen – von der Kompetenzprüfung über Weiterbildung bis hin zur technischen Umsetzung und Engineering.

Schlussfolgerung KI Geschichte 2026: 3 Empfehlungen für den realistischen KI-Einsatz

Die 72-jährige Geschichte der KI lehrt uns: Von Turing bis ChatGPT war es ein langer Weg vom Programmieren zum Lernen. Doch wie die Analyse der AI Agents zeigt, funktioniert KI heute recht gut wenn nicht sogar hervorragend in strukturierten Umgebungen (z.B. Coding), kämpft aber noch mit der Komplexität der realen Welt (z.B. Planung einer Ferienreise oder IT-Support).

Drei zentrale Fragen prägen 2026: Stösst die Skalierung an Grenzen? Können tragfähige Geschäftsmodelle entstehen, wenn KI zur Massenware wird? Und wie wirken sich Regulierungen wie der EU AI Act auf die globale Wettbewerbsfähigkeit aus? Wie schlagen sich US-Unternehmen gegen schlanke, kostengünstige chinesische Open-Weight-Modelle wie DeepSeek, oder Frankreich’s Mistral die bereits fast 20% aller Downloads in Europa ausmachen?

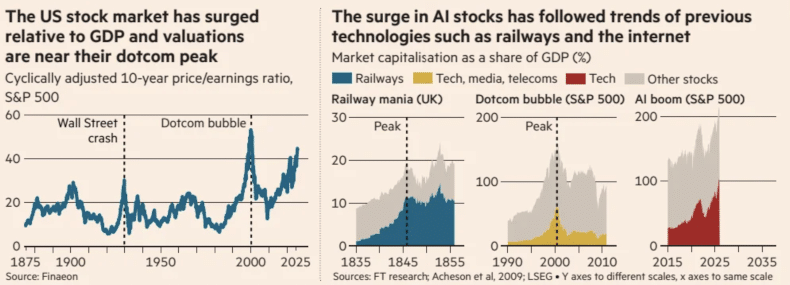

KI-Blase? Historische Parallelen zum Dotcom-Boom

Die aktuellen Bewertungen von US-Technologieaktien erreichen Niveaus, die zuletzt während des Dotcom-Booms 1999zu beobachten waren – und wecken entsprechende Warnungen.

Während KI „allgemein als transformativ angesehen wird und das Potenzial hat, das globale Produktivitätswachstum erheblich zu steigern“, bleiben ihre tatsächlichen Auswirkungen höchst ungewiss, wie das britische Office for Budget Responsibility (OBR) in einem Briefing-Papier vom November 2024 feststellte.

Marktkonzentration erreicht historische Extreme

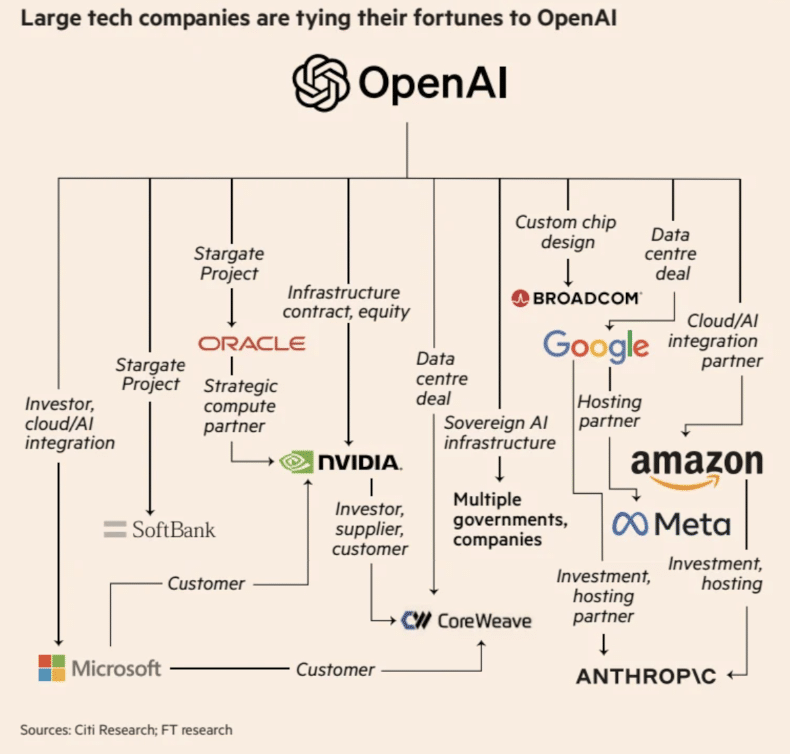

Die fünf Hyperscaler (Amazon, Alphabet, Microsoft, Meta, Oracle) plus Halbleiterhersteller (Nvidia, Broadcom) machen 28% der S&P 500 Marktkapitalisierung aus.

Die Marktkapitalisierung US-Tech-Unternehmen explodierte seit ChatGPTs Start im Oktober 2022. Laut Financial Times (2026) stieg sie um über 70%.

S&P 500 als Anteil am US-BIP: Von 142% (Oktober 2022) auf 214% (Anfang 2026) – Rekordwert. Technologieaktien-Anteil: Von 44% auf 101% mehr als verdoppelt.

Rekordwerte seit ChatGPT-Launch

Financial Times – OpenAI’s computing deals exceed $1tn in bet on future profitability

Die Frage bleibt: Rechtfertigen die unsicheren Produktivitätseffekte diese historischen Bewertungen – oder wiederholt sich die Geschichte von 1999?

Grafik unten von Fears over AI ‚bubble‘ stir warnings from history

Unsere 3 Empfehlungen für den effektiveren KI-Einsatz

Aus den von uns präsentierten Informationen oben lassen sich 3 Empfehlungen ableiten (siehe auch Financial Times).

1. Realistische Erwartungen setzen – KI ist kein Allheilmittel. Nutzen Sie sie dort, wo sie heute funktioniert (strukturierte Aufgaben), nicht wo sie noch kämpft (komplexe Edge Cases). Verstehen Sie den Unterschied zwischen AI Security und AI Safety, um Risiken richtig einzuschätzen.

2. Geschäftsmodelle kritisch prüfen – Nicht jedes KI-Unternehmen schafft nachhaltigen Wert. Unterscheiden Sie zwischen echtem Mehrwert und Hype-Surfern. Tech-Giganten mit bestehenden Services (Alphabet, Amazon, Microsoft) haben Vorteile gegenüber Start-ups ohne bewährte Wettbewerbsvorteile.

3. Open-Weight Modelle im Blick behalten – Chinesische Modelle sind schlanker, kostengünstiger und anpassungsfähiger. Selbst Sam Altman gibt zu, OpenAI könnte „auf der falschen Seite der Geschichte“ stehen. Flexibilität wird 2026 zum Wettbewerbsvorteil.

PS. Ein Open-Weight Modell ist ein KI-Sprachmodell, dessen trainierte Parameter – also die gelernten Gewichtungen (Weights) – frei zugänglich sind; es lässt sich dadurch analysieren, testen und weiter trainieren.

Was bedeutet das für Arbeitnehmer 2026?

Während technische Fähigkeiten gefragter werden, bleiben Soft Skills unverzichtbar. Drei Fähigkeiten werden in den kommenden Jahren entscheidend sein:

1. Selbstgesteuertes Lernen: Die Fähigkeit, sich selbst weiterzubilden, ohne dazu aufgefordert werden zu müssen. KI-Tools entwickeln sich schneller als Trainingsprogramme.

2. Wissensdurst: Neugier und der Wille, neue Technologien zu verstehen (nicht nur zu nutzen). Wer fragt „Warum funktioniert das?“ statt nur „Wie benutze ich das?“ bleibt relevant.

3. Kollaborative Intelligenz: Der Wunsch, anderen zu helfen, insbesondere Kollegen im eigenen Team. KI ersetzt keine Teamarbeit, sondern macht sie wichtiger.

Die KI-Technologie und damit auch unsere Arbeitsplätze entwickeln sich weiter, aber Menschen werden so schnell nicht verschwinden. Einen Vorteil haben diejenigen, die weiter lernen und neugierig bleiben.

FAQ: KI Geschichte 2026

Was sind die wichtigsten Meilensteine der KI Geschichte bis 2026?

Die KI-Entwicklung begann 1950 mit Alan Turings Test. Wichtige Etappen: LISP (1950er), ELIZA Chatbot (1966), Expert Systems (1980er), Deep Blue schlägt Kasparov (1997), IBM Watson gewinnt Jeopardy (2011), Google neuronale maschinelle Übersetzung (2016), ChatGPT-Launch (2022) und AI Agents 2025. Der fundamentale Wandel: Von „wir programmieren das System“ zu „das System lernt selbst“.

Funktionieren AI Agents 2026 wirklich zuverlässig?

Kommt auf den Use Case an. Coding-Assistenten funktionieren heute hervorragend in strukturierten Umgebungen. Reisebuchung ist teilweise funktionsfähig (Happy Path ja, Edge Cases nein). Automatisierter IT-Support bleibt aspirational – Vertrauen und Komplexität sind zu hoch.

Steigert KI wirklich die Produktivität in Unternehmen?

Die Datenlage ist gemischt. Stanford-Studie zeigt 14% Produktivitätssteigerung im Customer Support, bei unerfahrenen Mitarbeitenden sogar 35%. Eine dänische Studie mit 25.000 Arbeitnehmern zeigt: Marketingfachleute melden 6,8% Produktivitätssteigerung, Lehrer nur 0,6%. Doch MIT-Studie warnt: 95% der KI-Investitionen bleiben erfolglos. Neun Studien schätzen Produktivitätsgewinn zwischen 0,1% und 3,4% – niemand weiss es genau.

Droht eine KI-Blase wie beim Dotcom-Crash 1999?

Die Parallelen sind beunruhigend. S&P 500 als Anteil am US-BIP stieg von 142% (Oktober 2022) auf 214% (Anfang 2026) – Rekordwert. CAPE Ratio erreicht Dotcom-Niveau von 2000. Technologieaktien-Anteil verdoppelte sich auf 101% des BIP. Die Financial Times warnt vor historischen Überbewertungen.

Was unterscheidet DeepSeek von westlichen KI-Modellen?

DeepSeek nutzt den 59 Jahre alten Sinkhorn-Knopp-Algorithmus aus 1967 zur Signalstabilisierung. Resultat: Signalverstärkung von 3000x auf 1,6x reduziert, nur 6,7% zusätzlicher Trainingsaufwand. Das macht DeepSeek „lean-and-mean“ gegenüber ChatGPT und Gemini – elegante Mathematik schlägt rohe Rechengewalt.

Fazit: Vom papierlosen Büro zum KI-gestützten Blog – ein Déjà-vu der Effizienz?

Ende der 1990er-Jahre träumten wir vom papierlosen Büro – heute ist der Berg an Dokumenten nur digital geworden. Statt Aktenordner produzieren wir Endlos-Schleifen von Reports und E-Mails.

Ähnlich bei diesem Blogbeitrag: Die intellektuelle Vorarbeit – Ideen entwickeln, Studien sichten, Argumente schärfen – bleibt menschliche Kernarbeit. Die KI übernimmt mechanische Aufgaben: Stil glätten, HTML anpassen. Zeitersparnis? Kaum. Qualitätsgewinn? Das urteilen Sie. Vielleicht ist der Fortschritt nicht die Mengenreduktion, sondern die Freiheit, sich auf das Wesentliche zu konzentrieren.

Die KI-Begeisterung ist gerechtfertigt – wenn die Technologie sinnvoll eingesetzt wird. 2026 trennt sich die Spreu vom Weizen. Doch wie messen wir diesen Erfolg? Das Bruttoinlandprodukt (BIP) konzentriert sich auf statistische Infrastruktur in globalen Produktionsnetzwerken. Wie Coyle (2025) betont: Digitale Technologien haben Produktion verändert, doch Messungen fehlen – etwa der CO2- und Wasser-Fussabdruck von KI.

📜 DrKPI CyTRAP AI-Verantwortlichkeitserklärung: Beitrag mit KI-Unterstützung angepasst; Inhalte wurden geprüft und verantwortet.

Hashtags: #AIinMarketing #AIGovernance #DrKPI

2 Antworten

Sehr guter Überblick!

Die 3 Use Cases machen es greifbar: Coding ✅, Reisebuchung 🟡, IT-Support ❌

Die KI-Geschichte zeigt: Nach 70+ Jahren Hype-Zyklen sind wir endlich bei pragmatischer Bewertung angekommen.

Die Frage bleibt: Wann brechen Agents wirklich durch – 2026 oder erst 2030+? 👀

Danke, Roby, für diesen wichtigen Hinweis.

Die drei Use Cases zeigen gut, warum wir bei Agents zwischen Hype und Realität unterscheiden müssen. Die KI-Geschichte lehrt, dass Durchbrüche selten plötzlich kommen, sondern in klar abgegrenzten Anwendungsfällen mit stabilen Daten, klaren Prozessen und messbarem Nutzen.

Aus DrKPI-Sicht werden wir 2026 erste produktive Agenten sehen – vor allem dort, wo Aufgaben standardisiert sind und Risiken beherrschbar bleiben. Der breite Durchbruch scheitert weniger an der Technologie als an Governance, Haftung, Datenqualität und ökonomischen Anreizen.

Entscheidend ist vielleicht wengier ob Agents kommen, sondern wo sie sinnvoll sind, welche KPIs ihren Nutzen belegen und wo menschliche Verantwortung zwingend bleibt. Genau diese Differenzierung fehlt oft in der aktuellen Debatte.

Urs

#DigitalMarketing #AIrisks #DrKPI