Wissen kompakt für April 2024 zum Thema AI und Klimawandel inklusive Clout Computing, Wasserverbrauch und Strombedarf (siehe auch CyTRAP Quiz im DrKPI Newsletter).

Vor kurzer Zeit habe ich einen Blogeintrag zum Thema Übertreibung und Marketing gepostet. Da ging es vor allem um die Hyperbole im Marketing die mich immer mehr nervt.

Heute geht es um AI und Cloud Computing oder Server Farmen. Auch hier ist oft Übertreibung der besonderen Art zu finden. Mit Cloud Computing und ausgelagerten Data-Centers werden wir es richten, doch:

- Was ist mit AI und Klimawandel?

- Wieviel Energie und Süsswasser kostet uns diese AI Entwicklung und den notwendigen Server Farmen?

AI und Cloud-Computing sind Energiefresser, welche zugleich weltweit Unmengen von Süsswasser zur Kühlung der Server-Farmen verschlingen.

Wohin geht die Reise?

1. Cloud Computing und AI: In diesem Beitrag zeigen wir auf wie wichtig Cloud-Computing für AI geworden ist.

2. #DrKPIcheck AI Metrics Ratgeber: Für Praktiker:innen haben wir unten eine DrKPIcheck: 14-Punkte Leitfaden für den effektiven Audit von AI Modellen zusammengestellt (Publikation erfolgt am 30. April).

Scrollen Sie nach unten, Fakten zu AI und Klimawandel, inkl. Kennzahlen werden weiter unten aufgezeigt.

Download WHITE PAPER Bundesverband Marketing Clubs – AI im Marketing – Gattiker, Temmen und Sinistra, 2019

Ihre Meinung ist gefragt, hinterlassen Sie bitte einen Kommentar.

2024-04-13 AI und Chatbots: Was wissen wir?

Der Begriff „künstliche Intelligenz“ wird häufig verwendet, um Roboter, selbstfahrende Autos, Gesichtserkennungstechnologie und fast alles andere zu beschreiben, was auch nur annähernd futuristisch erscheint.

Bei der traditionellen KI oder AI geht es darum, eine bestimmte Aufgabe intelligent auszuführen. Um dies zu tun, wurde in einem Programm ein grosses Set von Regeln programmiert. Mit Hilfe dieser Regeln kann z.B. der Computer die Züge eines Schach-Kontrahenten vorhersagen und seine eigenen auf der Grundlage einer vordefinierten Strategie ausführen.

Er erfindet keine neuen Wege, um Schach zu spielen, sondern wählt aus den Strategien aus, mit denen er programmiert wurde. Das ist traditionelle KI – sie ist wie ein Meisterstratege, der innerhalb eines bestimmten Regelwerks intelligente Entscheidungen treffen kann.

Andere Beispiele für traditionelle KI sind Sprachassistenten wie Siri oder Alexa, Empfehlungsmaschinen auf Spotify oder Amazon oder der Suchalgorithmus von Google oder Bing.

Diese AI wurde darauf trainiert, bestimmte Regeln zu befolgen. Es soll eine bestimmte Aufgabe gut erfüllen und erledigen. Nichtsdestotrotz, sie schafft nichts Neues.

Mehr einfach verständliche Erklärungen findest du im DrKPI AI Wiki.

Was ist Generative AI?

Generative KI kann man sich als ein maschinelles Lernmodell oder “machine-learning model” vorstellen. Es ist darauf trainiert, neue Daten zu erzeugen.

Generative AI soll also nicht wie das traditionelle AI eine Wettervorhersage über die nächsten 10 Tage erstellen (siehe GraphCast von Google)

Generative AI soll Neues erschaffen wie z.B. Text oder ein Foto.

Generative künstliche Intelligenz (generative AI, GenAI) ist in der Lage, verschiedene Arten von Inhalten wie Texte, Bilder, Videos oder andere Daten mit Hilfe generativer Modelle zu erzeugen.

Generative AI ist also eine Art von AI, die aus vorhandenen Daten lernen kann, um neue, realistische Artefakte zu erzeugen. Diese widerspiegeln die Eigenschaften der Trainingsdaten. Sie wiederholen diese aber nicht!

Was ist ein Chatbot?

Jede Software, die eine menschliche Konversation simuliert, ist ein Chatbot.

Dies ist unabhängig davon, ob die Konversation mit dem Chatbot auf einer traditionellen, starren Entscheidungsbaum-Menüführung oder auf modernster konversationeller AI basiert.

Konversationelle AI konzentriert sich auf menschliche Unterhaltungen. Sie ermöglicht eine Zwei-Wege-Kommunikation zwischen Menschen und Softwareanwendungen wie Chatbots, Sprachbots und virtuellen Agenten.

Konversationelle AI nutzt die Verarbeitung natürlicher Sprache (NLP – Natural Language Processing), um menschliche Eingaben (Text und Sprache) zu interpretieren. Ebenfalls führt sie eine Stimmungsanalyse durch, um die zugrunde liegende Stimmung zu erkennen. Die Erzeugung natürlicher Sprache (NLG) wird dabei genutzt, um eine menschlich klingende Antwort oder Output zu erstellen.

Ein auf generative AI aufgebauter Chatbot konzentriert sich jedoch auf die Erstellung von Inhalten in verschiedenen Formen.

Ein AI-Chatbot (auch AI-Writer genannt) ist ein von künstlicher Intelligenz gesteuertes Programm, das in der Lage ist, auf der Grundlage der Eingabeaufforderung eines Nutzers schriftliche Inhalte zu erstellen.

AI-Chatbots können auf Anfrage eines Nutzers alles schreiben, von einem Rap-Song bis hin zu einem Definition einer seltenen Krankheit. Das Ausmass dessen, worüber jeder Chatbot schreiben kann, hängt von seinen Fähigkeiten ab, einschließlich der Frage, ob er mit einer Suchmaschine verbunden ist.

Viele Firmen haben z.B. auf deren Website einen Chatbot. Dieser ermöglicht es Kunden, Fragen zu stellen. Beispiele sind Fragen zur letzten Rechnung oder aber der Versuch, mehr Informationen über ein Spezialangebot zu erhalten.

Meistens werden hier Antworten nach einem starren Entscheidungsbaum beantwortet. Wenn sich dann der Bot nicht mehr zu helfen weiss, wird der Kunde vom Bot an einen Mitarbeiter weitergereicht.

Was ist der Unterschied zwischen dem Konversations-Chatbot und dem Generative Chatbot?

Kurz: Generative AI ist ein Werkzeug, das Inhalte in verschiedenen Formaten erstellt. Ein auf Konversations-AI basierter Chatbot kann „nur“ mit Benutzern kommunizieren.

Konversations-AI-Systeme werden in der Regel auf kleineren Datensätzen von Dialogen und Gesprächen trainiert. Ziel ist es, dass die konversationelle AI die Benutzereingaben versteht. Dies wird dann verarbeitet, um dann Antworten in Text- oder Sprachform zu erzeugen.

Der Hauptzweck von Konversations-AI ist also, die interaktive Kommunikation zwischen Maschinen und Menschen zu erleichtern.

Generative AI-Tools sind hingegen darauf ausgelegt, durch das Lernen aus den Daten Muster zu erkennen und daraus Neue Inhalte oder Fotos zu erzeugen.

Im Gegensatz zu konversationellen AI-Engines besteht die Hauptfunktion der Generativen-AI in der Generierung von Originalinhalt.

2024-04-14 AI und Cloud Computing: Was wissen wir?

AI scheint dazu bestimmt zu sein, eine doppelte Rolle zu spielen. Einerseits bieten AI-gestützte Technologien bisher ungekannte Möglichkeiten, enorme Datenmengen zu verarbeiten, aufschlussreiche Erkenntnisse zu gewinnen und Vorhersagemodelle zu verbessern. Ebenfalls ermöglicht AI den Aufbau intelligenter Stromnetze, der Entwicklung emissionsarmer Infrastrukturen und der Modellierung wie z.B. Wettervorhersagen.

Andererseits ist AI selbst ein erheblicher Verursacher von Kohlenstoffemissionen oder einem nicht zu unterschätzenden CO₂ Ausstoss.

Forscher schätzten, dass der Kohlenstoff-Fussabdruck des Trainings eines einzigen grossen Sprachmodells etwa 300.000 kg Kohlendioxid-Emissionen entspricht.

Dies entspricht der Grössenordnung von:

- 125 Hin- und Rückflügen zwischen New York und Peking oder Peking und Europa.

Um ein vollständiges Bild zu erhalten, müssen die Auswirkungen der Infrastruktur rund um den Einsatz von AI durch Big Tech genauer betrachtet werden. Hier geht es z.B. um Data Centers und deren Auswirkungen auf die Umwelt.

Cloud Computing und Data-Centers mit Server-Farmen spielen hier eine kritische Rolle, die wir unten ein wenig genauer beleuchten.

Was ist Cloud Computing?

Einfach ausgedrückt: Cloud Computing ist die Bereitstellung von Computing-Diensten wie Datenspeicherung, Servern, Datenbanken, Netzwerken und Software über das Internet.

Der Cloud Provider stellt also Rechenleistung, Speicherplatz, Datenbanken, Server und mehr für Konsumenten und Firmen bereit.

Wir alle nutzen Cloud für Rechenleistungen und Hardware. Ein KMU hat z.B. seine Website in der Cloud gehostet. Die Konsumentin lud ihre privaten Schnappschüsse in die Apple Cloud hoch. Vielleicht hört sie mit Hilfe vom Handy und mobile Internet auf der Tramfahrt zu Bekannten ihre Playlist über einen Streaming Service.

Auch um an einem Meeting auf Zoom teilzunehmen oder durch den Facebook-Feed zu scrollen, brauchen wir Ressourcen aus der Cloud.

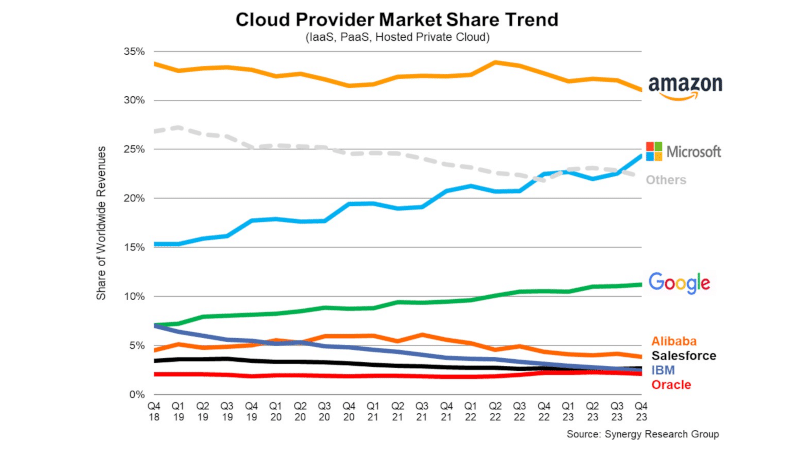

Tech Firmen: Wer dominiert den Cloud Computing Markt?

Der Data-Center Markt wird von mehreren US-amerikanischen Anbietern dominiert. In der EU haben Amazon, Microsoft, Google & IBM mehr als ¾ vom Cloud Computing Markt.

Im 4. Q. 2022 hatte:

- AWS ca 32 – 34 %,

- Microsoft 23 % und

- Google 11 % (siehe Grafik)

des weltweiten Cloud-Computing-Marketes.

Im 4. Q. 2023 hatte.

- AWS 31 %,

- Microsoft 24 % und

- Google 11 % Marktanteil weltweit.

Somit ist 2023 67% des weltweiten Cloud-Computing-Marktes in den Händen dieser 3 Konzerne (siehe Grafik unten).

Zu den Tier-2-Cloud-Anbietern mit den höchsten jährlichen Wachstumsraten gehören Huawei, China Telecom, Snowflake, MongoDB, Oracle und VMware gemäss Synergy Research Group (siehe auch Grafik unten).

Wie wichtig Cloud Computing Services für diese Firmen sind, illustriert das Beispiel von Amazon.

Obwohl AWS 2023 nur 16 % des konzernweiten Umsatzes von Amazon generierte, war es 2023 für 67 % des Betriebsgewinns von US $ 37 Milliarden verantwortlich.

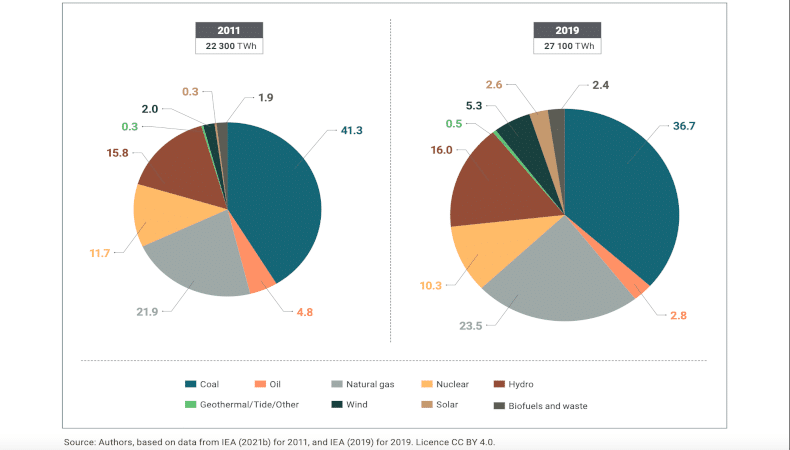

2024-04-15 AI und Klimawandel: Was wissen wir über Strombedarf und Wasserverbrauch?

AI aber auch Cloud Computing bringen uns eine steigende Nachfrage nach Strom. Dieser steigende Energiebedarf wird weit über das hinausgehen, was erneuerbare Energien und Batterien leisten können.

Das wiederum führt zu einem erhöhten CO₂ Ausstoss. Carbon Credits sollen hier helfen, diesen Kohlenstoff aus der Atmosphäre zu entfernen oder zumindest zu reduzieren. Das Pflanzen von Bäumen ist ein Weg. Es wird jedoch kritisch hinterfragt, ob das CO₂ dauerhaft entfernt wird und ob sie weitere Emissionen an anderer Stelle rechtfertigen.

Hier zeigen wir eine der Herausforderungen auf, die wir möglichst rasch angehen müssen.

Die Grafik oben können Sie hier einsehen: United Nations World Water Development Report 2024: water for prosperity and peace, Seite 65.

Server-Farmen: Stromnutzung steigt rasant

Der Strombedarf von Rechenzentren steigt sehr rasch. Cloud Computing, aber auch Krypto-Mining und AI belasten die Netzwerke zusätzlich.

Microsoft eröffnet z.B. weltweit alle 3 Tage ein neues Rechenzentrum.

Laut S&P Global Commodity Insights werden diese stromhungrigen Zentren für Cloud Computing bis 2035 zusammen mehr als 480 Terawattstunden Strom verbrauchen.

Das ist fast

- 10 % des gesamten US-Strombedarfs, gegenüber

- 4,5 % im Jahr 2025.

Auch die Internationale Energieagentur (IEA) prognostiziert eine rasche Zunahme der Nachfrage für Elektrizität wegen AI und Cloud Computing Applikation:

- 460 Terawattstunden (TWh) werden 2022 von Rechenzentren verbraucht.

Das entsprach damals 2 % des gesamten weltweiten Stromverbrauchs oder dem Energiebedarf von 🇸🇪Schweden bzw. 🇩🇪 Deutschland.

- 1.000 Terawattstunden (TWh) werden es laut Prognose der IEA im Jahr 2026 sein.

Dies entspricht in etwa dem

- gesamten Stromverbrauch 🇯🇵 Japans.

Das ist mehr als die Verdoppelung in knapp 4 Jahren:

Laut IEA befindet sich:

- ⅓ der weltweit 8,000 solcher Rechenzentren in den 🇺🇸 USA und

- 1/10 dieser Data Centers sind in 🇨🇳China.

Im obigen Forecast schreibt die IEA ebenfalls das:

- 32 % des irischen Strombedarfs im Jahre 2026 von den Rechenzentren benötigt werden.

Vielleich erklärt dies teilweise, wieso die Anträge der Rechenzentrumsbetreiber Vantage, EdgeConneX und Equinix auf Genehmigung neuer Projekte in Dublin 2023 abgelehnt wurden.

2023 kündigte Microsoft an, dass es Atomstrom kaufen würde, um bis zu 35 % des Energiebedarfs eines seiner Cloud-Computing-Zentren in Virginia zu decken, wenn Wind- und Sonnenenergie nicht verfügbar sind.

Amazon plant die Umstellung auf Biokraftstoffe in seinen europäischen Zentren. Zunächst in 🇮🇪 Irland und 🇸🇪 Schweden.

All dies hat Elon Musk dazu bewegt, wann immer er öffentlich auftritt oder ein Interview gibt zu sagen, dass wir bis 2027 zu wenig Elektrizität haben werden, um all diese Server-Farmen betreiben zu können.

Die meisten Technologieunternehmen, die Rechenzentren betreiben, geben nicht an, wie viel Prozent ihres Energieverbrauchs auf KI entfallen. Die Ausnahme ist Google (Januar 2024), das sagt, dass „maschinelles Lernen“ – die Grundlage für menschenähnliche AI:

- etwas weniger als 15 % des Energieverbrauchs der Google Rechenzentren ausmacht.

Ein weitere Fakt vom UN World Water Development Report 2024:

- 10 – 15 % der weltweiten Wasserentnahme werden zur Energieerzeugung benötigt

Kühlung Data-Centers: Verbrauch von Süsswasser steigt rasant

Wie oben erwähnt, braucht das rasante Wachstum von AI grosse Data Centers mit Server-Farmen die viel Strom brauchen.

Dabei wird viel Wärme erzeugt. Dies wiederum macht die Kühlung notwendig, welche mit Süsswasser gemacht wird.

Microsoft, Google und Meta haben ihren Wasserverbrauch in den letzten Jahren erhöht, da Millionen von Nutzern von ihren Online-Diensten abhängig sind wie z.B. bei der Nutzung von Microsoft 365 oder Gmail.

Wissenschaftler gehen davon aus, dass die KI-Nachfrage die Wasserentnahme – d. h. die Entnahme von Wasser aus dem Boden oder aus Oberflächenquellen – bis:

- 2027 auf 4,2 bis 6,6 Mrd. Kubikmeter ansteigen lassen würde.

Dies entspricht etwa:

- 50 % des jährlichen Verbrauchs von Süsswasser im Vereinigten Königreich (UK).

Forscher schrieben in einem Artikel, dass dies ein kritischer Zeitpunkt sei, um den geheimen Wasser-Fussabdruck von KI-Modellen anzugehen. Speziell auch deshalb, weil die Knappheit von Süsswasser in bestimmten Regionen Krisen wie Hunger und Dürre ausgelöst hätten.

Im Jahr 2022, dem letzten Zeitraum, für den Zahlen vorliegen, stieg der Wasserverbrauch wie folgt:

- 34 % bei Microsoft,

- 22 % bei Google und

- 3 % bei Meta

Dies ist auf die zunehmende Nutzung von Rechenzentren zurückzuführen.

Wieviel Süsswasser braucht eine Frage-Antwort-Runde mit GPT-3? Bei ca. 10 bis 50 Antworten verursacht dies den Verbrauch von:

- ½ Liter oder 500 ml Frisch- oder Süsswasser.

Auch das Training von AI Beispielsweise verbraucht viel Süsswasser.

Ein 2 Wochen dauerndes Training vom AI-Programm GPT-3 in Microsofts hochmodernen Rechenzentren in den USA benötigt ca:

Die Herstellung von Autos erfordert eine Reihe von Waschvorgängen, um Lackpartikel und -rückstände zu entfernen, sowie weitere Wasseranwendungen.

Die obige Wassermenge für das 2 Wochen dauernde GPT-3 Training entspricht in etwa der benötigten Wassermenge zur Herstellung von:

- 370 BMWs oder

- 320 Tesla-Elektrofahrzeugen

Interessant ist, dass diese Schulung in den USA weniger Süsswasser zur Kühlung benötigt, als wenn dies Microsoft in Asien machen wurde.

- Rechenzentren in Asien sind in deren Wasserbrauch viel weniger effizient als diejenigen in den USA oder Europa!

Einen Monat bevor OpenAI die Ausbildung seines fortschrittlichsten Modells, GPT-4, beendete, verbrauchte ein Rechenzentrums Cluster in West Des Moines, Iowa,

- 6 % des Wassers des Bezirks, wie aus einer Klage der Anwohner hervorgeht.

Auch meine 10 bis 50 Anfragen mit Antworten von dem beliebten Chatbot ChatGPT von Open AI, der auf dem älteren Modell GPT-3 läuft, entspricht, wie oben erwähnt, ungefähr dem „Trinken“ einer 500-ml-Flasche Wasser.

2024-04-18 AI Nutzung: Wie können wir Energie sparen?

Für das Training eines grossen Sprachmodells wie GPT-3 werden schätzungsweise knapp:

- 1.300 Megawattstunden (MWh) Strom verbraucht; das ist etwa so viel Strom, wie

- 130 US-Haushalte jährlich verbrauchen.

Gemäss der International Energy Agency (IEA) braucht es für das Streaming einer Stunde Netflix etwa:

- 0,8 kWh (0,0008 MWh) Strom, was heisst man müsste

- 1’625’000 Stunden Netflix schauen, um

1.300 Megawattstunden (MWh) an Strom zu verbrauchen, welche für die Ausbildung des GPT-3 benötigt wird.

Zum Vergleich, 1 Jahr hat 8760 Stunden, was bedeutet ein Mensch müsste:

- 185.5 Jahre leben und dabei nichts anderes tun als Netflix schauen, um den Strom über Video Streaming zu verbrauchen, welcher zur Ausbildung von GPT-3 benötigt wird.

Weiter oben haben wir darauf hingewiesen, dass eine Frage-Antwort-Runde mit GPT-3 bei 10 bis 50 Antworten rund:

- ½ Liter oder 500 ml Frisch- oder Süsswasser verbraucht um die notwendigen Servers in den Rechenzentren zu kühlen.

Der wachsende Bedarf nach AI wie z.B. ChatGPT hat Folgen. Die Frage ist also, was kann jeder von uns tun, um den schnell wachsenden Bedarf nach Elektrizität und Süsswasser zumindest zu verlangsamen.

2024-04-25 Strom und Süsswasser sparen: So klappt es

10 bis 40 Anfragen die eine Beantwortung auf Chat GPT auch auslösen heisst 1/2 Liter Süsswasser wurde ebenfalls benötigt. Das ist bei der immer grösseren Knappheit von Wasser ein wachsendes Problem.

Beispielsweise, in den Gebieten, die im April 2024 z.B. in Katalonien in Spanien als „Dürre-Notstand“ eingestuft werden – zu denen derzeit auch Barcelona gehört -, dürfen Hotels vorerst nur noch:

- 100 Liter Wasser pro Hotelbett und Tag verbrauchen

Dies ist genauso viel wie die Einwohner der Region täglich verbrauchen dürfen. Zum Vergleich, laut BMUV braucht eine Toilettenspülung 6 – 9 Liter Süsswasser.

DrKPIcheck AI und Cloud Computing: So sparen Sie Strom und Süsswasser

Wir wissen wie jeder von uns Energie und Wasser sparen kann. Das kann mit einem Sparduschkopf oder einer Stromsparlampe geschehen. Wir können auch das fliegen vermeiden und wenn möglich kein Privatauto nutzen um unseren Carbon Footprint zu verringern.

Doch tun wir dies alles? Wohl kaum.

Noch weniger haben wir uns vielleicht überlegt, wie wir unseren Strom- und Süsswasserbedarf durch unsere Cloud Computing und AI Bedürfnisse reduzieren können.

Es gilt, dass wir privat und beruflich einfach dort Wasser und Strom sparen, wo es uns gar nicht schwer fällt dies zu tun. Hier kommt der DrKPIcheck AI, Cloud Computing – So sparen Sie Wasser und Strom, nämlich:

- Geräte länger nutzen: Das Handy kann z.B. 8+ Monate länger genutzt werden. Das neue Smartphone soll zu den besten Performern in seiner Kategorie gehören. Beispiel Klasse AAA was den Energieverbrauch betrifft.

- AI Nutzung optimieren: Wenn immer möglich Suchmaschine nutzen und nicht ChatGPT. Natürlich, Sie wussten es, die Nutzung eines AI Chatbot braucht 2 x soviel Energie wie eine Google Suchanfrage (siehe Studie) und mindestens 1/2 mehr Süsswasser, das anderswo besser gebraucht werden kann (z.B. Spanien – Wassernot in Barcelona).

- Software lokal nutzen, Cloud vermeiden: Wenn immer möglich, die Software lokal auf einem PC oder iPad laufen lassen (siehe z.B. Schleswig-Holstein Open Source). Immer Online zu sein, wie beim Microsoft Cockpit oder 365, frisst Energie und stellt neue Herausforderungen in Sachen Cybersecurity.

- Daten lokal speichern: Daten immer im Netz holen zu müssen (d.h. online zu sein), kostet Strom. Die Server-Farmen müssen ja auch gekühlt werden. Für einen Betrieb mit weniger als 10 Vollzeit Mitarbeitern (über 80 % aller Unternehmen) ist die lokale Datenspeicherung einfach und finanziell sehr attraktiv.

- Keine Geräte im Stand-bye: Wenn Daten lokal gespeichert sind oder Software auf dem lokalen Gerät genutzt wird, kann dieses bei Nichtbenutzung ausgeschaltet werden. Das sollte ausserhalb der Bürozeiten geschehen. Auch der Internet Router zu Hause oder der Fernseher sollten über Nacht oder während längerer Abwesenheit wie Ferien ausgeschaltet sein. Bei mehreren Geräten können im Haushalt jährlich Stromersparnisse von bis gut 100 Euro realisiert werden.

Haben Sie einen Vorschlag, bitte hinterlassen Sie unten einen Kommentar, wir würden uns freuen.

Wissen und Trends: Mit DrKPI® CyTRAP Labs zusammen arbeiten

Sie brauchen einen starken Partner an Ihrer Seite beim professionellen, effizienten und erfolgreichen Aufbau oder Umsetzung Ihrer Digital Marketing Strategie, Usability Design und Testing, Vulnerability Disclosure Programm (VDP) und DSGVO-Compliance?

Unsere Strategie ist: Minimale Belastung von Ressourcen, effektive und optimierte Prozesse sowie gesicherte Compliance für Sie.

Unsere Tools wie DrKPI® PageTracker, KPI AuditLight… sind dabei mögliche Paten für innovative Lösungen.

Weiterführendes Material

de Vries, Alex (2023-10-10). The growing energy footprint of artificial intelligence. Joule. Aufgerufen am 15 April 2024 , https://doi.org/10.1016/j.joule.2023.09.004

HAI (2024-04).The AI index report. Measuring trends in AI. Artificial intelligence index report 2024. Stanford, CA: HAI Stanford University. Retrieved 15. April, 2024 from https://aiindex.stanford.edu/report/

Hoover, Amanda (2024-04-10). Students are likely writing millions of papers with AI. Wired. Aufgerufen am 13. April, 2024 auf https://www.wired.com/story/student-papers-generative-ai-turnitin/

Luccioni, Alexandra Sasha, Kernite, Yacine und Strubell, Emma (2023-11). Power hungry processing: Watts sriving the cost of AI deployment? Arxiv. Aufgerufen am 12. April 2024 auf https://arxiv.org/pdf/2311.16863.pdf

Mythen, David (2021-11). Data centre water consumption. npj Clean Water, 4. Aufgerufen am 15 April, 2024 auf https://www.nature.com/articles/s41545-021-00101-w

Vincent, James (2024-02-16). How much electricity does AI consume? The Verge. Aufgerufen am 15.April 2024 auf https://www.theverge.com/24066646/ai-electricity-energy-watts-generative-consumption

Fazit AI und Klimawandel: Trends vs. Strombedarf und Süsswasserverbrauch

Vor einem Jahrzehnt hatte AI mit Aufgaben wie Bildklassifizierung, Sprachverständnis und visuellem Denken zu kämpfen. Doch heute übertreffen AI-Systeme routinemässig die menschliche Leistung bei Standardbenchmarks.

GPT ist eine teure Methode, um Funktionen des maschinellen Lernens (ML) zu erstellen, ohne ein ML-Team von Ingeneurinnen beschäftigen zu müssen (siehe auch Ken Katzer). Diese wären für viele KMU zu teuer.

GPT kann mehr als Funktionen des ML zu erstellen. Aber das ist es, was es heute hauptsächlich tut UND es kann dem Unternehmen dabei helfen eine Menge Geld zu sparen.

Wir sollten neben vielen anderen Herausforderungen wie Ethik, Regulierung, usw. Stromverbrauch auch AI und Klimawandel genauer betrachten. Strombedarf und rasant steigender Süsswasserverbrauch ween Server-Farmen und Cloud Computing sind Herausforderungen die wir meistern müssen.

4 Antworten

DrKPI

Die Definitionen zwischen Generative AI und „klassischer AI“ finde ich spannend.

Mich nimmt auch Wunder was dies bedeutet in Sachen Energie, verbraucht Generative AI mehr Energie und Wasser zur Kühlung?

Mathilda

Diese Frage ist sehr schwierig zu beantworten. Aber du findest weiter unten im Beitrag ab 2024-04-20 eine Antwort zu diesem wichtigen Thema.

AI braucht enorme Rechenkapazitäten. Dies heizt wiederum den Stromverbrauch an und natürlich die Masse von Süsswasser die benötigt wird um das ganze zu kühlen.

Ein Alptraum wenn wir an den CO2 Ausstoss aber auch die weltweite Erwärmung der Meere denken.

➡️ To cool data centers efficiently, water is used, a lot of water.

Urs

DrKPI CyTRAP

Sieht gar nicht gut aus… Marktdominanz von AWS, Google und Microsoft. Das sind keine guten Aussichten auf die Preise für KMU welche solche Services nutzen für das Hosting von Websites und Daten.

Ja stimmt.

Die Preise sind ja auch ganz schon in die höhe geschnellt dieses Jahr gut 26% oder sogar mehr bei vielen Anbietern.

Da ja auch das Wechseln von einem Anbieter auf den nächsten sehr aufwendig ist, hat man wenig Möglichkeiten z.B. die Kosten zu senken oder den Service zu verbessern indem man den Anbieter wechselt.

Freundlichst

Urs

DrKPI CyTRAP