Vor Kurzem war ich wieder mit der Deutschen Bahn unterwegs – und wie so oft lief nicht alles rund: Signalstörung, Stromausfall, Hitze, Ersatzbus (siehe Bild oben).

Die Bahn investiert Milliarden in Infrastruktur – und in KI. Ein Beispiel: der DB Smile, der nicht nur Reisenden hilft, sondern auch im Recruiting eingesetzt wird. Doch wie nutzerfreundlich ist so ein System im Alltag?

Wir vergleichen DB Smile, den Hertz-Schadenschatbot, Air Canada und die SBB – und zeigen, worauf es bei guter Chatbot Usability wirklich ankommt. Und was dabei allzu oft schiefläuft.

Dieser Beitrag ist Teil 2 einer Serie, welche sich mit dem Einsatz von KI in Unternehmen beschäftigt.

- 1. KI in der Unternehmenskommunikation: Produktiver oder nur schneller?

Faktencheck zur Effizienz und Wirkung generativer Tools im Corporate-Bereich? - 2. Der Bahn-Bot und wir: Was Chatbot Usability über KI im Kundenkontakt verraten

Eine Analyse zwischen Theorie und Alltagsfrust – sie sind hier - 3. KI und Produktivität: Was Studient wirklich zeigen

Zwischen Hype, Hoffnung und messbaren Ergebnissen - 4. etc.

Chatbot Usability: LLMs in der Praxis

In den folgen Sektionen beschreiben wir warum die Arbeit mit Chatbots welche auf einem Large Language Model basiert eine Herausforderung s ein kann.

Danach präsentieren wir eine Checkliste für den Bau eines Chatbots.

Zum Schluss präsentieren wir 2 Beispiele: eines von der Autovermietung Hertz und eines zur Chatbot Usability bei der Deutschen Bahn.

Link zu diesem Beitrag https://drkpi.com/de/?p=37979/

Chatbot Usability: Herausforderungen beim Einsatz von LLMs

Large Language Models (LLMs) erarbeiten grosse Datenmengen. Sie erzeugen Text nach statistischer Wahrscheinlichkeit – also nach dem, was oft zusammen vorkommt.

Sie zerlegen Eingaben in Token , erkennen Muster, aber nicht Bedeutung. Sie verstehen nichts. Sie reihen Woerter, wie sie vertraut wirken.

Darum scheitern sie bei präzisen Aufgaben – etwa bei Formeln oder einem Schachbrett.

Ihre Sätze klingen vertraut, weil sie auf menschlichen Texten basieren. Doch sie sagen nichts Neues. Sie erzeugen keine Erkenntnis, nur eine Neuordnung.

Emily Bender (2025),betont: Keine Magie. GPT ist für sie ein „verherrlichter Magic 8 Ball“. Verstehen müssen wir.

Das Training kostet Milliarden – mit hohem Strom– und Wasserverbrauch. Chatbots passen, wo Aufgaben einfach sind und Fehler wenig kosten.

Als Beispiel DrKPI KI Checkliste: DrKPI KI Checkliste: Häufigkeit, Komplexität, Vernetzung der Teilaufgaben und Kosten bei Fehlern der KI

Siehe auch warum Atari 2600 ChatGPT beim Schach schlägt

Die obigen Erklärungen mach klar, dass wir uns einige Dinge Überlegen müssen, bevor wir ein Chatbot Projekt mit Hilfe von einem LLM lancieren.

Als ersten Schritt gilt es die Tabelle unten abzuarbeiten.

Tabelle 1 – Checkliste für Chatbot Projekte

Die DrKPI-Checkliste hilft dabei, vor Projektstart folgende Fragen zu klären:

- Wie häufig ist die Aufgabe?

- Wie komplex oder vernetzt ist sie?

- Was kostet ein Fehler?

| Ziel | Herausforderungen | Risikomanagement |

|---|---|---|

| 1. Wie kann KI den Kundenkontakt verbessern (z. B. höhere Zufrieden | Komplexität und Häufigkeit der Aufgaben. Je komplexer, desto schwieriger. Je häufiger eine Aufgabe vorkommt, desto besser kann ein Chatbot sie übernehmen. | – Vernetzung / Abhängigkeit Chatbot Teilaufgaben – Risiko und Kosten von Fehlern Wenn zu wenige Faktoren in die Bonitätsprüfung eines Schuldners einbezogen werden. |

| 2. Welche Umsatzpotenziale verpassen wir, bei denen KI helfen könnte (z. B. mit Kunden, Produktion oder F&E)? | Wahre Kosten und Einsparungen durch KI. Mögliche neue Einnahmequellen durch den Chatbot. | – Werden Kunden durch KI abgeschreckt?

– Wie lassen sich Bedenken ausräumen? |

| 3. Schlüssel zum Erfolg: Schnell und in kleinen Schritten vorgehen1 | Fokus behalten. Projekt in 2–5 Monaten abschliessen. Je schneller in Beta, desto besser. Danach kontinuierliche und schnelle Verbesserungen. | – Kosten für KI Projekt

– Zeitüberschreitung für erfolgreichen Abschluss2 |

Hinweis: Diese Tabelle wurde inspiriert durch Beiträge von Hans von Siechart und Vin Vashista.

Für Information zu Häufigkeit, Komplexität, Vernetzung der KI Teilaufgaben und Kosten bei Fehlern vgl. DrKPI Checkliste

1Execution Gap

80 % der KI-Projekte scheitern. Viele generative KI-Projekte brauchen 6–18 Monate bis zum Go-Live (siehe AI Governance Gap)2

Fokus auf Einfachheit statt Komplexität

Grosse Unternehmen können mehrere KI-Projekte gleichzeitig umsetzen. KMU sollten sich auf ein realistisches Projekt konzentrieren, das in sechs Monaten live geht (zwei Monate sind besser – und danach schnelle Verbesserungen).

Basierend auf der Tabelle gilt:

Ein Chatbot lohnt sich nur bei einfachen, häufigen Aufgaben.

Idealerweise führt er diese schnell und korrekt von Anfang bis Ende aus – ohne Zwischenstopp.

Wichtig: Chatbots bedeuten auch Shadow Work für Kundinnen. Sie müssen tippen, warten, nachfragen – was oft übersehen wird.

User Experience (UX) ist nicht gleich Interface-Design

Bevor wir auf konkrete Prinzipien der Nutzerfreundlichkeit eingehen, eine wichtige Klarstellung:

- UX (User Experience) ist nicht IX (Interface Experience) oder UI (User Interface.

Die Wahrheit ist.

- Wenn man das Verhalten der Nutzer nicht versteht,

- wenn man ihre Kognition nicht modellieren kann,

- wenn man nicht weiss, was die Besucherin oder Kundin zum Klicken oder Abbrechen bewegt,

dann macht man keine UX.

Dann dekoriert man nur Bildschirme. Das ist Grafikdesign. Sehr wichtig, aber nicht das, was UX eigentlich meint.

„UX“ stands for „user experience.“ It describes the quality of the experience an end user has with a specific product, service such as a KI, company or brand such as customer service provided with a KI chatbot.

Usability is a quality attribute of the UI (User Interface), covering whether the system is easy to learn, efficient to use, pleasant, and so forth.

Nach der Tabelle 1 – Checkliste für Chatbot Projekte oben und dieser Klarstellung was User Experience vs. Usability ist, werfen wir nun einen Blick auf Prinzipien der Nutzerfreundlichkeit.

Usability Heuristics beim Bauen von Chatbots

Hier schauen wir auf zentrale Prinzipien der Nutzerfreundlichkeit. 1994 veröffentlichgte Jakob Nielsen seine 10 Usability Heuristics. Bis heute anerkannte Leitlinien für gutes Design. Sie sind keine festen Regeln, sondern praxisnahe Faustregeln.

Sara Kingheartt hat diese Heuristiken auf KI-Systeme wie Chatbots übertragen. Hier einige Schlüsselpunkte, angepasst an den KI-Kontext:

- Sichtbarkeit des Systemstatus

KI arbeitet oft im Hintergrund. Nutzer brauchen ein klares, verständliches Feedback in Echtzeit. - Nutzer sollten KI-Entscheidungen stoppen oder korrigieren können.

Manuelle Eingriffe müssen möglich sein. - Fehler vermeiden

Systeme sollten vor kritischen Aktionen nachfragen: „Meinten Sie …?“

Guardrails gegen unethische oder verzerrte Ausgaben sind essenziell. Natürlich müssen die Outputs des Chatbots mit echten Nutzergruppen getestet werden. - Fehler erkennen und beheben

Wenn die KI etwas nicht versteht, sollte sie das offen kommunizieren. Also nachvollziehbar und offen oder im freundlichen Dialog. - Hilfe und Dokumentation

Gute Systeme erklären, was sie tun und warum. Das schafft Vertrauen und fördert den Umgang mit dem System.

Chatbot Usability bei Hertz: Herausforderungen im Schadensmanagement

Wie wichtig diese Prinzipien sind, zeigt ein negatives Beispiel. Wir nahmen dazu das von KI ausgeführte Schadenmanagement von Hertz, zu denen auch Dollar und Thrifty gehören. Das System ist seit April 2025 an immer mehr US-Flughäfen im Einsatz.

Hertz arbeitet bei dieser Technologie mit UVeye zusammen und wird (siehe Video unten) als “Drive Through Inspection Check” bezeichnet. UVeye hat sich ganz auf den Einsatz von KI zur Automatisierung von Fahrzeuginspektionen konzentriert.

Das System erkennt Dellen und Kratzer automatisch. Dabei sind die Schäden oft sehr klein, aber mit hohen Kosten verbunden (z. B. 440 USD für 2.4 cm Kratzer von einem Bordsteinschaden an einem Rad).

Dass sich Hertz so vor Schäden schützen möchte, ist verständlich. Doch wenn ich den Schadensbericht via E-Mail erhalte und beim Chatbot Erklärungen haben möchte, fangen meine Kopfschmerzen schon an.

Beispiel par excellence ist die Situation, dass auch wenn ich mit dem Chatbot nicht weiter komme, die Kundin keine Hilfe von einem Mitarbeiter bekommen kann. Warum? Weil die Programmierung vom Chatbot keinen menschlichen Eingriff durch eine Mitarbeiterin im Live-Chat ermöglicht.

Zwar kann ein Fall zur späteren Prüfung markiert werden. Doch dies lässt der Chatbot den Kunden nicht wissen.

Der Chatbot informiert auch nicht über Alternativen wie einen Anruf bei der Hotline. Wer das Kontaktformular nutzt, wartet oft bis zu 10 Tage auf eine Antwort. Doch leider gilt der Rabatt für prompte Zahlung des gefundenen Schadens nur 7 Tage.

Dieses Beispiel zeigt, was passieren kann, wenn Usability-Heuristiken ignoriert werden. Hätte man Punkt 3 – Fehlervermeidung – ernst genommen und das System mit echten Nutzergruppen getestet, wären solche Probleme wohl aufgefallen.

Auch laufende Verbesserungen, ein wichtiger Grundsatz um effektive KI Chatbots bauen zu können, sind nach dem Start im April 2025 nicht ersichtlich (siehe Tabelle 1 oben, Punkt 3).

Das passiert, wenn der KI-Scanner von Hertz einen Schaden an Ihrem Mietwagen findet

Das Beispiel zeigt, weder Hertz als Kunde, noch UVeye als Lieferant, haben hier gute UX Arbeit geleistet.

Die Automatisierung von Fahrzeuginspektionen soll bis Jahresende in 100 der grössten Mietstationen von 1600 an Flughäfen in den USA genutzt werden.

Im Gegensatz dazu nun ein Beispiel, wie es besser geht – die Bahn mit ihrem Chatbot.

Chatbot Usability – was meinen Sie? 🤔

Teilen Sie Ihre Erfahrungen gern unten in den Kommentaren!

Chatbot Usability im Realitätscheck: Deutsche Bahn

Die Deutsche Bahn setzt auf KI, um Standardanfragen automatisiert zu beantworten und eine gute Chatbot Usability zu bieten. Doch wie gut klappt das im Alltag mit Chatbot DB Smile

Chatbot DB Smile:

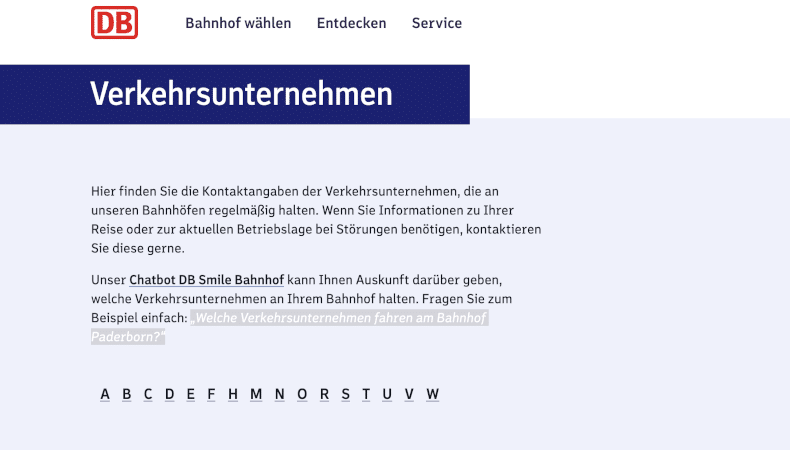

Die Deutsche Bahn nutzt den Chatbot DB Smile, um Kundenanfragen mit KI zu beantworten. Ein Beispiel zeigt, wie man den Bot richtig fragt: „Welche Verkehrsunternehmen fahren am Bahnhof Paderborn?“

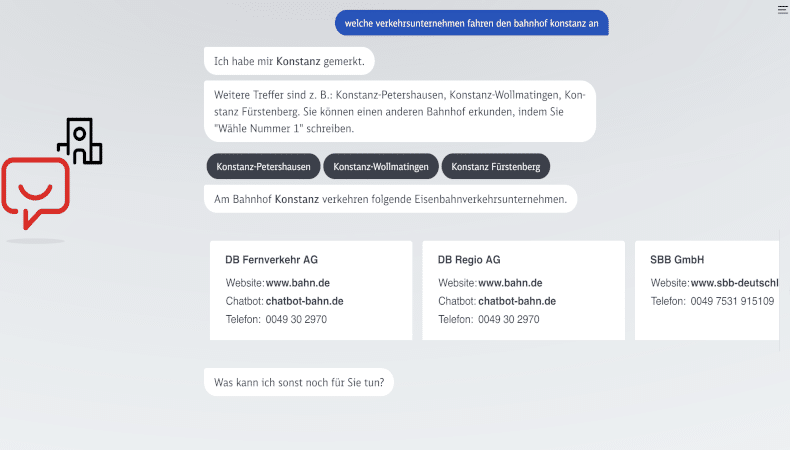

Ein Beispiel: Wir wollten wissen, welche Verkehrsunternehmen einen bestimmten Bahnhof anfahren. Der Chatbot erklärt zunächst, wie man korrekt fragt – das ist gut gemeint, aber wenig intuitiv. Die Antwort selbst? Unvollständig.

Die Busbetriebe der Stadt Konstanz fehlen – obwohl sie natürlich dazugehören (siehe auch weiter unten – Screenshot mit der Antwort).

Mitarbeiterin eilt zu Hilfe:

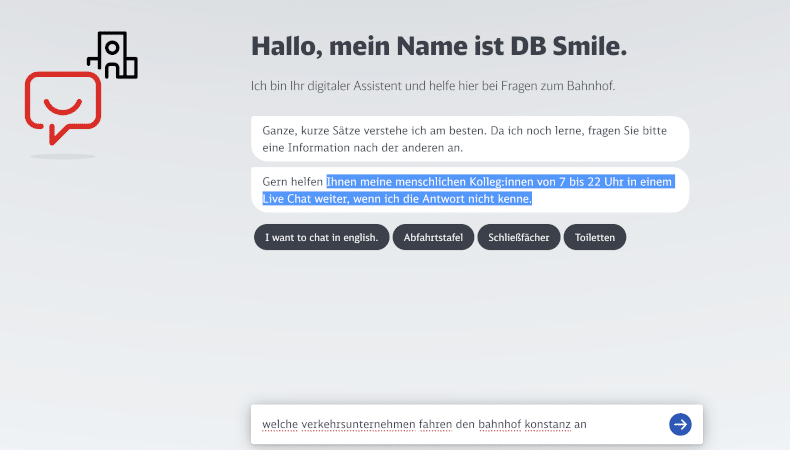

Beim Chatbot DB Smile erfährt man, dass bei unklaren Antworten von 7 bis 22 Uhr ein menschlicher Mitarbeiter weiterhilft.

Wenn man den Bot erreichen will landet man auf dieser Seite.

Positiv: Wenn der Bot nicht weiterweiß, kann zwischen 7:00 und 22:00 Uhr ein Mensch übernehmen – ein klarer Pluspunkt in Sachen Usability-Heuristik (siehe Punkte 2 & 3: Nutzerkontrolle und Fehlerbehandlung).

Das ist nach Usability Heuristics oben Punkte 2 und 3 z.B. korrekt oder eine pragmatische Lösung.

Der DB-Chatbot Smile beantwortet Kundenanfragen mit KI:

Seine Antwort zeigt zwei Schwächen was Chatbot Usability betrifft: Er nennt nicht zuerst die Bahn mit den meisten Verbindungen und erwähnt den Busbetrieb der Stadt Konstanz nicht, obwohl auch dieser zum Verkehrsnetz gehört.

Chatbot DB Smile generiert eine Antwort (siehe Screenshot oben). Doche diese ist für mich nicht zufriedenstellend. Beispieslweise die Busbetriebe der Stadt Konstanz werden nicht aufgelistet. Wer würde behaupten, dass dies keine Verkehrsbetriebe sind?

Und wir haben nicht nach Bahnunternehmen gefragt.

Ein Beispiel wieso sich der Chatbot vielleicht nicht einer grösseren Nutzung erfreuen kann? Bessere Chatbot Usability…

Chatbot DB Smile:

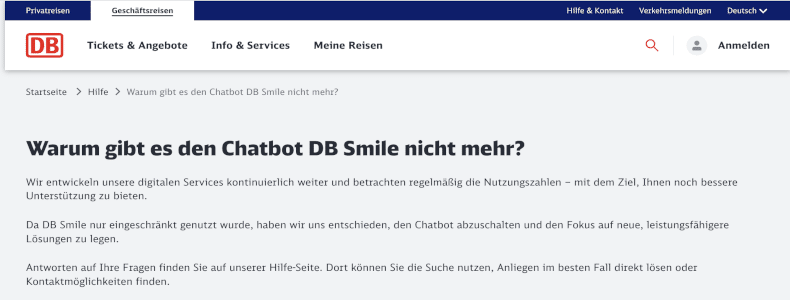

Warum ist der Chatbot auf manchen Bahn-Seiten verschwunden? Verwirrung durch inkonsistente Verfügbarkeit – was läuft bei der Deutschen Bahn schief?

Weniger erfreulich: Auf einigen Bahnseiten steht inzwischen, dass der Chatbot nicht mehr verfügbar ist (siehe Image oben).

Eine offizielle Begründung fehlt. Es heißt lediglich, er sei zu wenig genutzt worden. Dies wirft jedoch Fragen auf:

- Lag es an der komplizierten Bedienung?

- Oder waren die Antworten zu unklar?

Beides würde auf mangelnde Usability hinweisen – und darauf, dass der Chatbot am Bedarf der Nutzer vorbeigeht.

Inspiration, Trends und Tipps erhalten sie mit dem Newsletter, hier abonnieren

Sie haben Fragen zur Chatbot Usability oder KI Produktivität? Melden Sie sich!

Fazit: KI braucht mehr als Technik

Die Beispiele von Hertz und der Deutschen Bahn zeigen:

- Chatbots können den Kundenkontakt verbessern – aber nur, wenn Usability und Nutzerbedürfnisse ernst genommen werden.

- Technologie allein genügt nicht. Es braucht klare Ziele, getestete Dialogführung und echte Nutzerkontrolle.

Heuristiken wie Sichtbarkeit, Fehlertoleranz und Benutzerkontrolle sind keine Kür, sondern Voraussetzung. Werden sie ignoriert, entsteht Frust statt Hilfe – und Vertrauen geht verloren.

Wer KI erfolgreich einsetzen will, braucht:

- einfache, häufige Anwendungsfälle

- Fehlertoleranz und Ausweichpfade

- laufendes Feedback und Optimierung

Nur dann wird aus einem Bot ein echter Helfer – und nicht ein weiteres Tool, das Nutzer allein lässt.

Chatbot Usability Fail: DB Smile, Hertz Schadenschatbot, Air Canada und SBB

In all diesen Fällen – ob DB Smile oder der Hertz-Schadenschatbot – wurde offenbar vergessen, wie Menschen Produkte oder Services im Alltag tatsächlich nutzen. Das kann stark von den Vorstellungen der Entwickler im Labor abweichen.

Zu sagen, ein System werde «zu wenig genutzt» und es deshalb einfach von der Website zu entfernen (wie bei der Deutschen Bahn), greift zu kurz. Das Problem ist nicht, dass Nutzer «nicht prompten können», sondern dass die Systeme in ihrer realen Anwendung scheitern.

Technologieanbieter und ihre Kunden sollten deutlich mehr Praxistests mit echten Nutzergruppen durchführen, um sicherzustellen, dass solche Systeme unter realen Bedingungen auch tatsächlich sinnvoll nutzbar sind.

Leistungsfähige Technologien zu entwickeln ist das eine – sie effektiv und nutzerfreundlich einzusetzen eine ganz andere Herausforderung.

Das zeigt auch ein weiteres Beispiel: Air Canada wurde gerichtlich zu Schadenersatz verurteilt, weil ihr Chatbot einem Kunden falsche Auskünfte gegeben hatte. Das Argument der Airline, der Chatbot sei ein «separates System» und nicht ihre Verantwortung, wurde klar zurückgewiesen.

Chatbot Usability Fail: SBB ist für Kunden eine Zumutung

Trotz solcher Präzedenzfälle lehnt die SBB in ihrer eigenen Haftungserklärung jede Verantwortung für falsche oder unvollständige Antworten ihres Chatbots ab (siehe Bild unten). Statt echter Hilfe verweist man auf alternative Kontaktwege – entweder kostenpflichtig (Telefon CHF 0.08/Min.) oder nur mit Beratung im Reisezentrum buchbar. Alles ziemlich umständlich. Warum geht das nicht einfach per E-Mail?

PS: Der Chatbot funktioniert nur, wenn man Cookies akzeptiert – was aus Cybersecurity-Perspektive nicht gerade empfehlenswert ist.

Schweizerische Bundesbahnen:

Die SBB lehnt jede Verantwortung für ihren Chatbot ab (siehe Image oben, highlighted). Wer verlässliche Hilfe will, muss kostenpflichtig anrufen oder sich im Reisezentrum beraten lassen.

Auch hier stellt sich die Frage: Ist das noch zeitgemäss?

Wer Chatbots im Kundendialog einsetzt, muss Verantwortung übernehmen – und auch dafür sorgen, dass diese Systeme in der Praxis wirklich funktionieren.

Auch von der SBB kann und muss man hier mehr erwarten.

Wir haben den SBB-Chatbot diese Woche einem Usability-Check unterzogen.

Das vollständige Protokoll mit Screenshots und Verlauf gibt es unten als PDF zum Download:

Chat mit SBB – SBB Chatbot Usability im Test ➡️ Nervend, langsam, kompliziert – lese mehr in unserer Analyse (hier runterladen)

✅ Kurzfassung für alle, die nicht downloaden wollen:

Unser Test zeigt: Der SBB-Chatbot konnte eine einfache Frage nicht beantworten und leitete erst nach minutenlangem Warten an Menschen weiter.

Insgesamt dauerte der Vorgang über 30 Minuten – ein klarer Usability-Flop. Auch die Option, den Chatverlauf einfach per E-Mail zu erhalten, wurde entfernt und musste manuell erfragt werden.

Mehr details und Resultate im Download

Chatbot Usability – was meinen Sie? 🤔

Teilen Sie Ihre Erfahrungen gern unten in den Kommentaren!

📜DrKPI CyTRAP AI-Verantwortlichkeitserklärung

Dieser Beitrag wurde mit KI-Unterstützung erstellt.

Eigene Recherchen, Erfahrungen und Entwürfe bildeten die Grundlage.

KI diente als Schreibassistenz, nicht als Ghostwriter.

Keine Fakten wurden erfunden, keine Quellen konstruiert.

Die Autorin hat alle Inhalte geprüft und verantwortet die Aussagen.

Das ist für uns: ethisch und transparent mit KI arbeiten.

.

📜DrKPI CyTRAP AI Responsibility Statement

This article was created with AI assistance.

Original research, experience, and drafts formed the foundation.

AI served as a writing assistant, not a ghostwriter.

No facts were fabricated, and no sources were invented.

The author reviewed all content and is responsible for the statements.

For us, this means working ethically and transparently with AI.

5 Antworten

Der Fahrer sagte, er habe die Rechnung „Minuten“ nach der Rückgabe des Wagens erhalten, mit einer Aufschlüsselung, die

– 250 Dollar für die Reparatur,

– 125 Dollar für ‚Bearbeitung‘ und

– 65 Dollar für „Verwaltung“ enthielt.

Also Kunde findet man, dass es sich nicht lohnt, die Verantwortung für etwas zu übernehmen, das man nicht getan hat.

ABER noch schlimmer ist für den Kunden bei Hertz: Es ist eine überwachte Mautstelle ohne menschlichen Fluchtweg, d.h. wie oben erwähnt man kann sich beim Chatbot beschwehren aber ein Hertz Mitarbeiter kann dem Chat nicht beitreten!

ANTWORT 1

Genau liebe Lorea

Ja das Schlimme ist, dass man nicht von einem Mitarbeiter Hilfe bekommen kann und wenn man sich beschwehrt, wird es echt kompliziert.

Die Entscheidung von Hertz, Kundenstrafen statt Unterstützung zu priorisieren, hat weitreichende Konsequenzen. Diese gehen über emotionale Verärgerung hinaus und betreffen auch die finanziellen Aspekte des Unternehmens.

Finanziell gesehen, führt bereits eine Abwanderung von 1 bis 2 % des jährlichen Kundenstamms zu erheblichen Verlusten. Bei etwa 50 Millionen Mietern pro Jahr bedeutet dies:

🔢 500.000 bis 1 Million verlorene Kunden jährlich

💸 100 bis 200 Millionen Dollar entgangene Einnahmen, basierend auf einem Gewinn von 200 Dollar pro Anmietung

ANTWORT 2

Doch die finanziellen Auswirkungen beschränken sich nicht nur auf direkte Einnahmeverluste. Die Abwertung der Marke durch negative Publicity kann das Umsatzmultiple des Unternehmens verringern. Ein viraler Skandal kann zu einem Verlust von:

💸 200 bis 300 Millionen Dollar an Marktkapitalisierung führen, da das Vertrauen in die Marke schwindet.

Insgesamt könnte diese Strategie Hertz:

📉💼 300 bis 500 Millionen Dollar kosten.

Es stellt sich die Frage, ob die kurzfristige Effizienzsteigerung durch Kundenstrafen die langfristigen finanziellen und reputativen Schäden wert ist.

🔄🤝 Eine Neubewertung der Kundenbeziehungsstrategie scheint unumgänglich, um nachhaltigen Erfolg zu sichern.

Das ist ja sehr interessant, Urs

Habe gerade geguckt auch mit der SBB App.

Wirklich unverschämt, ich werde praktisch genötigt den Chatbot zu nutzen und dann will die Firma nicht einmal die Verantwortung übernehmen wenn dieser mir falsche Infos gibt.

Das kann nicht rechtens sein.

Liebe Phillis

entschuldige bitte, dass meine Antwort so lange auf sich warten liess.

Ja, die SBB lehnt jede Verantwortung für die Aussagen ihres Chatbots ab. Ob das vor Gericht Bestand hätte, ist allerdings fraglich. Ein Beispiel dafür ist der Air Canada Fall: Dort argumentierte der Richter, das Unternehmen könne nicht einerseits die Hilfe eines Chatbots anbieten und andererseits jede Haftung für falsche Auskünfte ablehnen.

Ich bin gespannt, wie sich das in der Schweiz und der EU weiterentwickelt.

Herzliche Grüsse

Urs