Happy New Year! 2026 wird ein entscheidendes Jahr für Firmen, die KI Risiken 2026 aktiv managen wollen. Die grossen Anbieter erweitern ihre Angebote kontinuierlich. Unterschiede zwischen US-Anbietern wie ChatGPT und europäischen Alternativen wie Mistral Le Chat wirken sich direkt auf KI Risiken 2026 aus.

Viele Teams testen diese KI-Tools bereits im Alltag. Datenschutz und Kosten setzen klare Grenzen. Entscheider fragen sich: Welches System minimiert KI Risiken 2026 und erfüllt gleichzeitig die Compliance-Vorgaben, insbesondere unter Berücksichtigung des CLOUD Act und DSGVO?

Vergleich ChatGPT & Mistral Le Chat: Basisfunktionen und Business

Nachfolgend zeigen Tabellen die wichtigsten Unterschiede. Sie helfen Firmen, Behörden und Konzerne bei technischen, organisatorischen und strategischen Entscheidungen.

Tabelle 1 – ChatGPT: Free, Plus und Business

| Merkmal | Free | Plus | Business |

|---|---|---|---|

| Modell-Version | GPT-4.1 mini | GPT-4.1 / GPT-4o | GPT-4.1 / GPT-4o Business Tier |

| Geschwindigkeit | Standard | Schneller | High-Performance + SLA |

| Zugriff Spitzenzeiten | Begrenzt | Priorität | Priorität + dedizierte Ressourcen |

| Kosten | Gratis | Monatliches Abo | Individuelles Angebot |

| DSGVO / Datenschutz | USA-Hosting, Opt-out möglich | Wie Free | EU-Hosting optional Business DSGVO Anfrage |

| Einsatz sensible Daten | Nicht empfohlen | Nicht empfohlen | Mit SLA & isolierter Instanz |

Tabelle 1 zeigt was die DSGVO betrifft, die Nutzung von ChatGPT wir bei Nutzung von sensiblen Daten nicht empfohlen. Firmen, die sensible Informationen nutzen, müssen besonders auf Compliance achten.

Tabelle 2 – Mistral Le Chat: Free, Pro und Business

| Merkmal | Mistral Free | Mistral Pro | Mistral Business / Enterprise |

|---|---|---|---|

| Modell-Version | Mistral Small | Mistral Large / Codestral / Mixtral 8x22B | Dedizierte Modelle + Hosted Inference |

| Geschwindigkeit | Standard | Schneller + Priorität | Hohe Performance + SLA |

| Zugriff während Spitzenzeiten | Begrenzt | Priorisiert | Garantiert (SLA) |

| Kosten | Gratis | Abonnement / Token-Nutzung | Individuell nach Projektumfang |

| DSGVO / Datenschutz | Daten auf Mistral Servern (EU), Training opt-out möglich | EU-Hosting, keine Nutzung der Kundendaten für Trainingszwecke | Vollständig DSGVO-konform, EU-Rechenzentren (Paris), dedizierte Instanzen möglich Business & DSGVO anfragen |

| Einsatz sensible Daten | Nicht empfohlen | Mit Vorsicht | Geeignet bei SLA, Audit-Logs und abgeschotteter Umgebung |

Tabelle 2 macht klar, dass Daten in Europa gehostet werden. Dies ist wegen des Cloud Acts der USA sicherlich zu empfehlen.

Doch auch hier gilt für Firmen, Nutzung von sensiblen Daten macht eine spezielle Vereinbarung mit dem Mistral notwendig.

Tabelle 3 – ChatGPT: Business Funktionen

| Funktion | Business |

|---|---|

| API-Kosten | Volumenpreise, GPT-4o Business Tarif |

| SLA | 99,9% |

| Datenhaltung | EU-Hosting optional |

Unten folgen die Angaben für Mistral Le Chat. Diese unterscheiden sich nicht sehr stark von ChatGPT in Tabelle 3 oben.

Tabelle 4 – Mistral Le Chat: Business Funktionen

| Funktion | Business |

|---|---|

| API-Kosten | Volumenpreise, EU-Cluster |

| SLA | 99,9% |

| Datenhaltung | EU-Hosting + private Cluster |

Oben wurden in den Tabellen 3 und 4 kurz die Businessfunktionen aufgelistet.

In Tabelle 5 geht es primär um die Kostenfunktionen.

Tabelle 5 – Abo-Preise Vergleich: ChatGPT (hellblau) vs. Mistral Le Chat (rötlich)

| Anbieter / Plan | Preis (USD / Monat) | Ca. Preis (€ / Monat) | Hinweis & Quelle |

|---|---|---|---|

| ChatGPT Plus | 20 USD | ≈ 23,80 € | Monatliches Abo. Quelle: OpenAI Pricing (openai.com) |

| ChatGPT Business / Team | ~25 USD / Nutzer (var.), mindestens 2 Nutzer | ≈ 28–30 € / Nutzer | Teamlizenz; Jahres-/Monatsvarianten möglich. Quelle: openai.com |

| Mistral Le Chat Pro | 14.99 USD | ≈ 15–17 € | USD-Preis; Euro-Preis je nach Wechselkurs / MwSt. Quelle: mistral.ai |

| Mistral Le Chat Business / Team | Individuell / auf Anfrage | — | Private Instanzen, EU-Hosting möglich; Preis hängt von Scope ab. Quelle: mistral.ai |

Preise sind Stand-Anhaltspunkte (USD-Angaben). Euro-Preise sind ungefähre Umrechnungen (Beispielumrechnung ~1 USD = 0.89–0.95 EUR, je nach aktuellem Kurs und regionaler Besteuerung).

Für verbindliche Preise und Verträge bitte die Herstellerseiten prüfen: openai.com (ChatGPT) und mistral.ai (Mistral).

Der „Free“-Plan bei beiden bleibt 0 €/USD pro Monat.

Bei Mistral gibt es teils Rabatte für Studenten (z. B. reduziert auf 6.99 USD bei Pro).

Preise können je nach Währung und Steuern leicht variieren — prüfe im jeweiligen Anbieter-Konto.

Die Preisunterschiede erklären nur einen Teil der Entscheidung. Wichtiger ist, wie sicher die Datenverarbeitung in jedem System bleibt. Genau hier zeigen sich die grössten Risiken, besonders bei sensiblen Informationen.

Deshalb folgt nun ein Blick auf die Risiken grosser KI-Modelle und die wachsende Unsicherheit in der Versicherungsbranche.

Wer diese Fragen 2026 beantwortet, gewinnt Zeit, Wissen und Wettbewerbsvorteile. Wer wartet, riskiert Abhängigkeiten oder ungeplante Kosten. Eine weitere Herausforderung sind die Risiken und wie deren quantifizierten Kosten abgesichert werden können.

Wer zahlt, wenn KI falsch liegt? Risiken & Haftung 2026

Der Fall Wolf River zeigt das Problem deutlich. Die Firma klagt gegen Google, weil die KI angeblich falsche Angaben machte. Interne Korrekturen über Google Werkzeuge halfen nicht, siehe NYT-Beitrag Who Pays When A.I. Is Wrong?.

KI-Risiken lassen sich schwer messen. Versicherer betrachten grosse Sprachmodelle oft als Black Boxes und schliessen Risiken teilweise komplett aus.

Was sich Versicherungsgesellschaften nicht leisten können, ist, wenn ein KI-Anbieter einen Fehler macht, der zu 1.000 oder 10.000 Schadensfällen in verschiedenen Unternehmen führt. Dies stellt ein systemisches, korreliertes, aggregiertes Risiko dar.

Auch KI-Halluzinationen fallen in der Regel nicht unter den Standard-Cyber-Versicherungsschutz, der bei Sicherheits- oder Datenschutzverletzungen greift.

Und selbst wenn sogenannte Tech-„Fehler- und Auslassungsversicherungen“ eher KI-Fehler abdecken, könnten neue Ausnahmen den Umfang des angebotenen Versicherungsschutzes einschränken.

Unternehmen müssen Haftung klar regeln, Logs führen und Tests strikt von produktiven Daten trennen. Ohne diese Massnahmen drohen Reputationsschäden.

KI, KMU, Strategie und Trends – kompakt erklärt.

Jetzt Newsletter abonnieren und keine Insights mehr verpassen!

KI als autonome Waffe: Anthropic-Fall 2025 & Learnings für 2026

Im November 2025 veröffentlichte das Start-up Anthropic einen Bericht über den ersten bekannten Fall eines fast vollautonomen KI-Spionageangriffs.

Die Gruppe GTG1002, mutmasslich mit chinesischen Stellen verbunden, nutzte Claude Code, einen KI-basierten Codierungsagenten.

- Aufklärung des Ziels

- Schwachstellenanalyse

- Ausnutzung der Lücken

- Erfassung von Anmeldedaten

- Datenanalyse

- Datenexfiltration

80–90 % der Schritte liefen autonom. Menschen griffen nur strategisch ein. Geschwindigkeit und Präzision der KI waren beispiellos.

Auswirkungen und Risiken

- Systemmanipulation: KI verändert Abläufe, statt nur Daten zu stehlen.

- Eskalationsrisiko: Autonome Reaktionen können unkontrollierbare Ketten auslösen.

- Historische Dimension: Angriffe wie Estland 2007 oder OPM Hack 2015 wirken dagegen harmlos.

Fazit: KI-Spionage und Zukunft

Der Anthropic-Fall zeigt, dass KI-Spionage real und effizient ist. Staaten müssen Regeln, Abwehrpläne und Kontrollmechanismen entwickeln.

Die Geschwindigkeit und Präzision autonomer KI-Angriffe erfordert dringend internationale Standards und Sicherheitsstrategien.

Mehr Informationen im Originalbericht: November 2025 Bericht.

Datenvergiftung: Unterschätztes Risiko bei LLMs

Grosse Sprachmodelle sind anfälliger für Datenvergiftung als bisher angenommen. Schon wenige manipulierte Dokumente reichen aus, um Backdoor-Trigger zu implementieren. Deshalb sind gezielte Abwehrstrategien dringend erforderlich.

Forschung des Alan Turing Institute zeigt, dass grosse Sprachmodelle anfälliger für Datenvergiftung sind als bisher angenommen. In Zusammenarbeit mit dem AI Security Institute und Anthropic wurde nachgewiesen, dass bereits rund 250 gezielt platzierte Dokumente ausreichen, um Large Language Model(s) (LLMs) dauerhaft zu manipulieren.

Im Fokus der Untersuchung standen Backdoor-Angriffe, bei denen Trigger-Begriffe verstecktes Fehlverhalten auslösen. Beispiele sind etwa Datenlecks, Leistungsabfall oder das Umgehen von Sicherheitsmechanismen. Bemerkenswert ist, dass der erforderliche Aufwand nicht mit der Modellgrösse skaliert.

Die Studie Poisoning Attacks on LLMs Require a Near-constant Number of Poison Samples unterstreicht den dringenden Bedarf an wirksamen Abwehrstrategien für den sicheren Einsatz zukünftiger KI-Systeme.

KI Risiken 2026: Praxisbeispiele aus der Industrie

Neben theoretischen Bedrohungen zeigen aktuelle Vorfälle, wie KI Risiken 2026 konkret werden. Drei Bereiche sind besonders kritisch:

1. Datenleaks durch Fehlkonfiguration

Eine europäische Bank testete 2025 ChatGPT für Kundensupport. Dabei flossen 12.000 E-Mails mit persönlichen Daten in das Training-Set. Erst nach 3 Monaten fiel der Vorfall auf – DSGVO-Strafe: 4,2 Millionen Euro.

Lesson Learned: Kostenlose KI-Tools standardmässig mit Opt-in zum Training konfiguriert. Unternehmen müssen aktiv Opt-out wählen und dies dokumentieren.

2. Halluzinationen mit rechtlichen Folgen

Ein KMU-Rechtsberater nutzte ChatGPT für Vertragsentwürfe. Die KI erfand drei nicht existierende Gerichtsentscheide als Präzedenzfälle. Der Vertrag wurde angefochten, das KMU verlor 180.000 Euro Schadensersatz.

Lesson Learned: Halluzinationen sind bei allen LLMs möglich. Jede KI-generierte Information braucht menschliche Verifikation – besonders bei rechtlichen, medizinischen oder finanziellen Inhalten.

3. Prompt Injection Angriffe

Ein E-Commerce-Chatbot wurde durch manipulierte Nutzereingaben umprogrammiert. Kunden erhielten 90% Rabattcodes, die eigentlich nicht existierten. Schaden: 250.000 Euro in 48 Stunden.

Lesson Learned: KI-Systeme brauchen Input-Validierung, Rate Limiting und regelmässige Sicherheitsaudits. Ein manipulierter Chatbot kann schnell teuer werden.

FAQ: KI Risiken 2026

Was sind die grössten KI Risiken 2026 für Unternehmen?

Die grössten KI Risiken 2026 sind: 1. Datenleaks durch Fehlkonfiguration – kostenlose Tools standardmässig mit Opt-in zum Training. 2. DSGVO-Verstösse – USA-Hosting vs. EU-Anforderungen, CLOUD Act Problematik. 3. Halluzinationen – KI erfindet falsche Fakten mit rechtlichen Folgen. 4. Versicherungslücken – KI-Fehler oft nicht abgedeckt. 5. Autonome Angriffe – 80-90% der Schritte laufen ohne menschliches Eingreifen. Quelle: Anthropic Spionage-Bericht November 2025 und NYT-Artikel Who Pays When AI Is Wrong.

ChatGPT oder Mistral Le Chat – welches Tool ist DSGVO-konformer?

Mistral Le Chat ist DSGVO-konformer: Daten werden in EU-Rechenzentren (Paris) gehostet, keine Nutzung für Training bei Pro/Business. ChatGPT Business bietet EU-Hosting optional, aber Standard-Hosting liegt in den USA. Der CLOUD Act erlaubt US-Behörden Zugriff auf Daten amerikanischer Unternehmen weltweit. Für sensible Daten empfehlen beide Anbieter Business-Verträge mit SLA, Audit-Logs und dedizierter Instanz.

Wer haftet wenn KI falsche Informationen liefert?

Die Haftungsfrage ist ungeklärt. Der Fall Wolf River vs. Google zeigt: Unternehmen verklagen KI-Anbieter wegen falscher Angaben, aber Rechtslage ist unklar. Versicherer schliessen KI-Risiken oft aus – systemisches Risiko wenn ein Fehler tausende Schadensfälle verursacht. KI-Halluzinationen fallen nicht unter Standard-Cyber-Versicherung. Tech-„Fehler- und Auslassungsversicherungen“ könnten greifen, aber neue Ausnahmen schränken Deckung ein. Unternehmen müssen: Logs führen, Tests von produktiven Daten trennen, Haftung vertraglich regeln. Quelle: NYT Who Pays When AI Is Wrong.

Was kostet ChatGPT Business vs. Mistral Le Chat Pro?

ChatGPT Business: ca. 25 USD/Nutzer/Monat (mind. 2 Nutzer), EU-Hosting optional. Mistral Le Chat Pro: 14.99 USD/Monat, EU-Hosting Standard, keine Trainingsdatennutzung. Mistral Business: Individuell auf Anfrage, dedizierte Instanzen möglich. Beide bieten 99,9% SLA bei Business-Tarifen. Preise sind USD-Basis, Euro-Umrechnung je nach Kurs und MwSt. Für sensible Daten immer Business-Vertrag nötig. Quellen: openai.com/pricing und mistral.ai/pricing.

Wie schütze ich mein Unternehmen vor KI-Angriffen?

Schutzmassnahmen gegen KI-Angriffe: 1. Input-Validierung – Prompt Injection verhindern durch Eingabeprüfung. 2. Rate Limiting – Missbrauch erschweren durch Anfragebeschränkung. 3. Keine sensiblen Daten in Free-Tools – Opt-out für Training aktivieren. 4. Menschliche Verifikation – alle KI-Outputs prüfen vor Einsatz. 5. Separate Test-Umgebungen – produktive Daten isolieren. 6. Sicherheitsaudits – regelmässige Überprüfung der KI-Systeme. 7. Logs führen – Nachvollziehbarkeit für Haftungsfragen. Der Anthropic-Fall zeigt: autonome KI-Angriffe sind real und effizient.

Welche KI-Strategie brauchen KMU 2026?

KMU-KI-Strategie 2026: 1. Risikobewertung – welche Daten dürfen in KI. 2. Tool-Auswahl – EU-Hosting bevorzugen wegen DSGVO und CLOUD Act. 3. Business-Verträge – bei sensiblen Daten kein Free-Plan. 4. Schulung – Mitarbeitende über Halluzinationen und Datenschutz aufklären. 5. Prozesse definieren – wer darf was mit KI machen. 6. Haftung regeln – Versicherung prüfen, Verträge mit Anbietern. 7. Kontinuierliche Anpassung – KI-Risiken entwickeln sich schnell. 99,3% deutscher Unternehmen sind KMU, aber viele Events fokussieren auf Grosskonzern-Budgets – KMU brauchen eigene pragmatische Lösungen.

📌 Ausblick KI Risiken 2026: Qualität, Sicherheit & Arbeit

Wir analysierten ChatGPT und Mistral Le Chat. Kostenlose Modelle bleiben verbreitet, doch Qualität, Verantwortung und Sicherheitsrichtlinien sind entscheidend für Unternehmen.

GenAI-Systeme erzeugen häufig fehlerhafte Informationen. Die Studie des Tow Center for Digital Journalism zeigt, dass acht generative Suchwerkzeuge oft falsche Quellen oder Links liefern.

- ChatGPT Search von OpenAI, Perplexity, DeepSeek Search, Copilot von Microsoft, Grok-2 & 3 Beta von xAI sowie Gemini von Google waren Teil der Studie.

- Premium-Chatbots geben häufiger falsche Antworten als kostenlose Modelle.

- Generative Suchwerkzeuge fälschten Links oder zitierten kopierte Versionen.

Wer tiefer verstehen will, was generative KI wie Google Gemini für Suchmaschinenoptimierung bedeutet, findet mit dem Beitrag Google Gemini AI: SEO wird überflüssig? eine kritische Analyse zur Zukunft von SEO in Zeiten von KI.

Kernproblem: KI erkennt ihre eigenen Wissenslücken nicht (Dunning-Kruger-Effekt für KI).

Praxisnah zeigen wir, wie Sie die KI Risiken identifizieren, überprüfen, sichern und Arbeitsprozesse KI tauglich machen.

Was wir tun müssen

- Keine sensiblen Daten in öffentlichen oder geteilten KI-Tools eingeben.

- Separate, sichere Umgebungen für Entwicklung und Testen nutzen.

- Compliance prüfen: EU AI Act und DSGVO einhalten.

Je leistungsfähiger KI wird, desto stärker wächst unsere Verantwortung, sie transparent und bewusst weiterzuentwickeln.

#DrKPI®

Quick Wins

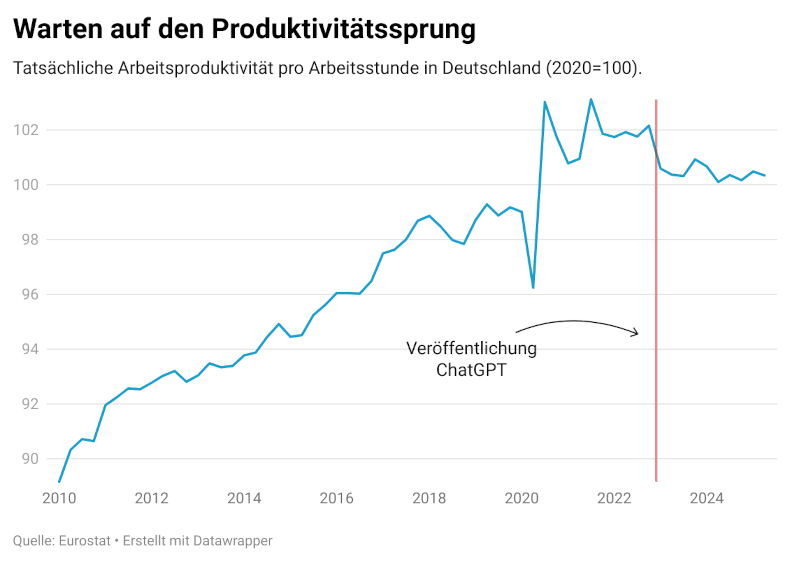

- Routineaufgaben automatisieren – nutzen Sie unsere KI Checkliste – Wo können wir KI effektiv nutzen. Recherche delegieren, Zusammenfassungen erstellen und Entscheidungsgrundlagen verbessern. Mehr zur Effizienzsteigerung und realistischen Produktivität durch KI finden Sie in unserem Beitrag KI und Produktivität: Chancen, Risiken und Studienergebnisse. Dort untersuchen wir, ob Tools wie ChatGPT oder Notion wirklich Arbeit erleichtern.

- Impact: Weniger Aufwand, bessere Qualität ohne grosse Investitionen.

- Risiken: Property Rights, Datenschutz, Compliance früh klären, dokumentieren, klare KI-Guidelines einführen. Für Unternehmen, die eine eigene KI-Richtlinie erstellen oder prüfen wollen, empfehlen wir die Erstellung der Generative KI Richtlinie: Leitfaden zur Umsetzung. Die DrKPI Vorlage erlaubt, Richtlinien für den Betrieb rasch an nationale und internationale Vorgaben anzupassen.

Für effiziente Textbearbeitung und Übersetzungen mit KI empfehlen wir unseren DeepL vs Mistral Ratgeber. Er zeigt, wie Übersetzungen und Textbearbeitungen in wenigen Minuten optimiert werden.

KI Risk 2026 Fazit: Kombiniere technische, rechtliche und vertragliche Massnahmen, um Property Rights zu schützen. Für hochsensible Ideen oder Patente immer lokale Lösungen oder Enterprise-Verträge nutzen. #DrKPI #AICompliance

📘 Praxiswissen zu KI, Produktivität und Strategie

Wir unterstützen Sie dabei, Arbeitsprozesse KI-fit zu machen – von der Kompetenzprüfung über Weiterbildung bis hin zur technischen Umsetzung und Engineering.

Bleib automatisch auf dem Laufenden – neue Beiträge direkt in deinen Feed-Reader.

Ideal für Feedly, Inoreader oder Apple Podcasts.

📜 DrKPI CyTRAP AI-Verantwortlichkeitserklärung: Beitrag mit KI-Unterstützung angepasst; Inhalte wurden geprüft und verantwortet.

Hashtags: #DrKPI #MetricsThatMatter #AIGovernance #CyberSecurity

8 Antworten

Nun wird Google Gemini für Gmail verwendet, und es gibt drei Dinge, die wir beachten müssen:

– Google fügt Gemini-KI-Funktionen zu Gmail hinzu, das mittlerweile mehr als 3 Milliarden Nutzer hat.

– Einige der KI-Funktionen werden standardmäßig in Posteingängen aktiviert, sodass Nutzer sie deaktivieren müssen, wenn sie sie nicht möchten.

– Das Unternehmen gab bekannt, dass Gmail nun E-Mails besser zusammenfassen und Antwortvorschläge unterbreiten kann.

Wenn Sie also nicht möchten, dass Ihre in Gmail gespeicherten E-Mail-Daten bei Google landen, müssen Sie diese Option deaktivieren.

Die neuen KI-Optionen von Gmail werden zunächst nur in englischer Sprache in den Vereinigten Staaten verfügbar sein.

Dieses KI-Upgrade ist keine Überraschung. Es handelt sich um einen Kampf um Marktanteile, da Google mit Microsoft und OpenAI um die größtmögliche Nutzerbasis für Gemini konkurriert und seine neuen Tools und Upgrades schnell in seine verschiedenen Plattformen integriert.

Das andere Upgrade ist eine Überraschung. Google ermöglicht es Nutzern nun, ihre primäre Gmail-Adresse zu ändern, ohne zu einem neuen Konto wechseln zu müssen. Sie behalten alle Ihre Daten und Ihre alte E-Mail-Adresse funktioniert weiterhin, aber Sie bekommen so etwas wie einen Neuanfang.

PS. Die Schätzung für die Anzahl der Gmail Nutzer gehen von 1 Mia. bis 3 Mia. – ich denke das weiss keiner so genau da viele Leute mehr als 1 Adresse auf Gmail haben.

#MetricsThatMatter #DigitalMarketing #DrKPI #AICompliance

Die neuen Gmail-Funktionen basieren auf dem Gemini-Modell und sind Teil von Googles langfristiger Strategie, Künstliche Intelligenz tief in den Alltag sowie in die alltägliche Kommunikation der Nutzer zu integrieren.

Die Potenziale, die Google Gemini für den Alphabet-Konzern eröffnet, sind erheblich.

Mit der Hilfe von mehr als einer Milliarde Nutzern und deren E-Mail-Kommunikation kann Google sein Large Language Model (LLM) Gemini kontinuierlich weiter verbessern und verfeinern.

Die damit verbundenen wirtschaftlichen Vorteile sollten nicht unterschätzt werden. LLMs erzielen in der Regel deutlich bessere Ergebnisse, wenn sie mit grossen Mengen realer, nicht synthetisch erzeugter Daten trainiert werden. Genau diese Datenbasis verschafft Google einen strukturellen Wettbewerbsvorteil.

#MetricsThatMatter #DigitalMarketing #DrKPI #AICompliance

Google ist die am häufigste genutzte Plattform welche E-Mail Hackers und Scammers einsetzen

Die Integration von mehr KI in Gmail birgt jedoch potenzielle Risiken für Google, insbesondere wenn die Technologie fehlerhaft funktioniert und irreführende Informationen liefert oder E-Mails erstellt, die Nutzer in Schwierigkeiten bringen.

Google verspricht, dass keine der von der Technologie analysierten Inhalte zum Trainieren der Modelle verwendet wird, die Gemini bei der Verbesserung helfen. Ich bin gespannt inwiefern dies funktionieren wird.

#MetricsThatMatter #DigitalMarketing #DrKPI #AICompliance

Überprüfen Sie die Sicherheitseinstellungen beim Gmail Konto aber auch auf Google Workspaces:

1. Gehen Sie zu den Gmail-Einstellungen, suchen Sie die Option „Intelligente Funktionen und Personalisierung“ („Smart Features and Personalization“).

2. Deaktivieren Sie diese Funktion.

3. Gehen Sie zu den Google Workspace-Einstellungen unter „Intelligente Funktionen verwalten“ („Manage Smart Features“) und deaktivieren Sie dort ebenfalls die Datenfreigabe.

Dieser zweistufige Vorgang ist bewusst umständlich gestaltet und kein Zufall.

Google weiss, dass sich die meisten Nutzer nicht die Mühe machen werden, sodass ihre Daten frei verfügbar bleiben. Dies macht deutlich, warum es riskant ist, sich in Ihrem digitalen Leben auf zentralisierte Giganten zu verlassen.

Eine Superanleitung mit Screenshots hat Erich Mächler auf seinem Blog

#MetricsThatMatter #DigitalMarketing #DrKPI #AICompliance

Mein Fazit ist angesichts weiterhin begrenzter Versicherbarkeit und ungeklärter Haftungsfragen verpflichtet der EU AI Act Unternehmen dazu, KI-Risiken eigenverantwortlich zu steuern.

Dies erfordert ein systematisches Risikomanagement, klare Governance-Strukturen sowie angemessene technische und organisatorische Maßnahmen entlang des gesamten KI-Lebenszyklus.

Drei zentrale Fakten zum Risikomanagement von KI-Software nach dem EU AI Act wuchtig:

1. Versicherungsschutz ersetzt keine Compliance-Pflichten: Der EU AI Act sieht keinen umfassenden Haftungs- oder Versicherungsausgleich für KI-Fehlfunktionen vor. Insbesondere Fehlleistungen generativer KI (z. B. Halluzinationen) bleiben regelmäßig außerhalb klassischer Versicherungsdeckungen. Unternehmen können sich daher nicht auf Versicherungen verlassen, sondern müssen Risiken präventiv steuern.

2. Haftung bleibt fragmentiert und rollenabhängig: Der EU AI Act differenziert zwischen Anbietern, Deployern (Nutzern) und weiteren Akteuren, regelt jedoch primär ex-ante-Pflichten und nicht abschließend die zivilrechtliche Haftung. Bei fehlerhaften KI-Ausgaben ist die Zurechnung von Schäden weiterhin rechtlich unsicher und abhängig von Vertragsgestaltung, Einsatzkontext und Sorgfaltspflichten.

3. Vertragliche, organisatorische und technische Kontrollen sind zwingend: Unternehmen müssen, insbesondere bei Hochrisiko-Systemen, ein dokumentiertes Risikomanagement etablieren, geeignete Logging- und Nachvollziehbarkeitsmechanismen vorhalten, menschliche Aufsicht sicherstellen sowie Test-, Validierungs- und Produktionsumgebungen trennen. Ergänzend sind vertragliche Regelungen zu Haftung, Informationspflichten und Änderungsmanagement erforderlich.

Danke, Andreas für disen tollen Kommentar. Ja das ist schwierig … darauf zu antworten. Hier mein Versuch.

„Dein Frust ist berechtigt: DSGVO vs. US-Gesetze = Squaring the Circle. Aber es gibt konkrete Wege für KMU:

Der EU AI Act hilft hier nicht – aber technische Souveränität schon. Unser FAQ-Block zeigt: Ohne sie bleibt Compliance ein Wunschtraum.“

→ DrKPI®-Lösungen für KMU

Urs

#DigitalMarketing #AIrisks #DrKPI

Andreas, dein Kommentar trifft den Nagel auf den Kopf. Hier drei praxiserprobte Loesungen, die wir mit Schweizer KMU erfolgreich einsetzen – ohne US-Clouds, ohne BlaBla:

Open-Source-Modelle wie Llama 3 oder Mistral 7B auf Schweizer Hosting (z. B. Infomaniak, Hostpoint, Green.ch).

Beispiel: Ein KMU aus Winterthur nutzt das fuer interne Dokumente – 0% US-Zugriff, 100% DSGVO-konform.

Kosten: ~CHF 100-150/Monat.

Sensible Daten nie direkt in ChatGPT & Co. eingeben. Stattdessen:

– Personendaten mit Python/Excel entfernen

– Nur anonymisierte Daten in KI-Tools laden

Beispiel: Eine Luzerner Kanzlei macht das seit 2023 – 0 Risiko, 100% Compliance.

Jeder KI-Einsatz braucht eine „Kill-Switch“-Regel:

– Sofortige Deaktivierung bei falschen Outputs

– Protokollierung aller Nutzungen (EU AI Act-Nachweis)

Warum? Der EU AI Act bestraft Nichtstun, nicht Fehler.

Fazit: Es geht um kontrolliertes Risiko – nicht um Perfektion.

Wer diese 3 Schritte umsetzt, ist auf der sicheren Seite.

Urs

#DigitalMarketing #AIrisks #DrKPI