Seit der Abstimmung vom 29. September 2025 ist klar, dass die Parkgebühren in Zürichs Blauer Zone bald auf bis zu CHF 650 pro Jahr oder mehr – abhängig von Fahrzeugtyp und Gewicht, steigen werden.

Doch während die Kosten klar sind, bleibt eine Frage offen: Wer haftet, wenn das Auto kein Mensch mehr steuert wie beim Waymo-Robotaxi?

Haftungslücke bei autonomen Fahrzeugen: Der Halter zahlt – aber wer ist der Halter? Aktuell haftet der Halter für Falschparker – doch was gilt, wenn das Fahrzeug selbst entscheidet?

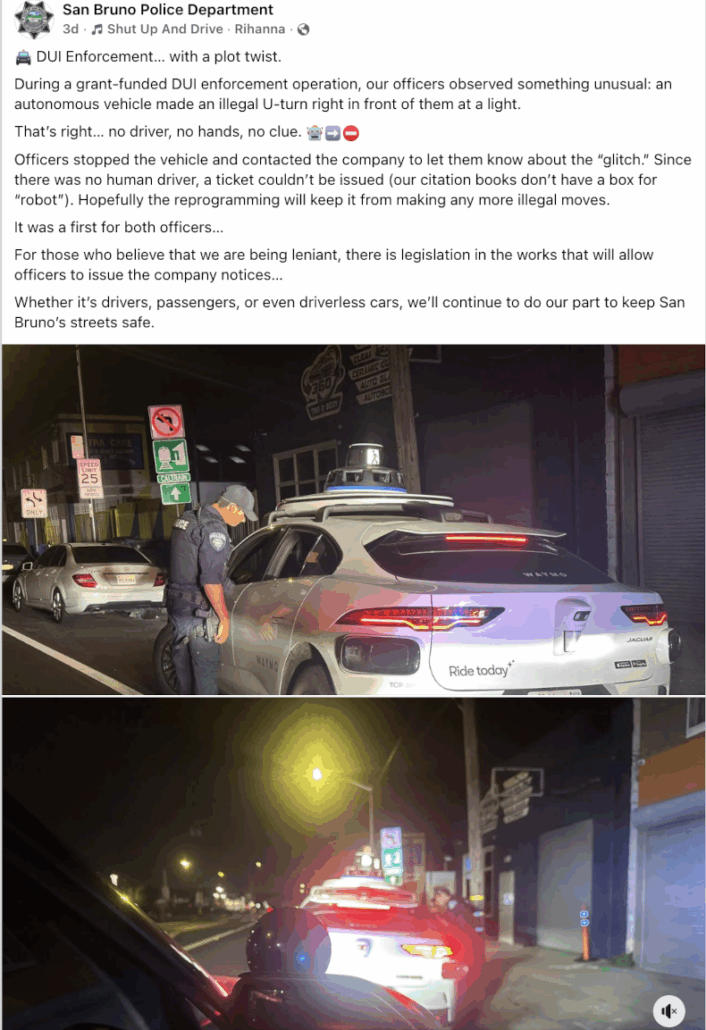

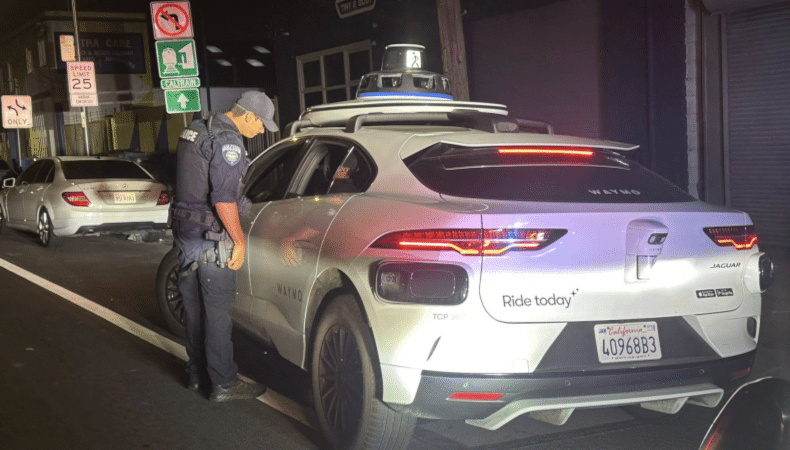

Der Fall eines Waymo Robotaxis in San Bruno (Kalifornien) zeigt die rechtliche Grauzone: Als das Auto vor der Polizei einen illegalen U-Turn machte, konnten die Beamten keinen Strafzettel ausstellen. Grund: „Unsere Formulare haben kein Kästchen für Roboter.„

San Bruno zeigt: Es geht nicht um Formulare – es geht um Vertrauen

Das Problem ist grundsätzlicher als ein fehlendes Kästchen im Bussgeldkatalog. Es geht um soziales Vertrauen in KI-Systeme:

- Wer übernimmt die Verantwortung, wenn Algorithmen handeln?

- Wie können wir sicher sein, dass diese Systeme – ob beim autonomen Parken oder in kritischen Verkehrssituationen – fair, transparent und zuverlässig entscheiden?

📚 Teil unserer Serie über KI und Arbeit:

- KI in der Unternehmenskommunikation: Produktiver oder nur schneller?

- Chatbots im Alltag: Usability-Frust und KI-Grenzen

- KI und Produktivität: Was Studien wirklich zeigen

- Waymo-Robotaxi bricht Regeln – wer haftet? (sie sind hier)

Warum vertrauen wir der Post – aber misstrauen KI-Systemen?

Soziales Vertrauen basiert auf Zuverlässigkeit und Vorhersehbarkeit – ob bei der Post, die seit Jahrzehnten Pakete zustellt, oder bei einer KI, die Verkehrsregeln einhält.

Doch während die Post auf historische Erfahrung zurückgreifen kann, fehlt bei KI oft diese langfristige Gewissheit. Stattdessen müssen Gesetze und Technologien das Vertrauen sichern. Dies geschieht etwa durch Haftungsregeln für autonome Fahrzeuge wie das Waymo Robotaxi.

Doch wie funktioniert dieses Vertrauen, wenn wir die Akteure nicht persönlich kennen? Hier kommt der Unterschied zwischen zwischenmenschlichem und sozialem Vertrauen ins Spiel (siehe auch Baigrie, Oktober 2024).

Wenn wir die Akteure nicht kennen – sei es ein Postbote, ein Algorithmus oder ein Waymo Robotaxi – greift soziales Vertrauen.

Im Gegensatz zu zwischenmenschlichem Vertrauen (das auf direkten Erfahrungen beruht) entsteht soziales Vertrauen durch:

- Kulturelle Prägung wie z.B. Vertrauen in Behörden und Organisationen,

- Historische Erfahrungen wie zuverlässige Infrastruktur,

- Geteilte Normen wie z.B. Verkehrsregeln.

Bruce Schneier (2025) nennt dies „öffentliches /soziales Vertrauen“ – die Fähigkeit, Systemen zu vertrauen, weil sie in verlässliche Rahmen eingebettet sind – sei es durch Regularien wie den EU AI Act oder aber auch technische Sicherheitsstandards.

Wie entsteht Vertrauen in KI? 5 entscheidende Faktoren

Soziales Vertrauen in autonome Systeme wie das Waymo Robotaxi oder KI-gestützte Navigations-Apps basiert auf 5 fünf Säulen.

| Faktor | Beschreibung | Beispiel |

|---|---|---|

| 1. Gesetze und Regularien | Kritischste Bedrohung:Manipulation der KI Ergebnisse Manipulation von KI-Ergebnissen (z. B. Fehldiagnosen oder illegale U-Turns). Regularien wie der EU AI Act sollen dies verhindern. | Illegale U-Turns von Waymo-Taxis (San Bruno, 2025) |

| 2. Überprüfbarkeit | Akzeptanz wird gefördert, wenn Nutzer:innen Ergebnisse einfach nachvollziehen können. | Wetterprognosen mit kurzfristiger Verifizierung |

| 3. Bewertungssysteme | Öffentliche Bewertungen signalisieren Qualität und Zuverlässigkeit des KI-Dienstes. | Sterne-Bewertungen für KI-Dienste (z. B. Uber) |

| 4. Vergleichbarkeit | Nutzer:innen vertrauen KI mehr, wenn sie Leistungen verschiedener Modelle vergleichen können (z. B. Genauigkeit von KI-Modellen). | Vergleich von Wetter-Apps in Echtzeit-Tests |

| 5. Zuverlässigkeit & Gültigkeit | Reliabilität (Konsistenz) und Validität (Richtigkeit) müssen bewiesen werden – z. B. durch korrekte Echtzeit-Daten (Navis, die Baustellen anzeigen). | Navigations-Apps mit live Updates. |

Hinweis: Regularien wie der EU AI Act sind entscheidend, doch ihre Umsetzung bleibt herausfordernd:

- Was gilt als „compliant“ (regelkonformer Einsatz)?

- Wie lassen sich Manipulationen verhindern?

- Wer haftet bei Versagen der KI?

Transparenz allein reicht nicht: 4 Schritte für vertrauenswürdige KI

Dass Unternehmen wie Waymo betonen, ihre 1.400 autonomen Taxis in Kalifornien seien sicher und würden kontinuierlich verbessert, ist notwendig – aber nicht hinreichend. Auch das grösste Schweizer Pilotprojekt für autonomes Fahren im Zürcher Furttal (2025) wirft Fragen auf: Was braucht es, damit wir KI-Systemen wirklich vertrauen?

Die Antwort liegt in 4 zentralen Bausteinen auch für Waymo-Robotaxi Autos:

- Nachvollziehbare Entscheidungen: Wie trifft die KI ihre Wahl? Welche Daten und Algorithmen steuern sie?

- Unabhängige Audits: Nicht nur interne Tests, sondern externe Prüfungen (z. B. durch Behörden) müssen Sicherheit bestätigen.

- Klare Haftungsregeln: Wer trägt die Verantwortung, wenn etwas schiefgeht? Der San Bruno-Vorfall zeigt: Aktuelle rechtliche Rahmen hinken hinterher – statt solche Fälle vorausschauend zu regeln. Eine proaktive Regulierung müsste Haftungsfragen von Anfang an klären, nicht erst im Nachhinein.

- Partizipation der Gesellschaft: Nutzer:innen, Städte und Zivilgesellschaft müssen mitgestalten – nicht nur als Passagiere, sondern als Akteure.

Erst dann können wir KI-Systemen vertrauen – nicht weil sie perfekt sind, sondern weil sie verantwortungsvoll, überprüfbar und im Dienst der Gesellschaft stehen.

Unteres Beispiel von Facebook …. auch auf Instagram von privater Person.

📜DrKPI CyTRAP AI-Verantwortlichkeitserklärung

Dieser Beitrag wurde mit KI-Unterstützung erstellt.

Eigene Recherchen, Erfahrungen und Entwürfe bildeten die Grundlage.

KI diente als Schreibassistenz, nicht als Ghostwriter.

Keine Fakten wurden erfunden, keine Quellen konstruiert.

Die Autorin hat alle Inhalte geprüft und verantwortet die Aussagen.

Das ist für uns: ethisch und transparent mit KI arbeiten.

10 Antworten

KI, hat nicht nur mit Daten sondern auch mit Statistik zu tun.

Wie sehr kann man den Statistiken vertrauen, die KI mithilfe von Suchanfragen liefert?

Dennoch verlassen sich bereits 4 von 5 Verbrauchern bei 40 % ihrer Suchanfragen auf „Zero-Click-Suchergebnisse”.

Lars Danke für den Kommentar

Du schreibst: „4 von 5 Verbrauchern bei 40 % ihrer Suchanfragen auf „Zero-Click-Suchergebnisse.“

Google-Traffic im freien Fall – und KI verschärft das Problem nur noch.

Die Zahlen sind alarmierend: Von 65 % auf 30 % organischer Traffic in nur 5 Jahren. Dies bevor KI-Übersichten oder der KI-Modus überhaupt eingeführt wurden.

Selbst ein Automobilverlag mit Top-Rankings (Platz 1!) verzeichnete 25 % weniger Traffic, obwohl die Sichtbarkeit um 7 % stieg. Das zeigt:

— Mehr Sichtbarkeit ≠ mehr Klicks – Nutzer:innen bleiben öfter auf der SERP.

— Detaillierte Inhalte allein reichen nicht, denn Google, Bing und wie sie alle heissen werden zur Antwortmaschine, nicht zum Tor zum Web.

PS. Zero-Click Suchergebnisser werden genutzt, was weniger Besuche auf Websites bedeutet. Dies trotz manchmal ungenauen Daten oder falschen Antworten.

Frage an die Community

Wie reagiert ihr auf den Traffic-Rückgang?

Setzt ihr auf KI-Optimierung, alternative Kanäle – oder akzeptiert ihr das als „neue Normalität“?

Interessanter Beitrag.

Die Technologie ist schneller als wir denken.

Aber irgendwie schon verrückt was da alles investiert wird und dann funktioniert auch das „relativ einfache Einhalten von Strassenregeln“ nicht.

Danke für den Kommentar. Du hast Recht, dass es überraschend ist, wenn ein Robotaxi Regeln nicht einhält – aber vergleiche mal, wie oft es im Vergleich zu uns Menschen Fehler macht.

Trotzdem haben KI-Firmen grosse Pläne:

OpenAI setzt mit einer 1-Billionen-Dollar-Wette auf seine Zukunft.

Die Verträge über Rechenleistung im Wert von einer Billion Dollar (Leistung wie 20 Kernreaktoren!) werfen Fragen auf:

Das Kapital fehlt, stattdessen bindet zirkuläre Finanzierung Tech-Konzerne an OpenAIs Erfolg. „Fake it till you make it“ – und viele haben „skin in the game“, also viel zu verlieren.

Zum Vergleich: Deutschlands Schulden liegen bei 2,7 Billionen Euro.

Financial Times 25-10-08 UK Ausgabe, S. 10.

OpenAI lockt Big Tech mit einer 1-Billion-Dollar-Wette auf seine Gewinnaussichten

Die Deals beinhalten oft eine zirkuläre Finanzierung, die große Tech-Konzerne an die Fähigkeit von OpenAI bindet, Gewinne zu erzielen (siehe Grafik oben, die zeigt, wie die Unternehmen miteinander verflochten sind, sodass wenn eines scheitert …).

Die Verträge mit OpenAI haben auch den Partnern des Start-ups einen sofortigen finanziellen Aufschwung beschert.

Der Marktwert von Oracle stieg um 244 Milliarden Dollar, nachdem der Vertrag letzten Monat veröffentlicht wurde.

Die AMD-Aktien stiegen am Montag um fast 24 %, wodurch sich der Marktwert des Unternehmens um 63 Milliarden Dollar erhöhte (siehe Chart unten).

Durch die Verträge erhält OpenAI in den nächsten zehn Jahren Zugang zu mehr als 20 Gigawatt Rechenleistung, was in etwa der Leistung von 20 Kernreaktoren entspricht.

Financial Times 25-10-08 UK Ausgabe, S. 10.

Lieber Urs

Meine Meinung über die Robotaxi.

Rechtlich ist hier nichts neues, der Fahrer bzw. der Betreiber ist verantwortlich!

Dieser kann höchstens den Hersteller weiter verklagen. Es braucht hier keine neue Gesetzgebung.

Wenn autonomes Fahren erlaubt wäre, heisst das nur, dass das Fahren erlaubt wäre, aber bei einem Unfall haftet der Fahrer bzw. der Betreiber.

Lieber Gruss

Lieber Göran,

vielen Dank für dein Feedback.

Bezüglich des Beispiels der Waymo-Robotaxis aus San Bruno (Kalifornien) geht es um die praktischen Herausforderungen, die die Polizei bei der Durchsetzung der Verkehrsregeln hat. Deshalb müssen 2 Dinge geregelt werden:

1. Zunächst muss die lokale Bussgeldverordnung angepasst werden.

2. Danach muss die digitale Ausstellung von Bußgeldern bei der Polizei die Möglichkeit einschließen, auch dann eine Buße zu verhängen, wenn kein Fahrer im Fahrzeug sitzt. Derzeit kann die Polizei nur Bussgelder an eine Person ausstellen, die direkt gegen die Straßenverkehrsordnung verstoßen hat.

Grundsätzlich ist dein rechtlicher Ansatz klar und natürlich korrekt: Der Besitzer des Robotaxis ist auch für dessen Einhaltung der Strassenverkehrsordnung verantwortlich und muss folglich die Bussgelder bezahlen.

Freundliche Grüsse,

Urs