KI und Datenqualität sind entscheidend für KMU – nicht nur Unternehmen, sondern auch Schüler, Studierende und staatliche Institutionen wie das Bundesamt für Statistik sammeln kontinuierlich Daten. Diese Informationen bilden die Basis für Entscheidungen, Forschungsergebnisse – und zunehmend für KI-Modelle, die darauf trainiert werden.

Die zentrale Frage lautet: Was passiert, wenn Daten fehlerhaft, unvollständig oder verzerrt sind? Fehlerhafte Daten können KI-Entscheidungen gefährden und langfristig den Geschäftserfolg beeinträchtigen.

📚 Weitere Beiträge aus der Serie „KI und Unternehmenspraxis“

- 🤖 KI in der Unternehmenskommunikation: Produktiver oder nur schneller?

- 💬 Chatbots im Alltag: Usability-Frust und KI-Grenzen

- 📈 KI und Produktivität: Was Studien wirklich zeigen

- 🚖 Waymo-Robotaxi bricht Regeln – wer haftet?

- 👗 KI und Marketing: Fashion und Verkauf

- 🏢 KI für KMU – Was wirklich zählt und welche Trends 2026 entscheiden

- 📊 KI und Datenqualität (sie sind hier)

- 📊 KI und Datenqualität – Teil 2

In diesem Beitrag beantworten wir zwei zentrale Fragen:

- Wie können KMU zuverlässige und genaue Daten generieren?

- Welche Trends in der Datenqualität sind 2026 für KMU entscheidend?

Warum Datenqualität für KI entscheidend ist

KI-Systeme liefern nur dann verlässliche Ergebnisse, wenn die zugrunde liegenden Daten sauber, vollständig und korrekt sind. Mangelhafte Daten führen zu unzuverlässigen Resultaten, Fehlinterpretationen und im schlimmsten Fall zu diskriminierenden Entscheidungen.

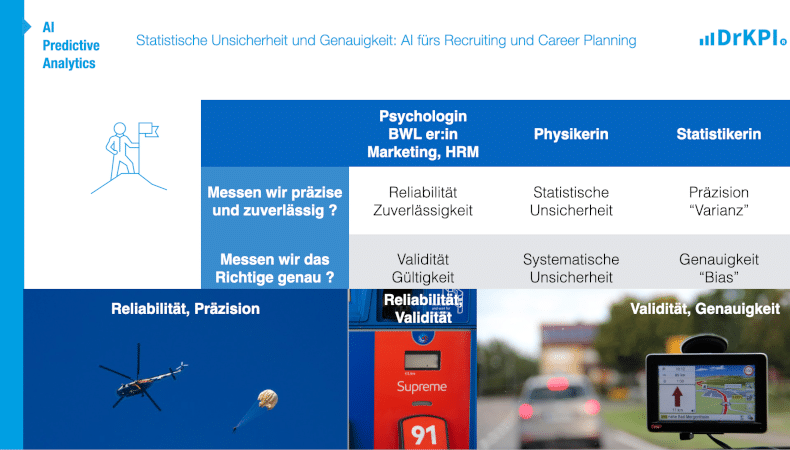

Zwei zentrale Begriffe spielen dabei eine Rolle:

- Reliabilität (Zuverlässigkeit): Wie stabil und reproduzierbar sind die Daten?

- Validität (Genauigkeit): Messen die Daten wirklich das, was sie messen sollen?

Ob in Statistik, Physik, Marketing oder HRM – die Begriffe mögen variieren, die Herausforderung bleibt dieselbe: Datenqualität sicherstellen (siehe Grafik unten).

„What most providers are grappling with now is eliminating hallucinations, which is definitely part of reliability.“

— Marian Croak, VP Engineering bei Google (CACM, August 2025)

Quelle: Embracing Her Critics to Refine VoIP, Communications of the ACM

Croaks Beobachtung zeigt:: Zuverlässigkeit (Reliability) ist nicht nur ein technischer Aspekt, sondern ein Vertrauensanker (siehe Social Trust / soziales Vertrauen).

Wenn KI-Modelle beginnen, „Halluzinationen“ zu produzieren – also Inhalte, die faktisch falsch sind –, liegt das häufig an mangelhafter Datenqualität oder fehlenden Validierungsschritten im Trainingsprozess.

Folie: KI & Datenqualität – Begriffe im Vergleich. 📊 Statistische Unsicherheit, Reliabilität, Validität, Bias & Genauigkeit 💬 Terminologie in HRM, Marketing, Physik und Statistik 🔄 Unterschiedliche Terminologie – gleiche Herausforderungen

Ein Praxisbeispiel aus Schottland

Ein aktueller Fall aus Schottland zeigt, was passieren kann, wenn Daten nicht korrekt erhoben werden:

Bei einer Volkszählung kreuzten italienische Teilnehmende versehentlich die Minderheit „Roma“ an, da sie dachten, es sei ein Herkunftsort. Mehr als 3.000 Personen wurden dadurch fälschlich den Roma-Fahrenden zugeordnet – ein Fehler, den die Statistikbehörde später korrigierte.

Tages-Anzeiger: „Panne bei Volkszählung: Italiener in Schottland verwechseln Rom mit Roma“

(Bildquelle: Tages-Anzeiger, 2025)

Zeitungsartikel im Tages-Anzeiger: Panne bei Volkszählung. Italiener in Schottland verwechseln Rom mit Roma

3 KI Herausforderungen für 2025

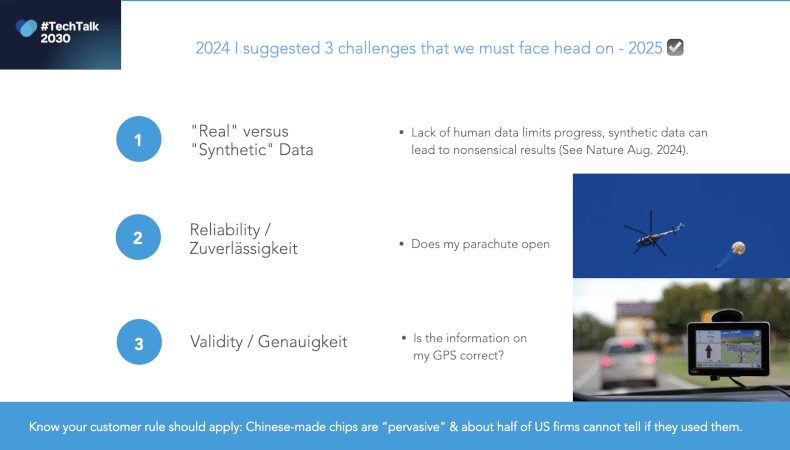

Drei zentrale KI-Herausforderungen für 2026 und darüber hinaus sind:

- Genauigkeit (Accuracy) – Vergleichbar mit einem GPS: Nur präzise Daten führen ans Ziel. Datenqualität

- Echte vs. synthetische Daten – Viele KI-Modelle lernen bereits aus KI-generierten Inhalten. Das führt zu einem Kreislauf, in dem Systeme mit ihrer eigenen Projektion der Realität trainiert werden. Nature (2025) warnt: Wenn KI mit KI-generierten Daten gefüttert wird, entsteht eine „verzerrte Selbstreferenz“, die nach einigen Trainingszyklen unbrauchbare Ergebnisse liefert.

Quelle: Nature, August 2024 - Zuverlässigkeit (Reliabilität) – Wie bei einem Fallschirm: Nur wenn er zuverlässig funktioniert, ist Vertrauen möglich.

Folie – 2025 bestätigt: Drei zentrale KI-Herausforderungen – Datenqualität, Zuverlässigkeit und Genauigkeit.

Zuer Erinnerung: Wenn ein KI-Modell mit KI-generierten Inhalten trainiert wird, wird es „mit seiner eigenen Projektion der Realität vergiftet“ und produziert nach einigen Trainingszyklen Kauderwelsch.

KMU, die jetzt handeln, sichern sich Wettbewerbsvorteile – nicht durch Hype, sondern durch klare Umsetzung. KI muss sich lohnen.

Auch das KMU-Portal der Bundesverwaltung in Bern bietet Informationen zum Thema Künstliche Intelligenz. Doch die Inhalte bleiben allgemein – zentrale Themen wie Datenqualität, Reliabilität und Validität werden kaum behandelt.

🔵 Für KMU: Immer auf dem Laufenden bleiben

Jetzt Newsletter von DrKPI abonnieren und keine Updates zu KI, Trends und Praxisbeispielen verpassen.

📌 Fazit: Datenqualität ist die neue Unternehmenswährung

Für KMU, die KI einsetzen möchten, ist Datenqualität kein Luxus, sondern Grundvoraussetzung. Nur wer Reliabilität, Validität und Bias versteht, kann langfristig von KI profitieren.

Das Jahr 2026 wird zeigen, welche Unternehmen ihre Datengrundlage sichern – und welche auf verzerrte Modelle und fehlerhafte Entscheidungen setzen.

👉 Fortsetzung folgt: Von Daten zu Entscheidungen – wie Organisationen Datenqualität messen, sichern und verbessern.

Praxisnah zeigen wir, wie Sie die Verlässlichkeit Ihrer Daten prüfen, sichern und effektiv für KI nutzen.

📜 DrKPI CyTRAP AI-Verantwortlichkeitserklärung

Dieser Beitrag wurde mit KI-Unterstützung erstellt. Eigene Recherchen, Erfahrungen und Entwürfe bildeten die Grundlage.

KI diente als Schreibassistenz, nicht als Ghostwriter. Keine Fakten wurden erfunden, keine Quellen konstruiert.

Die Autorin hat alle Inhalte geprüft und verantwortet die Aussagen. Das ist für uns: ethisch und transparent mit KI arbeiten.

9 Antworten

Nur als Zusatz…. KI Super-Intelligenz.

Am Mittwoch wurde ein offener Brief veröffentlicht, in dem das Verbot der Entwicklung superintelligenter KI gefordert wird. Der Brief wurde von mehr als 700 Prominenten, KI-Wissenschaftlern, Glaubensführern und Politikern unterzeichnet.

Unter den Unterzeichnern befinden sich fünf Nobelpreisträger, zwei sogenannte „Godfathers of AI“ (Paten der KI), Steve Wozniak, Mitbegründer von Apple, Steve Bannon, enger Vertrauter von Präsident Trump, Paolo Benanti, Berater des Papstes, und sogar Harry und Meghan, Herzog und Herzogin von Sussex.

ANTWORT 1

Danke für den Hinweis.

Ja das isT Wichtig hier meine Input der im Newsletter erscheinen wird diesen Sonntag.

Unten ist die Story mit Links.

ANTWORT 2 aus dem DrKPI Newsletter der am Sonntag erscheinen wird – anklicken und lesen.

🧠 KI ausser Kontrolle?

Immer mehr Fachleute fordern, die Entwicklung von „Superintelligenz“ – also KI-Systemen, die klüger als Menschen sind – vorübergehend zu stoppen. Über 800 Expert:innen, von Geoffrey Hinton bis Stephen Fry, haben den offenen Brief des Future of Life Institute unterzeichnet.

„Der größte Gegner ist nicht die andere Firma oder das andere Land – sondern die Maschinen, die wir selbst bauen.“

– Prof. Max Tegmark (MIT) in der Financial Times

Auch ich habe den Brief unterschrieben, weil KI-Entwicklung Verantwortung braucht, bevor sie Geschwindigkeit bekommt.

👉 Open Letter lesen & unterzeichnen

📄 PDF-Version bei DrKPI herunterladen

Auch aktuelle Untersuchungen zeigen: Selbst KI-Assistenten liefern oft unzuverlässige Daten.

Eine europaweite Medienanalyse der EBU (kurze Zusammenfassung der BBC) ergab, dass 45 % der Antworten von ChatGPT, Copilot, Gemini und Perplexity mindestens ein wesentliches Problem aufwiesen – von falschen Quellen bis zu erfundenen Fakten.

Besonders kritisch:

👉 31 % der Antworten hatten fehlerhafte Quellenangaben, bei

👉 Gemini traten in über 75 % gravierende Probleme auf,

👉 Download der Studie als PDF von DrKPI® BBC-Report-AI-Fehlerquote-beim-Beantworten-von-30-Newsfragen-europaweit.pdf 600 KB.

Das zeigt, wie wichtig geprüfte, saubere Daten sind. Das gilt nicht nur für KI-Modelle, sondern auch um das Vertrauen der Öffentlichkeit insgesamt zu bekommen.

Deloitte gab diesen Monat bekannt, dass es der australischen Regierung einen Teil der Kosten für einen von ihm erstellten Bericht erstatten werde.

Dieser enthielt Fehler, die durch KI auf der Grundlage unzuverlässiger /nicht reliable Daten entstanden waren. Dies verdeutlicht die Risiken für professionelle Dienstleistungsunternehmen.

Danke, Peter 🙏

Ja, ein wachsendes Problem – siehe auch „Work Slop“ (Beschrieb im nächsten Kommentar):

⚙️ Automatisierte Inhalte entstehen schnell und günstig, doch ihre Prüfung und Korrektur ist teuer.

🧩 Interner Schaden: Aufgeblähte, KI-generierte Texte mit unklarer Bedeutung erzeugen Zusatzarbeit.

💸 Effizienzfalle: KI senkt zwar den Aufwand für Pitches und Angebote, aber nicht die Kosten für deren Verarbeitung.

Work Slop oder Workslop

Bezeichnet minderwertige, automatisiert erzeugte Arbeitsprodukte wie z.B. Texte, Berichte oder Präsentationen, welche zwar schnell und günstig erstellt werden, aber wenig Substanz haben.

Sie erhöhen den internen Aufwand, weil Mitarbeitende diese Inhalte prüfen, überarbeiten oder neu strukturieren müssen.

Zeitersparnis gibt es dann oft keine mehr.

Ein Bericht von BetterUp und dem Stanford Social Media Lab prägte den Begriff „Workslop“ für minderwertige, KI-generierte Arbeit, die den Anschein von Fortschritt erweckt, aber korrigiert werden muss.

📊 Verbreitung: In einer Befragung von über 1.000 US-Angestellten gaben

— 40 % an, im letzten Monat Workslop erhalten zu haben; im Schnitt machten solche Inhalte

— 15 % ihrer Arbeit aus.

Besonders betroffen sind Führungskräfte (54 %), und mehr als die Hälfte räumt ein, selbst gelegentlich Workslop weiterzugeben – quer durch alle Hierarchieebenen.

⏱️ Kosten: Jeder Vorfall verursacht im Schnitt fast 2 Stunden Zusatzarbeit – rund 186 US-Dollar pro Mitarbeiter und Monat.

🤝 Vertrauen: Etwa die Hälfte bewertete Kollegen, die Workslop verschicken, als weniger kreativ, fähig und zuverlässig.

⚙️ Ursache: Workslop entsteht, wenn KI als Abkürzung statt als Werkzeug zur Verbesserung genutzt wird.

Der Bericht empfiehlt Führungskräften, klare Qualitätsstandards zu setzen und KI gezielt als Kollaborationsinstrument einzusetzen.

„Work Slop” und professionelle Wirtschaftsprüfungsgesellschaften

Der Financial Reporting Council, die britische Aufsichtsbehörde für Wirtschaftsprüfer, warnte im Sommer, dass die vier grossen Wirtschaftsprüfungsgesellschaften es versäumten, mit KI ersteller Arbeiten oder Audits genau zu überwachen.

Speziell wichtig sei hier wie sich automatisierte Tools und KI auf die Qualität ihrer Prüfungen auswirken. Dies insbesonders, da die Unternehmen den Einsatz dieser Technologien zur Durchführung von Risikobewertungen und zur Beschaffung von Nachweisen verstärken.

Big Accountancy firms fail to monitor AI use in their audit work and its impact on audit quality